《python爬虫》专题

-

刮擦蜘蛛停止爬行

我试着在一个. asp网站上运行一个蜘蛛,它需要登录授权和一些爬行到同一个网站内的不同页面。我昨天成功地使用我的蜘蛛登录,并正在用不同的功能抓取数据,当我在更改了as功能后再次运行蜘蛛时,蜘蛛停止了工作。我不知道发生了什么,我对网络抓取相当陌生。下面是代码: 以下是日志: 代码曾经能够尝试从页面中抓取一些我想要的数据,但没有成功,但我相信这只是因为我使用了错误的css选择器。现在它只是打开和关闭而

-

粗糙的蜘蛛不爬行

我正试着测试这只痒痒的爬行蜘蛛,但我不明白它为什么不爬行。它应该做的是在wikipedia的数学页面上爬行一个深度级别,然后返回每个爬行页面的标题。我错过了什么?非常感谢您的帮助! 设置: 日志:

-

10. Selenium爬取淘宝商品

① 案例要求 使用Selenium爬取淘宝商品,指定关键字和指定页码信息来进行爬取 ② 案例分析: url地址:https://s.taobao.com/search?q=ipad ③ 具体代码实现 '''通过关键字爬取淘宝网站的信息数据''' from selenium import webdriver from selenium.common.exceptions import Timeout

-

19. Ajax信息爬取实战

Ajax = 异步 JavaScript 和 XML(标准通用标记语言的子集)。 Ajax 是一种用于创建快速动态网页的技术。 Ajax 是一种在无需重新加载整个网页的情况下,能够更新部分网页的技术。 案例:爬取京东指定商品信息的评论信息 #爬取指定京东商品的评论信息 import requests import re # header头信息 headers = { 'User-Agen

-

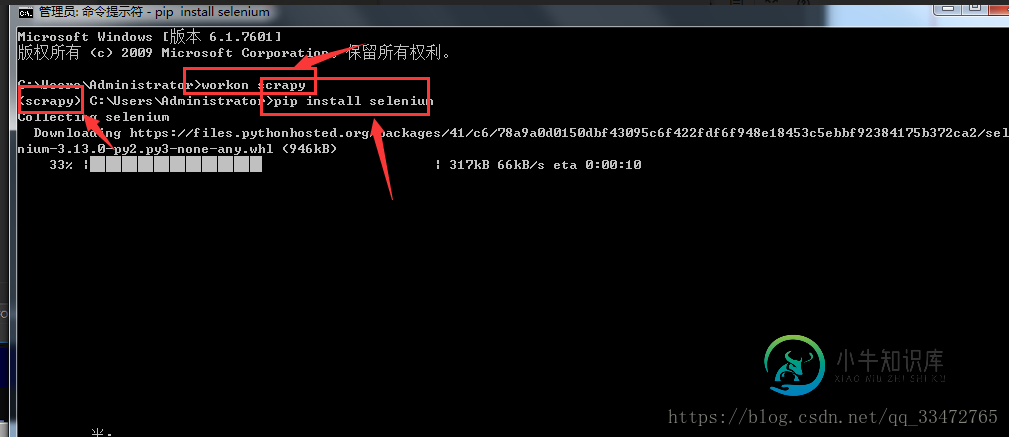

scrapy与selenium结合爬取数据(爬取动态网站)的示例代码

scrapy与selenium结合爬取数据(爬取动态网站)的示例代码本文向大家介绍scrapy与selenium结合爬取数据(爬取动态网站)的示例代码,包括了scrapy与selenium结合爬取数据(爬取动态网站)的示例代码的使用技巧和注意事项,需要的朋友参考一下 scrapy框架只能爬取静态网站。如需爬取动态网站,需要结合着selenium进行js的渲染,才能获取到动态加载的数据。 如何通过selenium请求url,而不再通过下载器Downloader去请求

-

python selenium网页爬虫多线程并发执行偶尔会报错,请问是什么原因?

公司有个需求需要将动态html保存为pdf文件,准备用python+selenium实现。调用chromedriver的Page.printToPdf命令,在页面加载完成后获取打印的response,最后转为pdf保存。考虑到并发性,用多线程模拟测试发现偶尔会出现报错,单个执行又没问题,不知道啥原因 python 3.9.0 selenium 4.16.0

-

python requests库爬取豆瓣电视剧数据并保存到本地详解

python requests库爬取豆瓣电视剧数据并保存到本地详解本文向大家介绍python requests库爬取豆瓣电视剧数据并保存到本地详解,包括了python requests库爬取豆瓣电视剧数据并保存到本地详解的使用技巧和注意事项,需要的朋友参考一下 首先要做的就是去豆瓣网找对应的接口,这里就不赘述了,谷歌浏览器抓包即可,然后要做的就是分析返回的json数据的结构: https://movie.douban.com/j/search_subjects?

-

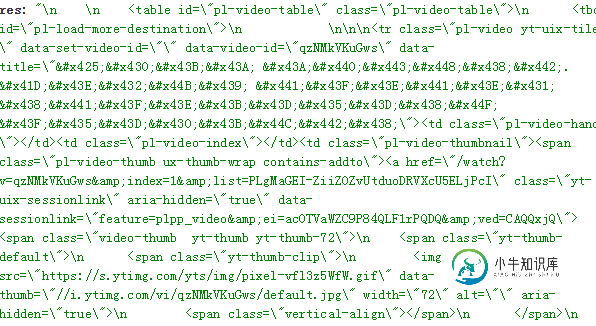

nodejs爬虫抓取数据之编码问题

nodejs爬虫抓取数据之编码问题本文向大家介绍nodejs爬虫抓取数据之编码问题,包括了nodejs爬虫抓取数据之编码问题的使用技巧和注意事项,需要的朋友参考一下 cheerio DOM化并解析的时候 1.假如使用了 .text()方法,则一般不会有html实体编码的问题出现 2.如果使用了 .html()方法,则很多情况下(多数是非英文的时候)都会出现,这时,可能就需要转义一番了 类似这些 因为需要作数据存储,所有需要转换 大

-

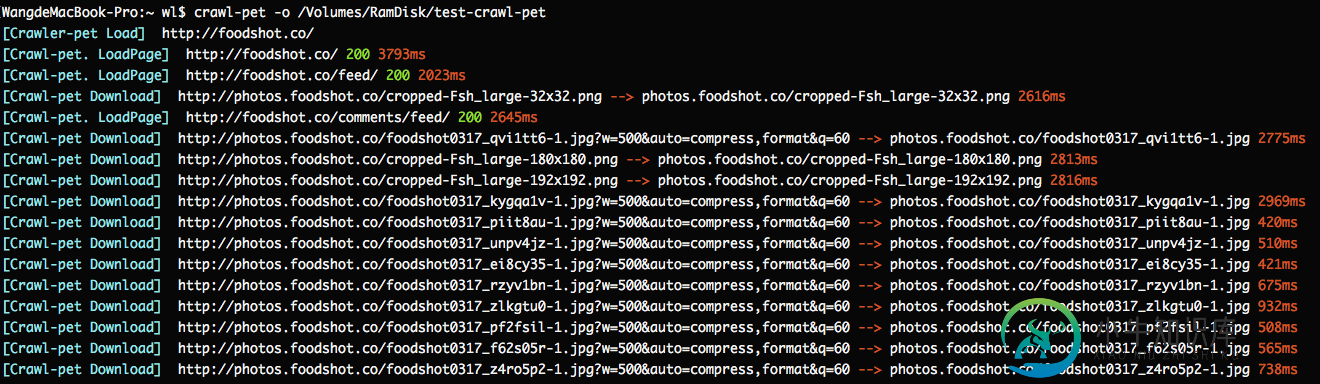

简单好用的nodejs 爬虫框架分享

简单好用的nodejs 爬虫框架分享本文向大家介绍简单好用的nodejs 爬虫框架分享,包括了简单好用的nodejs 爬虫框架分享的使用技巧和注意事项,需要的朋友参考一下 这个就是一篇介绍爬虫框架的文章,开头就不说什么剧情了。什么最近一个项目了,什么分享新知了,剧情是挺好,但介绍的很初级,根本就没有办法应用,不支持队列的爬虫,都是耍流氓。 所以我就先来举一个例子,看一下这个爬虫框架是多么简单并可用。 第一步:安装 Crawl-pet

-

PHP一个简单的无需刷新爬虫

本文向大家介绍PHP一个简单的无需刷新爬虫,包括了PHP一个简单的无需刷新爬虫的使用技巧和注意事项,需要的朋友参考一下 由于只是一个小示例,所以过程化简单写了,小菜随便参考,大神大可点解 接下的入表库当然就不写了,那些更小意思了~就此别过吧~ 总结 以上就是这篇文章的全部内容了,希望本文的内容对大家的学习或者工作具有一定的参考学习价值,谢谢大家对呐喊教程的支持。如果你想了解更多相关内容请查看下面相

-

PHP+HTML+JavaScript+Css实现简单爬虫开发

PHP+HTML+JavaScript+Css实现简单爬虫开发本文向大家介绍PHP+HTML+JavaScript+Css实现简单爬虫开发,包括了PHP+HTML+JavaScript+Css实现简单爬虫开发的使用技巧和注意事项,需要的朋友参考一下 开发一个爬虫,首先你要知道你的这个爬虫是要用来做什么的。我是要用来去不同网站找特定关键字的文章,并获取它的链接,以便我快速阅读。 按照个人习惯,我首先要写一个界面,理清下思路。 1、去不同网站。那么我们需

-

PHP代码实现爬虫记录——超管用

本文向大家介绍PHP代码实现爬虫记录——超管用,包括了PHP代码实现爬虫记录——超管用的使用技巧和注意事项,需要的朋友参考一下 实现爬虫记录本文从创建crawler 数据库,robot.php记录来访的爬虫从而将信息插入数据库crawler,然后从数据库中就可以获得所有的爬虫信息。实现代码具体如下: 数据库设计 以下文件 robot.php 记录来访的爬虫,并将信息写入数据库: 成功了,现在访问数

-

python3之微信文章爬虫实例讲解

本文向大家介绍python3之微信文章爬虫实例讲解,包括了python3之微信文章爬虫实例讲解的使用技巧和注意事项,需要的朋友参考一下 前提: python3.4 windows 作用:通过搜狗的微信搜索接口http://weixin.sogou.com/来搜索相关微信文章,并将标题及相关链接导入Excel表格中 说明:需xlsxwriter模块,另程序编写时间为2017/7/11,以免之后程序无

-

分享一个简单的java爬虫框架

本文向大家介绍分享一个简单的java爬虫框架,包括了分享一个简单的java爬虫框架的使用技巧和注意事项,需要的朋友参考一下 反复给网站编写不同的爬虫逻辑太麻烦了,自己实现了一个小框架 可以自定义的部分有: 请求方式(默认为Getuser-agent为谷歌浏览器的设置),可以通过实现RequestSet接口来自定义请求方式 储存方式(默认储存在f盘的html文件夹下),可以通过SaveUtil接口来

-

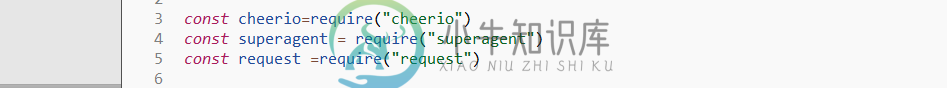

node实现爬虫的几种简易方式

node实现爬虫的几种简易方式本文向大家介绍node实现爬虫的几种简易方式,包括了node实现爬虫的几种简易方式的使用技巧和注意事项,需要的朋友参考一下 说到爬虫大家可能会觉得很NB的东西,可以爬小电影,羞羞图,没错就是这样的。在node爬虫方面,我也是个新人,这篇文章主要是给大家分享几种实现node 爬虫的方式。第一种方式,采用node,js中的 superagent+request + cheerio。cheerio是必须