《python爬虫》专题

-

如何使用Selenium和Python通过爬虫测试非标准下拉列表

我在一个大学的项目,建立一个网页的cralwer。现在我在网页中遇到了测试下拉列表。具体地说,下面的页面没有使用标准的“Dropdown”类。

-

python - 爬虫代理反向代理管理面板有哪些技术选型?

爬虫代理反向代理管理面板有哪些技术选型? 需求:爬虫业务,有多个代理 ip 供应商,但是这些供应商没有监控:实时使用的带宽、流量、连接数等等指标 但是我们自己需要监控 有哪些工具可以做这个?openresty?

-

python - 爬虫requests.get无限刷新加载,呈现卡死特征,如何处理?

初学者一个,爬取某网站url html=requests.get(url=url).text#,headers=headers,timeout=10 一直卡主不返回,加上headers timeout无效,代码改为 原来并不是卡死,而是在加载完成后还在无限加载 如何在初次加载完成后立即返回不再重复加载,手动点击stop按钮即可返回,如何在初次加载完成后立即返回不再重复加载,手动点击stop按钮即可

-

带爬行器的爬行器初始化中的参数

我想用蜘蛛爬虫代码来获取一些房地产数据。但它一直给我这个错误: 回溯(最近一次呼叫最后一次): 文件“//anaconda/lib/python2.7/site packages/twisted/internet/defer.py”,第1301行,in_inlineCallbacks result=g.send(result) 文件“//anaconda/lib/python2.7/site pa

-

有没有专业搞python爬虫的,对于动态网页怎么爬取,可以私信我,有偿,有没有高效地方法?

最近在学习爬虫,遇到一个动态页面内容的网页,我虽然有办法将它转为html代码,但是效率实在可怜。求一个专业的大神,有偿支持我。

-

Nutch 1.11爬网问题

我已经遵循了教程,并使用Cygwin将nutch配置为在Windows 7上运行,我正在使用Solr 5.4.0对数据进行索引 但是坚果1.11在执行爬行时遇到了问题。 爬网命令 $ bin/crawl -i -D solr.server.url= 错误/异常 注入种子网址 /apache-nutch-1.11/bin/坚果注射 /测试爬网/抓取 /urls 注射器:从 2016-01-19 开始

-

JavaScript算法-爬楼梯

假设你正在爬楼梯。需要 n 阶你才能到达楼顶。 每次你可以爬 1 或 2 个台阶。你有多少种不同的方法可以爬到楼顶呢? 注意:给定 n 是一个正整数。 示例 1: 输入: 2 输出: 2 解释: 有两种方法可以爬到楼顶。 1. 1 阶 + 1 阶 2. 2 阶 示例 2: 输入: 3 输出: 3 解释: 有三种方法可以爬到楼顶。 1. 1 阶 + 1 阶 + 1 阶 2. 1 阶 + 2

-

借助Firefox来爬取

这里介绍一些使用Firefox进行爬取的点子及建议,以及一些帮助爬取的Firefox实用插件。 在浏览器中检查DOM的注意事项 Firefox插件操作的是活动的浏览器DOM(live browser DOM),这意味着当您检查网页源码的时候, 其已经不是原始的HTML,而是经过浏览器清理并执行一些Javascript代码后的结果。 Firefox是个典型的例子,其会在table中添加 <tbody

-

以Python的Pyspider为例剖析搜索引擎的网络爬虫实现方法

本文向大家介绍以Python的Pyspider为例剖析搜索引擎的网络爬虫实现方法,包括了以Python的Pyspider为例剖析搜索引擎的网络爬虫实现方法的使用技巧和注意事项,需要的朋友参考一下 在这篇文章中,我们将分析一个网络爬虫。 网络爬虫是一个扫描网络内容并记录其有用信息的工具。它能打开一大堆网页,分析每个页面的内容以便寻找所有感兴趣的数据,并将这些数据存储在一个数据库中,然后对其他网页进行

-

Python爬虫实现网页信息抓取功能示例【URL与正则模块】

本文向大家介绍Python爬虫实现网页信息抓取功能示例【URL与正则模块】,包括了Python爬虫实现网页信息抓取功能示例【URL与正则模块】的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了Python爬虫实现网页信息抓取功能。分享给大家供大家参考,具体如下: 首先实现关于网页解析、读取等操作我们要用到以下几个模块 我们可以尝试一下用readline方法读某个网站,比如说百度 下面我们说一

-

python3.x - 怎么解决python 爬虫运行多进程报错:TypeError: cannot pickle '_thread.lock' object?

python 爬虫运行多进程报错:TypeError: cannot pickle '_thread.lock' object 怎么解决python 爬虫运行多进程报错:TypeError: cannot pickle '_thread.lock' object

-

去旅游爬虫运动麻烦

问题内容: 我正在进行巡回演出,我觉得除了并发以外,我对这种语言有很好的理解。 在幻灯片72上,有一个练习,要求读者并行化Web爬网程序(并使其不覆盖重复的内容,但我还没有到达那里。) 这是我到目前为止的内容: 我的问题是在哪里打电话。如果我在方法中的某个地方放置了一个对象,那么我最终会在其中一个生成的goroutine中写入一个封闭的通道,因为该方法将在生成的goroutine之前完成执行。 如

-

NodeJS制作爬虫全过程(续)

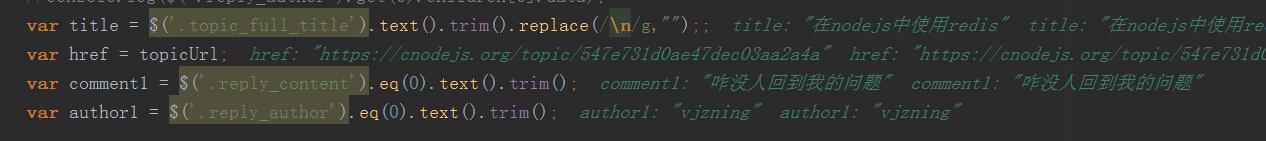

NodeJS制作爬虫全过程(续)本文向大家介绍NodeJS制作爬虫全过程(续),包括了NodeJS制作爬虫全过程(续)的使用技巧和注意事项,需要的朋友参考一下 书接上回,我们需要修改程序以达到连续抓取40个页面的内容。也就是说我们需要输出每篇文章的标题、链接、第一条评论、评论用户和论坛积分。 如图所示,$('.reply_author').eq(0).text().trim();得到的值即为正确的第一条评论的用户。 {<1>}

-

nodeJs爬虫的技术点总结

本文向大家介绍nodeJs爬虫的技术点总结,包括了nodeJs爬虫的技术点总结的使用技巧和注意事项,需要的朋友参考一下 背景 最近打算把之前看过的nodeJs相关的内容在复习下,顺便写几个爬虫来打发无聊,在爬的过程中发现一些问题,记录下以便备忘。 依赖 用到的是在网上烂大街的cheerio库来处理爬取的内容,使用superagent处理请求,log4js来记录日志。 日志配置 话不多说,直接上代码

-

围棋之旅练习#10:爬虫

我正在进行围棋之旅,我觉得除了并发性之外,我对这门语言有很好的理解。 幻灯片10是一个练习,要求读者并行化一个网络爬虫(并使其不覆盖重复,但我还没有做到。) 以下是我到目前为止的情况: 我的问题是,在哪里我把调用。 如果我在方法中的某个地方放置了,那么程序最终会从一个派生的goroutine写入一个闭合通道,因为对的调用将在派生的goroutine执行之前返回。 如果我省略了对的调用,正如我所演示