《Jupyter》专题

-

如何连接到远程Jupyter笔记本服务器?[关闭]

问题内容: 关闭。 此问题不符合堆栈溢出准则。它当前不接受答案。 想改善这个问题吗? 更新问题,使其成为Stack Overflow的主题。 2年前关闭。 改善这个问题 我想在我可以访问的计算机上运行服务器,并且已经能够在本地运行笔记本计算机。 如何设置以便可以 远程 访问? 问题答案: 如果您具有ssh访问将运行服务器的计算机的权限,请执行以下步骤: 1)在将运行 服务器 的机器上,执行: 2)

-

具有Python 3.8的Jupyter Notebook-NotImplementedError

问题内容: 最近升级到Python 3.8,并已安装。但是,当尝试运行时出现以下错误: 我知道默认情况下Windows上的Python 3.8已切换为默认设置,因此我怀疑它与此相关。 Jupyter目前不支持Python 3.8?有没有解决的办法? 问题答案: 编辑 此问题存在于较早的Jupyter Notebook版本中,并已在 6.0.3 版(2020年1月21日发行)中修复。要升级到最新版本

-

AWS EMR纱线簇上的Jupyterhub pyspark3

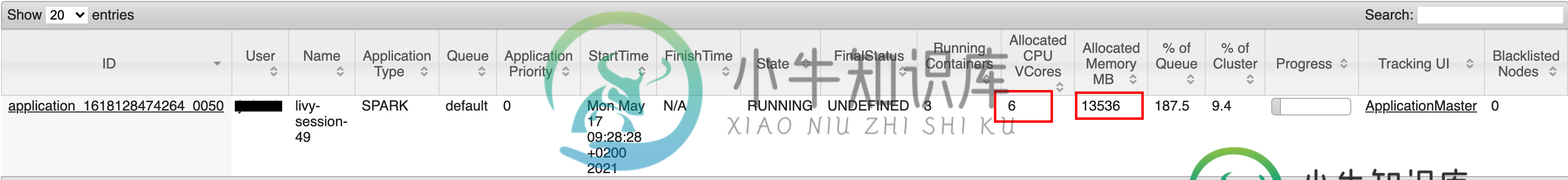

AWS EMR纱线簇上的Jupyterhub pyspark3我正在AWS EMR集群上使用pyspark3内核运行Jupyterhub。正如我们可能知道的那样,EMR上的Jupyterhub pyspark3使用Livy会话在AWS EMR YARN调度程序上运行工作负载。我的问题是关于火花的配置:执行器内存/内核、驱动程序内存/内核等。 配置中已经有默认配置。Jupyter的json文件: 我们可以改写此配置使用spackMagic: 火花默认值中也有配

-

无法使用pip3安装jupyter

无法获取URLhttps://pypi.python.org/simple/jupyter/:确认ssl证书时出现问题:[ssl:certificate\u VERIFY\u FAILED]certificate VERIFY FAILED(\u ssl.c:748)-跳过 我使用的是Windows 7机器,Python 3.6版本和pip版本是9.0.1。

-

如何增加Jupyter笔记本的内存限制?

问题内容: 我在Windows 10上使用带Python3的jupyter笔记本。我的计算机具有8GB RAM,至少4GB RAM是可用的。 但是当我想使用以下命令制作大小为6000 * 6000的numpy ndArray时 : 我认为这不会使用超过100MB的RAM。我试图更改数字以查看发生了什么。我可以做的最大数组是(5000,5000)。在估计需要多少RAM时是否犯了错误? 问题答案: J

-

Jupyter Notebook中的TensorFlow出现问题

问题内容: 我之前通过Anaconda在Ubuntu 14.04中安装了Jupyter笔记本,而现在我安装了TensorFlow。我希望TensorFlow能够正常工作,而不管我是在笔记本中还是在简单地编写脚本。为了实现这一目标,我最终两次安装了TensorFlow,一次使用Anaconda,一次使用pip。Anaconda安装工作正常,但我需要在对python的任何调用之前加上“源代码激活ten

-

如何与非程序员共享Jupyter笔记本?

问题内容: 我试图用Jupyter做我不能做的事情。 我的内部服务器上运行着Jupyter服务器,可通过VPN和受密码保护的服务器进行访问。 我是唯一实际创建笔记本的人,但是我想以只读方式使其他团队成员可以看到一些笔记本。理想情况下,我可以与他们共享一个URL,当他们想查看带有刷新数据的笔记本时,他们将为其添加书签。 我看到了导出选项,但找不到任何有关“发布”或“公开”本地现场笔记本的信息。这不可

-

jupyter notebook 写代码自动补全的实现

jupyter notebook 写代码自动补全的实现本文向大家介绍jupyter notebook 写代码自动补全的实现,包括了jupyter notebook 写代码自动补全的实现的使用技巧和注意事项,需要的朋友参考一下 操作步骤 进入命令行环境。我使用的是conda。有两种方式进入命令行。 方法1:通过anconda navigator界面,选择environments,选择对应环境名,选择open terminal 方法2:直接使用cmd或者

-

如何在Jupyter笔记本中以编程方式生成markdown输出?

问题内容: 我想为Jupyter笔记本中的班级写一份报告。我想计算一些东西,生成一些结果,并将它们包括在markdown中。我可以将单元格的输出设置为降价吗? 我想要这样的命令:生成phi符号,就像在markdown中一样。 换句话说,我想在markdown中制作一个模板,并插入由笔记本中编写的程序生成的值。重新计算笔记本应生成新结果,并插入新值并进行新的减价。使用此软件是否可能,或者我需要自己替

-

如何为Django设置Jupyter / IPython Notebook?

问题内容: 我一直在使用中描述的方法,这个职位设立IPython的笔记本电脑与Django的发挥很好。该方法的要点是创建一个IPython扩展,该扩展设置DJANGO_SETTINGS_MODULE并在IPython启动时运行django.setup()。 该扩展的代码是: 在最近升级到Jupyter Notebook的情况下,此设置对我而言已无效。通过在笔记本的第一个单元格中添加类似的代码,我可

-

Jupyter notebook运行Spark+Scala教程

Jupyter notebook运行Spark+Scala教程本文向大家介绍Jupyter notebook运行Spark+Scala教程,包括了Jupyter notebook运行Spark+Scala教程的使用技巧和注意事项,需要的朋友参考一下 今天在intellij调试spark的时候感觉每次有新的一段代码,都要重新跑一遍,如果用spark-shell,感觉也不是特别方便,如果能像python那样,使用jupyter notebook进行编程就很方便了

-

jupyter notebook清除输出方式

jupyter notebook清除输出方式本文向大家介绍jupyter notebook清除输出方式,包括了jupyter notebook清除输出方式的使用技巧和注意事项,需要的朋友参考一下 在 jupyter notebook参数化运行python 时,怕输出太多文件太大,想及时清除 notebook 的输出。 在别人代码里看到用 easydl 的 clear_output()。调用很简单: 查它源码:clear_output ter

-

jupyter notebook参数化运行python方式

jupyter notebook参数化运行python方式本文向大家介绍jupyter notebook参数化运行python方式,包括了jupyter notebook参数化运行python方式的使用技巧和注意事项,需要的朋友参考一下 Updates (2019.8.14 19:53)吃饭前用这个方法实战了一下,吃完回来一看好像不太行:跑完一组参数之后,到跑下一组参数时好像没有释放之占用的 GPU,于是 notebook 上的结果,后面好几条都报错说

-

如何在Python中设置gamma值(jupyter笔记本)

当我运行这个代码时,我有一个警告。 !!! 警告如下!!! C:\Users#\Anaconda3\lib\site packages\sklearn\svm\base.py:193:futurearning: 如何避免这种警告?或者如何将gamma的值设置为缩放?

-

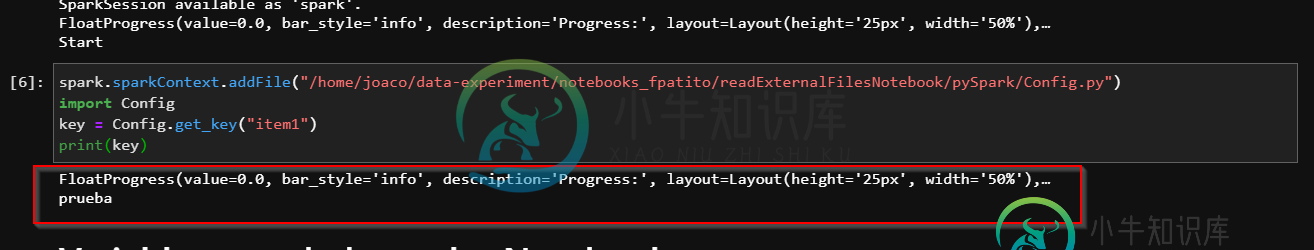

在jupyter笔记本中导入自定义scala对象,ontext.add文件

在jupyter笔记本中导入自定义scala对象,ontext.add文件我有一个Jupyter笔记本,我试图将一个键作为字符串从外部函数导入。在pyspark中,所有代码都可以正常工作 配置。py 在笔记本上打电话: 但是,当我尝试在Scala Spark中做同样的事情时,笔记本会给我一个未找到的错误 "未找到:value testMap" 测试图。斯卡拉 我在做同样的火花ontext.addfile: 这个导入: