《爬虫》专题

-

Python爬虫框架scrapy实现的文件下载功能示例

本文向大家介绍Python爬虫框架scrapy实现的文件下载功能示例,包括了Python爬虫框架scrapy实现的文件下载功能示例的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了Python爬虫框架scrapy实现的文件下载功能。分享给大家供大家参考,具体如下: 我们在写普通脚本的时候,从一个网站拿到一个文件的下载url,然后下载,直接将数据写入文件或者保存下来,但是这个需要我们自己一点一

-

Python爬虫之正则表达式基本用法实例分析

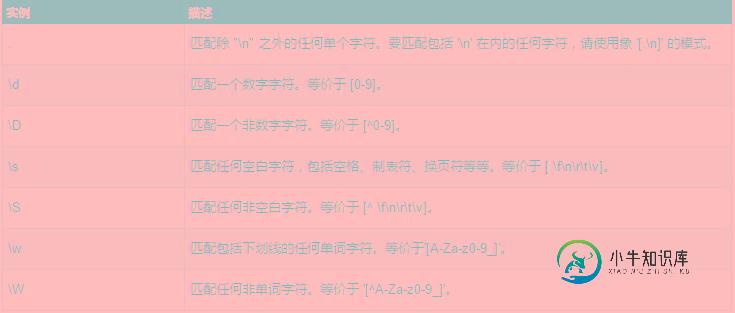

Python爬虫之正则表达式基本用法实例分析本文向大家介绍Python爬虫之正则表达式基本用法实例分析,包括了Python爬虫之正则表达式基本用法实例分析的使用技巧和注意事项,需要的朋友参考一下 本文实例讲述了Python爬虫之正则表达式基本用法。分享给大家供大家参考,具体如下: 一、简介 正则表达式,又称正规表示式、正规表示法、正规表达式、规则表达式、常规表示法(英语:Regular Expression,在代码中常简写为regex、re

-

Python爬虫抓取代理IP并检验可用性的实例

本文向大家介绍Python爬虫抓取代理IP并检验可用性的实例,包括了Python爬虫抓取代理IP并检验可用性的实例的使用技巧和注意事项,需要的朋友参考一下 经常写爬虫,难免会遇到ip被目标网站屏蔽的情况,银次一个ip肯定不够用,作为节约的程序猿,能不花钱就不花钱,那就自己去找吧,这次就写了下抓取 西刺代理上的ip,但是这个网站也反爬!!! 至于如何应对,我觉得可以通过增加延时试试,可能是我抓取的太

-

Python使用Beautiful Soup包编写爬虫时的一些关键点

本文向大家介绍Python使用Beautiful Soup包编写爬虫时的一些关键点,包括了Python使用Beautiful Soup包编写爬虫时的一些关键点的使用技巧和注意事项,需要的朋友参考一下 1.善于利用soup节点的parent属性 比如对于已经得到了如下html代码: 的soup变量eachMonthHeader了。 想要提取其中的 Month的label的值:November 和Ye

-

Python的爬虫包Beautiful Soup中用正则表达式来搜索

本文向大家介绍Python的爬虫包Beautiful Soup中用正则表达式来搜索,包括了Python的爬虫包Beautiful Soup中用正则表达式来搜索的使用技巧和注意事项,需要的朋友参考一下 Beautiful Soup使用时,一般可以通过指定对应的name和attrs去搜索,特定的名字和属性,以找到所需要的部分的html代码。 但是,有时候,会遇到,对于要处理的内容中,其name或att

-

Java爬虫实战抓取一个网站上的全部链接

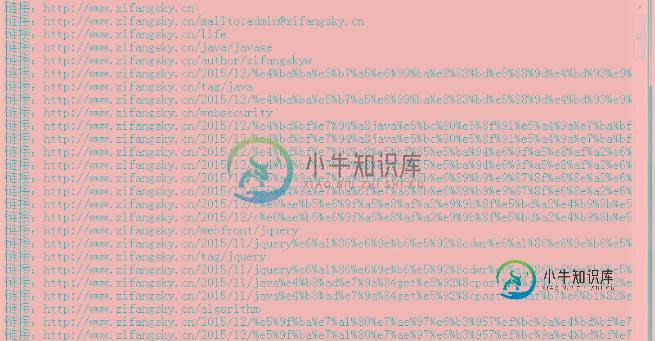

Java爬虫实战抓取一个网站上的全部链接本文向大家介绍Java爬虫实战抓取一个网站上的全部链接,包括了Java爬虫实战抓取一个网站上的全部链接的使用技巧和注意事项,需要的朋友参考一下 前言:写这篇文章之前,主要是我看了几篇类似的爬虫写法,有的是用的队列来写,感觉不是很直观,还有的只有一个请求然后进行页面解析,根本就没有自动爬起来这也叫爬虫?因此我结合自己的思路写了一下简单的爬虫。 一 算法简介 程序在思路上采用了广度优先算法,对未遍历过

-

python爬虫获取小区经纬度以及结构化地址

本文向大家介绍python爬虫获取小区经纬度以及结构化地址,包括了python爬虫获取小区经纬度以及结构化地址的使用技巧和注意事项,需要的朋友参考一下 本文实例为大家分享了python爬虫获取小区经纬度、地址的具体代码,供大家参考,具体内容如下 通过小区名称利用百度api可以获取小区的地址以及经纬度,但是由于api返回的值中的地址形式不同,所以可以首先利用小区名称进行一轮爬虫,获取小区的经纬度,然

-

python爬虫_实现校园网自动重连脚本的教程

python爬虫_实现校园网自动重连脚本的教程本文向大家介绍python爬虫_实现校园网自动重连脚本的教程,包括了python爬虫_实现校园网自动重连脚本的教程的使用技巧和注意事项,需要的朋友参考一下 一、背景 最近学校校园网不知道是什么情况,总出现掉线的情况。每次掉线都需要我手动打开web浏览器重新进行账号密码输入,重新进行登录。系统的问题我没办法解决,但是可以写一个简单的python脚本用于自动登录校园网。每次掉线后,再打开任意网页就是这

-

使用Python的Scrapy框架编写web爬虫的简单示例

本文向大家介绍使用Python的Scrapy框架编写web爬虫的简单示例,包括了使用Python的Scrapy框架编写web爬虫的简单示例的使用技巧和注意事项,需要的朋友参考一下 在这个教材中,我们假定你已经安装了Scrapy。假如你没有安装,你可以参考这个安装指南。 我们将会用开放目录项目(dmoz)作为我们例子去抓取。 这个教材将会带你走过下面这几个方面: 创造一个新的Scrapy项

-

Python3爬虫之自动查询天气并实现语音播报

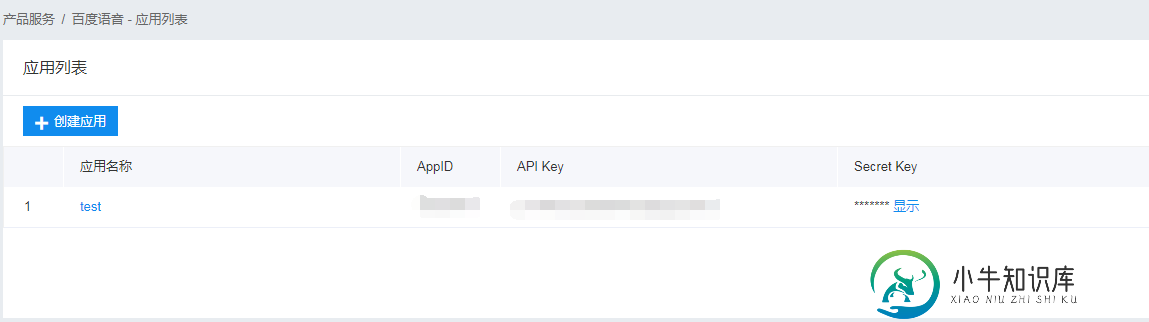

Python3爬虫之自动查询天气并实现语音播报本文向大家介绍Python3爬虫之自动查询天气并实现语音播报,包括了Python3爬虫之自动查询天气并实现语音播报的使用技巧和注意事项,需要的朋友参考一下 一、写在前面 之前写过一篇用Python发送天气预报邮件的博客,但是因为要手动输入城市名称,还要打开邮箱才能知道天气情况,这也太麻烦了。于是乎,有了这一篇博客,这次我要做的就是用Python获取本机IP地址,并根据这个IP地址获取物理位置也就是

-

实践Python的爬虫框架Scrapy来抓取豆瓣电影TOP250

实践Python的爬虫框架Scrapy来抓取豆瓣电影TOP250本文向大家介绍实践Python的爬虫框架Scrapy来抓取豆瓣电影TOP250,包括了实践Python的爬虫框架Scrapy来抓取豆瓣电影TOP250的使用技巧和注意事项,需要的朋友参考一下 安装部署Scrapy 在安装Scrapy前首先需要确定的是已经安装好了Python(目前Scrapy支持Python2.5,Python2.6和Python2.7)。官方文档中介绍了三种方法进行安装,我采用的

-

Python的爬虫程序编写框架Scrapy入门学习教程

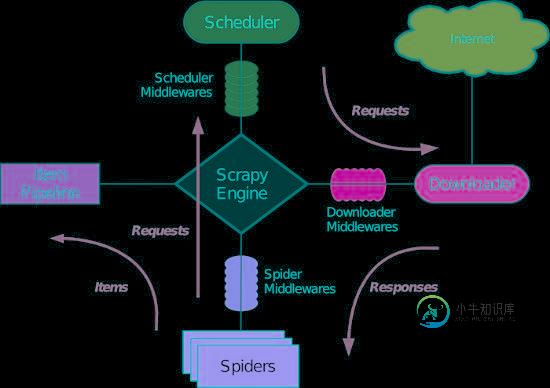

Python的爬虫程序编写框架Scrapy入门学习教程本文向大家介绍Python的爬虫程序编写框架Scrapy入门学习教程,包括了Python的爬虫程序编写框架Scrapy入门学习教程的使用技巧和注意事项,需要的朋友参考一下 1. Scrapy简介 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。 可以应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序中。 其最初是为了页面抓取 (更确切来说, 网络抓取 )所设计的, 也可以

-

详解nodejs爬虫程序解决gbk等中文编码问题

本文向大家介绍详解nodejs爬虫程序解决gbk等中文编码问题,包括了详解nodejs爬虫程序解决gbk等中文编码问题的使用技巧和注意事项,需要的朋友参考一下 使用nodejs写了一个爬虫的demo,目的是提取网页的title部分。 遇到最大的问题就是网页的编码与nodejs默认编码不一致造成的乱码问题。nodejs支持utf8, ucs2, ascii, binary, base64, hex等

-

基于C#实现网络爬虫 C#抓取网页Html源码

本文向大家介绍基于C#实现网络爬虫 C#抓取网页Html源码,包括了基于C#实现网络爬虫 C#抓取网页Html源码的使用技巧和注意事项,需要的朋友参考一下 最近刚完成一个简单的网络爬虫,开始的时候很迷茫,不知道如何入手,后来发现了很多的资料,不过真正能达到我需要,有用的资料--代码很难找。所以我想发这篇文章让一些要做这个功能的朋友少走一些弯路。 首先是抓取Html源码,并选择<ul class="

-

使用JAVA网络爬虫在MYSQL中存储印地语单词

我想在MySQL数据库中存储一些印地语单词。为此我写了一个网络爬虫。我能够从超文本标记语言页面成功读取这些单词并将它们显示在NetBeans控制台中。但是当我在MySQL中插入它们时,它们会变成???????。此外,如果我在PHPMyAdmin本身中使用SQL查询插入相同的单词,它们会被正确存储。 我搜索了很多谷歌和各种论坛,在大多数地方都采取了适当的预防措施来处理Unicode。如果输入Unic