《flink》专题

-

在Apache Flink中使用DynamoDB流

有人尝试在Apache Flink中使用DynamoDB流吗? Flink有一个Kinesis消费者。但是我正在寻找如何直接使用Dynamo流。 我试了很多次,但什么也没找到。然而,Flink Jira董事会发现一个未决请求。所以我想这个选项还不可用?我有什么选择? 允许FlinkKinesisConsumer适应AWS DynamoDB流

-

持久化Apache Flink窗口

我正试图使用Flink以流媒体的方式使用消息队列中的有界数据。数据格式如下: 可以使用事件ID确定消息的开始和结束。我想接收此类批次并将最新的(通过覆盖)批次存储在磁盘或内存中。我可以编写自定义窗口触发器来使用开始和结束标志提取事件,如下所示: 但是如何保持最新窗口的输出。一种方法是使用ProcessAllWindowFunction接收所有事件并手动将其写入磁盘,但这感觉像是一种黑客行为。我还研

-

基于java的Apache-Flink-CEP模式检测

我想做 从映射结构中包含的任何arraylist元素的CEP开始,然后继续我已经开始的其余arraylist元素 地图和图案结构: 我的目的是使用map中的数组列表元素发出警告,但由于其中的流流,数组列表元素的顺序并不重要。我想继续处理这个数组的其余元素,当我从这里的任何数组开始时,我可以返回这个数组的信息。例如:

-

多种事件类型的Apache Flink CEP模式

目前我正在做一个学期项目,我必须认识三个事件的系列。像

-

Apache Flink 1.4.2 akka。男演员未找到ActorNotFound

升级到Apache Flink 1.4.2后,我们每几秒钟就会在3个TaskManager中的一个上出现以下错误。 相应的TaskManager会消失并重新出现在集群中,但无法在其上成功运行任何作业。 尝试在此TaskManager上运行作业时 此外,TaskManager似乎没有向JobManager发送心跳响应 从零开始重新创建了具有相同结果的集群。1.3.2没有发生这种情况 这是什么原因造成

-

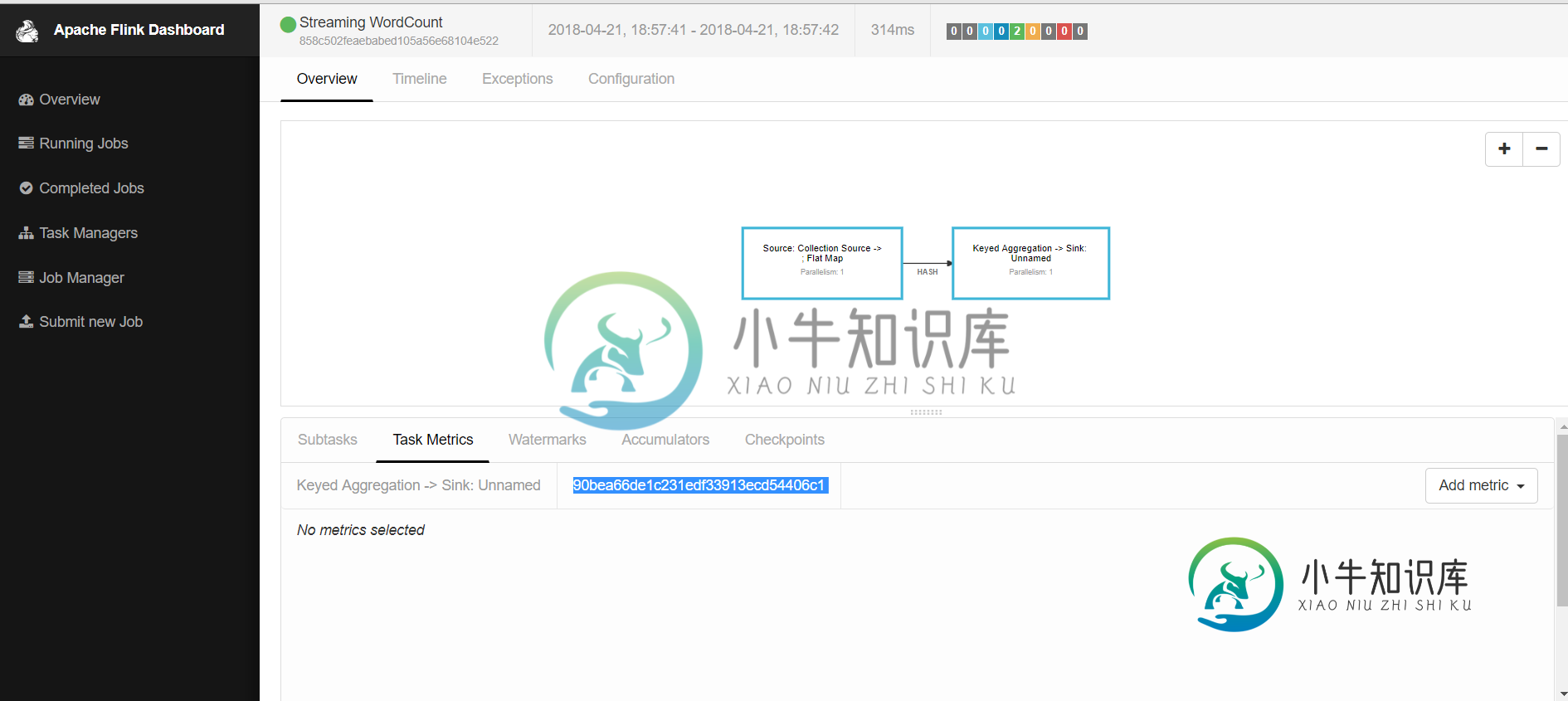

Apache Flink:Flink任务指标的自定义ID

Apache Flink:Flink任务指标的自定义ID -

Apache Flink:ProcessWindowFunction不适用

我想在Apache Flink项目中使用ProcessWindowFunction。但我在使用process函数时遇到了一些错误,请参见下面的代码片段 错误是: 方法进程(ProcessWindowFunction, R, Tuple, TimeWindow 我的程序: 我的处理窗口功能:

-

针对NOT followedBy的Apache Flink CEP模式操作

我有一个场景,如果第二个事件在x秒内没有跟随第一个事件,我必须更改状态。例如,对于用户没有在100分钟内注销,将他视为处于无效状态。如何使用当前模式操作设计这一点?

-

Apache Flink:接收器是否存储在检查点进入检查点状态期间从流缓冲的项目?

我正在开发一个遗留的Flink管道,我们希望更改我们正在使用的接收器的实现。我们正在运行Flink 1.10,试图从BucketingSink过渡到StreamingFileSink,两者都在将ORC写入相同的目标。我们的管道非常简单:我们将一些kakfa流合并到单个接收器中(没有其他操作员)。 在部署测试期间,我注意到当我们从sink1切换到sink2(反之亦然)时,我们最终会在我们正在编写的文

-

Flink Kinesis连接器未满容量使用来自Kinesis数据流的消息

我正在测试Apache Flink(使用v1.8.2)从Kinesis Data Stream读取消息的速度。Kinesis Data Streams仅包含一个分片,它包含40,000条消息。每个消息大小小于5 KB。 尝试使用TRIM\u HORIZON从最旧的消息中读取流,我希望该应用程序能够快速读取所有消息,因为通过GetRecords,每个碎片可以支持高达每秒2 MB的最大总数据读取速率。

-

Apache Flink-DataSet API-如何将n个结果组合在一起

我们正在使用Apache Flink(1.4.2)进行批处理,出于性能原因,我们希望在输出前将100个项目分组,而不是直接输出每个项目。 如果我们要使用DataStream API,我们将能够使用类似翻转窗口的东西(https://ci.apache.org/projects/flink/flink-docs-release-1.5/dev/stream/operators/windows.htm

-

使用EMR为Apache flink配置AWS

我有一个生产者应用程序,它以每秒600条记录的速度写入Kinesis流。我编写了一个Apache flink应用程序来读取/处理和聚合这些流数据,并将聚合的输出写入AWS Redshift。 每条记录的平均大小为2KB。此应用程序将24*7运行。 我想知道我的AWS EMR集群的配置应该是什么。我需要多少个节点?我应该使用的EC2实例类型(R3/C3)应该是什么。 除了性能方面,成本对我们也很重要

-

如何将SPARK/Flink流数据处理创建为一个微服务(RESTAPI)

我正在使用Spark,Flink创建流式分析应用程序 我在简单的Scala应用程序中完美地运行Spark/Flink作业,并通过Spark提交此作业 如何整合我的Spark 到目前为止,我尝试了Lagom Microservice,但我发现了很多问题,您可以检查 在Lagom Microservice中摄取流式数据的最佳方法 我认为我没有为流处理微服务应用程序选择正确的方向。正在寻找正确的方向来通

-

Flink水印如何准确判断事件迟到?

我在读书https://ci.apache.org/projects/flink/flink-docs-release-1.12/dev/event_timestamp_extractors.html#fixed-迟到的次数,看起来是在说如果 当事件时间等于水印时怎么样?如果,那么这个事件不晚吗? 我以前一直认为如果t_eventime

-

未调用apache flink事件时间处理窗口processfunction

窗口正在进行无限循环或其他操作,我正在处理后打印数据流,但看起来根本没有达到那个点。 下面是我的伪代码。 我在reduce函数中添加了要打印的日志。正在从reduce函数打印日志。但是这条流没有被打印出来。 并且流源数据是历史数据,即。。超过2个月的旧数据。如果是历史数据流,还需要专门设置其他内容吗? 任何输入都会大有裨益。。