@小牛知识库 xnip.cn

在Spark中,Distinct函数返回提供的数据集中的不同元素。

在此示例中,忽略重复元素并仅检索不同的元素。要在Scala模式下打开Spark,请按照以下命令操作。

$ spark-shell

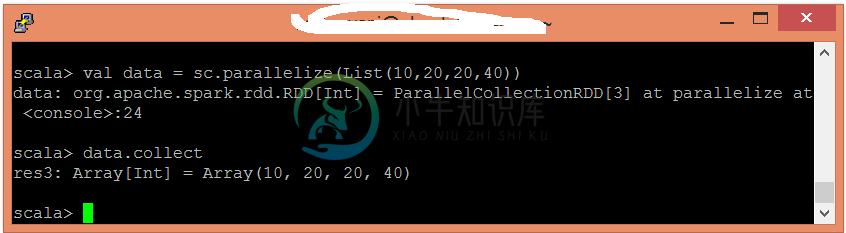

使用并行化集合创建RDD。

scala> val data = sc.parallelize(List(10,20,20,40))

现在,可以使用以下命令读取生成的结果。

scala> data.collect

应用distinct()函数来忽略重复的元素。

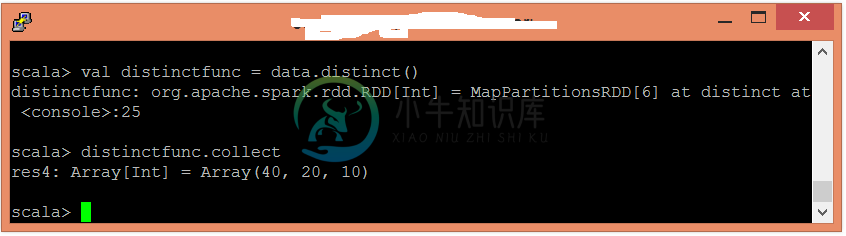

scala> val distinctfunc = data.distinct()

现在,可以使用以下命令读取生成的结果。

scala> distinctfunc.collect