在Spark中,Map通过函数传递源的每个元素,并形成新的分布式数据集。

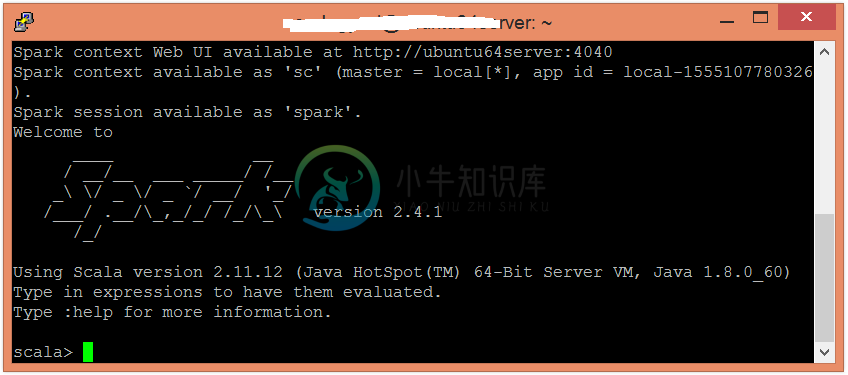

在此示例中,我们为每个元素添加一个常量值10。要在Scala模式下打开Spark,请按照以下命令操作 -

$ spark-shell

使用并行化集合创建RDD。

scala> val data = sc.parallelize(List(10,20,30))

现在,可以使用以下命令读取生成的结果。

scala> data.collect

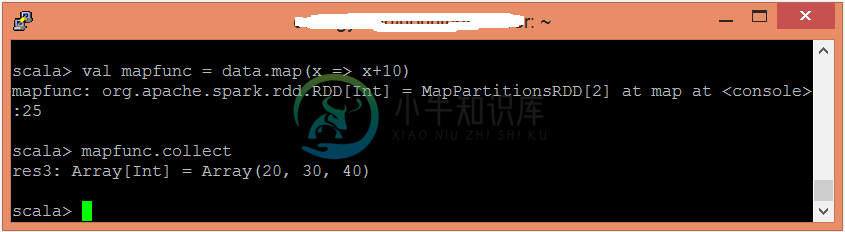

应用map函数并传递执行所需的表达式。

scala> val mapfunc = data.map(x => x+10)

现在,可以使用以下命令读取生成的结果。

scala> mapfunc.collect

在这里,得到了所需的输出。