《集群化》专题

-

Spark Streaming和Kafka:一个集群还是几个独立的盒子?

我要做一个关于使用火花流Kafka集成的决定。 一个Kafka主题和一个星火集群。 几个Kafka主题和几个独立的Spark盒(每个主题有一台带有独立Spark集群的机器) 几个Kafka主题和一个星火集群。 我很想选择第二种方案,但我找不到人谈论这样的解决方案。

-

如何创建跨越两个区域的GCP Kubernetes引擎集群?

-

如何在google cloud dataproc集群上同时使用jupyter、pyspark和cassandra

我试图让这三个工具在谷歌云平台上一起工作。所以我使用Dataproc创建了一个带有初始化脚本的Spark集群来安装cassandra和jupyter。 当我用ssh连接集群并启动“pyspark—packages datastax:spark cassandra connector:2.3.0-s_2.11”时,一切似乎都正常 编辑:事实上,spark shell可以,但pyspark不行。 我不

-

使用Java对启用Kerberos的Hadoop集群进行身份验证

我有Kerberos并启用了Hadoop集群。我需要使用Java代码执行HDFS操作。 多谢了。

-

在Hadoop 2.7.2(CentOS 7)集群中,Datanode启动,但不连接到namenode

我安装了一个三节点hadoop集群。主节点和从节点分别启动,但datanode未显示在namenode webUI中。datanode的日志文件显示以下错误: namenode计算机的信息: cat/etc/hosts cat/etc/sysconfig/networkscripts/ifcfg-eth0 cat/etc/hostname 名称 cat核心站点。xml 猫hdfs-site.xml

-

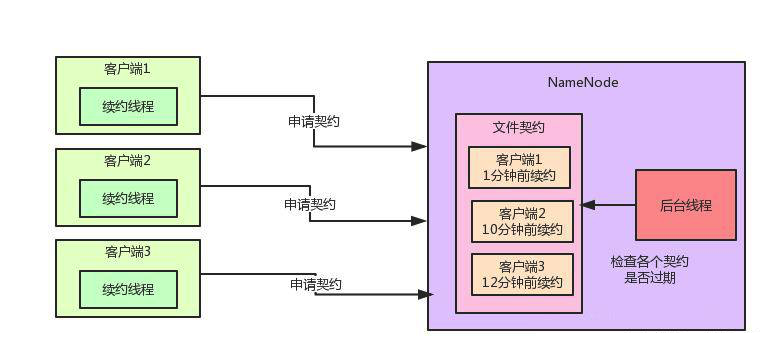

契约机制能让大数据集群性能提升100倍!

契约机制能让大数据集群性能提升100倍!主要内容:一、前情概要,二、背景引入,三、问题凸现,四、Hadoop的优化方案一、前情概要 这篇文章给大家聊聊Hadoop在部署了大规模的集群场景下,大量客户端并发写数据的时候,文件契约监控算法的性能优化。 看懂这篇文章需要一些Hadoop的基础知识背景,还不太了解的兄弟,可以先看看之前的文章:《兄弟们给我10分钟,带你了解一下大数据技术的入门原理和架构设计!》 二、背景引入 先给大家引入一个小的背景,假如多个客户端同时要并发的写Hadoop HDFS上的一个文件,大家觉得

-

7.5 将安全功能应用在正在运行的集群中

通过前面讨论的安全协议,选择一个或者多个协议保护正在运行的集群。 您可以通过以下步骤来完善安全功能: 滚动重启集群节点开启额外的安全端口。 使用安全端口重启客户端而不是 PLAINTEXT 端口(假设你正在设置 client-broker 的安全连接 )。 滚动重启集群节点开启 broker和broker之间的安全模式(如果需要的话)。 最后滚动关闭 PLAINTEXT 端口 关于配置 SSL 和

-

使用 Dumpling 备份 TiDB 集群数据到兼容 S3 的存储

本文详细描述了如何将 Kubernetes 上的 TiDB 集群数据备份到兼容 S3 的存储上。本文档中的“备份”,均是指全量备份(Ad-hoc 全量备份和定时全量备份)。底层通过使用 Dumpling 获取集群的逻辑备份,然后在将备份数据上传到兼容 S3 的存储上。 本文使用的备份方式基于 TiDB Operator 新版(v1.1 及以上)的 CustomResourceDefinition

-

高可用和集群简述 - 高可用与分片的概念

在本文档中,高可用主要指的是解决尽可能在不丢失数据的前提下不间断服务问题,由于redis是异步复制,因此不保证数据完全不丢失,在这个场景下并不实现动态横向扩容,只能进行纵向扩容,你只要加内存,启动redis,设置maxmemory即可。而分片(Sharding)主要指的是解决在线动态横向扩容缩容问题,当然为了稳定也进行高可用部署配置,即包含成对的主从关系。

-

是否可以使用 Spring-Cloud-Streams Kafka-Streams 创建一个多绑定器绑定,以便从集群 A 流式传输并生成到集群 B

我想创建一个带有Spring-Cloud-Streams的Kafka-Streams应用程序,该应用程序集成了2个不同的Kafka集群/设置。我尝试使用文档中提到的多绑定器配置来实现它,类似于以下示例:https://github.com/spring-cloud/spring-cloud-stream-samples/tree/main/multi-binder-samples 给定如下简单函数

-

在raspberrypi kubernetes集群上将入口部署为监听端口80的演示集需要什么

你好kubernetes专家, 我有一个kubernetes集群,它运行在4个raspberry PI上,docker 18.04ce和kubernetes 1.9.7。 我部署了一个服务,可以通过集群IP从集群内访问此服务。我还部署了一个入口,如https://docs.traefik.io/user-guide/kubernetes/和如何让库伯内特斯IngresPort 80在裸机单节点集群

-

无法连接到内核化集群中的带有火花JDBC的Hive服务器

我尝试从一个配置单元(配置单元n°1)读取数据,并将结果写入另一个配置单元(配置单元n°2)(它们来自两个不同的集群)。我不能使用单个spark会话连接到两个配置单元,因此我将使用jdbc读取数据,并使用spark配置单元上下文写入数据。 两个集群都使用kerberos,Knox,ranger。 THS批火花将在蜂巢n°2上运行 这是我的主要错误: GSSException:未提供有效凭据(机制级

-

使用flink/kubernetes替换etl作业(在SSI上):每个作业类型一个flink集群,或者每个作业执行创建和销毁flink集群

我正在尝试将使用SSIS包创建的数百个feed文件ETL作业替换为apache flink作业(并将kuberentes作为底层infra)的可行性。我在一些文章中看到的一条建议是“为一种工作使用一个flink集群”。 由于我每天都有少量的每种工作类型的工作,那么这意味着对我来说最好的方法是在执行工作时动态创建flinkcluster并销毁它以释放资源,这是正确的方法吗?我正在建立flinkclu

-

Redis集群:使用Lua脚本更新不同节点中的密钥

问题内容: 我有一个由多个节点组成的Redis集群。我想在一个原子操作中更新3个不同的键。我的Lua脚本就像: 我用以下方法解雇了它: 但是我知道了。上述操作无法完成,更新将失败。看来我无法使用单个Lua脚本修改不同节点中的键。但是根据文档: 在执行之前必须分析所有Redis命令以确定该命令将对哪些键进行操作。为了使这种情况适用于EVAL,必须显式传递密钥。这在许多方面很有用,但是特别是要确保Re

-

使用Jedis如何写入Redis集群中的特定插槽/节点

问题内容: 我正在尝试提高将数据写入Redis集群的性能。我们正计划从redi-sentinel转换为集群模式以实现可伸缩性。 但是,与redis-sentinel相比,写操作的性能要差得多。我们在redis-sentinel中利用了管道,但是集群模式不支持管道。 因此,我正在考虑将所有进入同一节点的密钥归为一组,然后使用管道将批次发送到该特定节点。 因此,我想知道如何(在写入集群之前)将特定密钥