《集群化》专题

-

Spark submit是否会自动将jar上传到集群?

我正在尝试从本地机器终端向我的集群提交一个Spark应用程序。我正在使用。我也需要在我的集群上运行驱动程序,而不是在我提交应用程序的机器上,即我的本地机器上 当我提供到本地机器中的应用程序jar的路径时,spark-submit会自动上传到我的集群吗? 我在用 和获取错误

-

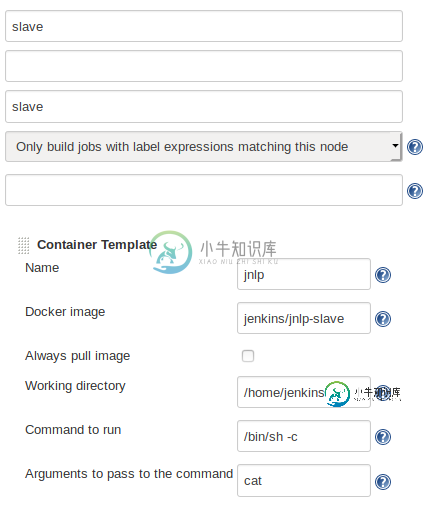

Jenkins jnlp从机不在本地Kubernetes群集上工作

Jenkins jnlp从机不在本地Kubernetes群集上工作我尝试了本地minikube和kubeadm Kubernetes集群,并通过https://github.com/jenkinsci/kubernetes-plugin运行Jenkins服务器,并使用。 以下是了解这个问题的更多细节。

-

Lucene+自定义集群解决方案的ElasticSearch开销

null 哪些管理费用?正如我所知,您可以黑ElasticSearch通过内部TCP API而不是REST与他通信。还有其他管理费用吗?它们只关于复制(您可以关闭初始加载复制)吗?或者关于索引自动合并?也许是由于ElasticSearch试图自动合并索引,并使它们变得如此之大,以至于不能支持FS缓存? 为什么Lucene API更灵活?AFAIK,ElasticSearch有所有相同的索引和其他特

-

如何向远程纱线集群提交Flink作业?

在ResourceManager节点上启动flink作业(查找配置文件) 从ResourceManager下载配置文件到本地。 我想,这两种方式都不太好。如何将作业提交到远程纱线集群。有没有合适的办法?

-

为什么hdfs在Hadoop集群中抛出LeaseExpiredException(AWS EMR)

tail-f/var/log/hadoop-hdfs/hadoop-hdfs-namenode-ip-172-30-2-148.log 2016-09-21 11:54:14,533 INFO BlockStateChange(8020上的IPC Server handler 10):Block*InvalidateBlocks:添加blk_107374750_6677到172.30.2.189:

-

无法在Yarn集群模式下运行Talend作业

我正在使用TOS 7.1和MapR 6.0发行版以及sprak2。2. 流程:主任务- 两份工作1 下面是集群模式的应用程序日志中的错误:线程“main”java中出现异常。lang.NoClassDefFoundError:例程/system/api/TalendJob。 从错误中 请建议。

-

不允许Datanode连接到Hadoop 2.3.0集群中的Namenode

-

Logstash无法连接安全(ssl)弹性搜索集群

在elasticsearch和kibana中启用ssl通信工作良好,但logstash无法连接elasticsearch,但我可以卷曲elasticsearch urlhttps://localhost:9200也没有防火墙阻止,我已经生成了打开的ssl证书和密钥文件并保存在elasticsearch中 弹性搜索配置文件 logstash日志文件

-

部署在Kubernetes集群中的Pod的google云凭据?

这里我可能错了,当我在VM上运行这个python文件时,它可以创建一个新的bucket,而不需要凭据或服务帐户。 如果我将相同的代码Dockere化到flask应用程序中,并将其部署在集群上,那么它是否仍将采用默认的google凭据?我想知道在kubernetes集群上这样做的最佳实践。

-

无法从AWS Kafka群集外部生成Kafka消息

我有以下问题: 我在aws上只使用1个worker和broker节点建立了一个尽可能基本的汇合平台。 我对所有与人脉和关系网有关的事情都很敏感,所以我希望有人能帮助我

-

利用MySQL NDB集群实现负载平衡和HA

如何使用MySQL NDB集群数据库来配置应用程序,以满足高可用性和负载平衡的要求。据我所知,我们可以通过适当配置数据库连接url,分别拥有这两个功能,如下所示。 JDBC:MySQL:LoadBalance://[host1][:port],[host2][:port][,[host3][:port]]...[/[database]]][?PropertyName1=PropertyValue1

-

Artemis从节点不能在整个集群中启动

我试图将一个6节点的Apache Artemis静态集群作为3个实时备份对运行。为了在整个集群重启期间不丢失数据,我还创建了一种机制,可以找出这两个节点中哪一个数据更新,并根据该机制服务器自动决定启动该特定节点是否安全。在整个群集重新启动期间,服务器将同时启动,具有较新数据的节点将在最近充当备份的节点之前启动。 这个场景在使用单个活备份对时工作得很好。 null null 但是,在6节点集群中,备

-

使用mongoose连接到mongo集群的最佳方法

我正在尝试将我的节点应用程序连接到mongo集群,我已经使用了这种方法 但它会抛出这个错误 (节点:8701)UnhandledPromiseRejectionWarning:未处理得承诺拒绝(拒绝ID:2):MongoError:拓扑已被破坏(节点:8701)[DEP0018]DeprecationWarning:不推荐未处理得承诺拒绝.将来,如果re未被处理,则承诺拒绝将使用非零退出代码终止n

-

Apache Kafka-Log4j-Appender未在spark群集模式下工作

我尝试将spark应用程序驱动程序/执行程序日志发送到kafka topic。它在Eclipse中工作 在部署群集模式时,它会显示 ClassNotFoundException。 我添加了,,,,和maven,但它仍然显示 组织。阿普切。Kafka。log4jappender类NotFoundException。 在服务器中,运行jar自身的spark程序中并没有与Kafka相关的jar。 请告诉

-

无法将CSV文件从Databricks集群DBFS导入h2o

我已在我的AWS Database ricks集群上成功安装了两个h2o,然后成功启动了h2o服务器: 当我尝试导入存储在Database ricks DBFS中的iris CSV文件时: 我得到一个H2OResponseError:服务器错误water . exceptions . h2onotfoundargumentexception CSV文件绝对在那里;在同一个Databricks笔记本