《flink》专题

-

Flink Scala API“参数不足”

我在使用Apache Flink Scala API时遇到问题 例如,即使我从官方文档中获取示例,scala编译器也会给我大量的编译错误。 代码: Scala IDE为行 这不仅仅是方法:即使我从文件中读取数据,然后尝试做一些像

-

Flink流窗口触发器

我有flink stream,我在某个时间窗口上计算一些事情,比如说30秒。 这里发生的事情是,它给我的结果,我以前的窗口聚合以及。 假设前30秒我得到结果10。 接下来的三十秒我想要新的结果,而不是我得到最后一个窗口的结果新的等等。 因此,我的问题是如何为每个窗口获得新的结果。

-

IntelliJ中Flink WordCount输出中的数字

我正在学习ApacheFlink,并通过IntelliJ中的Maven将其集成。我尝试了GitHub的WordCount示例:GitHub的WordCount示例 我只是调整了输入文本。 产生输出的代码的主要部分是: 我在IntelliJ中得到以下输出 所以我有两个问题: > “$NUMBER”是什么 与文本一样,“florian”一词在输出中出现两次。这是由于写入输出的子任务吗?所以每次增加字数

-

Apache Flink的Webhook流式连接器

根据ApacheFlink文档,它有预定义的数据源。它还提到了其他一些连接器,例如RabitMq连接器等。我想知道是否有类似的项目可以使用Webhook作为数据源。

-

定期刷新Apache Flink中的静态数据?

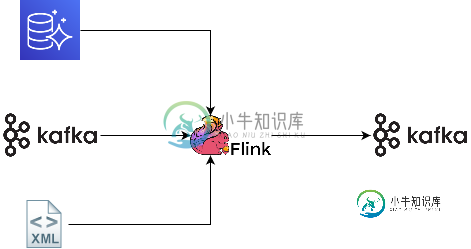

定期刷新Apache Flink中的静态数据?我有一个应用程序,它从一个流接收大部分输入,但是它的一些数据来自RDBMS和一系列静态文件。 流将连续发出事件,因此flink作业永远不会结束,但是如何定期刷新RDBMS数据和静态文件以捕获对这些源的任何更新? 我目前正在使用从数据库中读取数据。 下面是我尝试做的大致示意图:

-

Flink:流拓扑中未定义运算符。无法执行

我正试图设置一个非常基本的闪回工作。当我尝试运行时,得到以下错误: 错误由以下代码引起: 当我向流的末尾添加调用时,错误消失了: 我不明白为什么可以解决这个问题。在引入接收器之前,流拓扑不会处理其任何操作符吗?

-

Apache Flink Streaming类型不匹配的平面地图功能

正在尝试在scala 2.10.4中使用0.10.0 flink版本的流式api。尝试编译此第一个版本时: 我遇到编译时错误: 在数据流的反编译版本中。类,我已将其包括在项目中。有接受此类类型的函数(最后一个): 这里会出什么问题?如果你能提供一些见解,我将不胜感激。提前谢谢你。

-

Apache Flink Wordcount:流拓扑中未定义运算符

我正在浏览Apache Flink的基本WordCount示例。这是代码: 当我尝试在群集中部署此作业时,请使用: 我得到这个例外: 我不明白为什么,因为我是Flink的新手。请帮助我理解这个问题。谢谢你。 当我尝试直接从IDE运行此代码而不将JAR部署到集群时,它完全可以正常工作。

-

Flink Kafka生产者:类的对象不可序列化

我尝试为我的定制类实现一个方法,使用Flink-Kafka连接器生成关于Kafka的数据。类原型如下所示: 将数据写入特定Kafka主题的方法如下: 我有另一种方法可以从Kafka主题获取对象的字段中的数据,效果很好。现在尝试从Kafka主题获取数据并将其写入另一个Kafka主题时,我遇到了错误: 主要代码: Java似乎试图序列化对象,而不仅仅是字段

-

FLINK:Kafka源代码-重新启动时发现新主题时的重新启动策略

我有一个临时作业,通过KafkaSource被配置为收听主题的正则表达式,类似于: Kafka Consumers Start Position配置设置为startFromLatest,如下所示: 我们通过配置传递topicPattern,有时一个新的Kafka制作人会生成数据,比如说,然后我们通过添加这个新主题来更新配置,并使用保存点重新启动作业。 在本例中,我们注意到Kafka资料从一开始就阅

-

Flink使用Java中的自定义类设置基本Kafka生产者消费者

我想在Kafka上用Flink设置一个基本的生产者-消费者,但是我很难通过Java向现有消费者生成数据。 CLI解决方案 > 我设置了一个使用zip from 和 我使用创建了一个名为transactions1的主题 现在我可以在命令行上使用生产者和消费者来查看主题已经创建并工作。 设置我运行的消费者 现在,如果任何制作人向主题发送数据,我将在消费者控制台中看到它。 我通过运行 并在cli中的生产

-

序列化flink中kafka的对象

我试图使用flink从kafka中读取数据,执行一些函数,并将结果返回到不同的kafka主题,但出现以下错误`组织。阿帕奇。Flink。应用程序编程接口。常见的InvalidProgrameException:MapFunction的实现不可序列化。对象可能包含或引用不可序列化的字段。 我收到了来自kafka的消息-对其进行了一些操作,并返回了一个对象列表,我想发送到不同的主题。 内部类也实现了可

-

如何打印Kafka主题数据在Flink程序?

我通过以下说明创建了一个主题: 然后,我测试了这个主题是否有正确的数据。之后,我想在Flink程序中打印这个主题。我的计划是: 但是我得到了这个信息(因为信息太长了,我不得不写一些): [main]INFOorg.apache.flink.streaming.api.environment.LocalStream环境-在本地嵌入式Flink迷你集群上运行作业[main]INFOorg.apache

-

Kafka和Flink:让流到webapp

我正在试用Kafka和Flink: 我使用flink制作人向Kafka发送推特流 如果我创建一个基本的RESTWebServices,我想我会失去流媒体的兴趣,对吗? 我应该向我的网络应用程序提供flink数据,还是应该将其发送到另一个Kafka主题,以便将其提供给网络应用程序? 非常感谢。 安托万

-

Flink与StatsD计数器度量比较

谈到与StatsD相关的计数器,它的工作方式是你不断发布计数器的值,例如。请求 每当应用程序收到对 StatsD 守护程序的请求时。守护程序设置了刷新间隔,当它将此计数器在该时间段内的聚合推送到外部后端时。此外,它还将计数器重置为 0。 试图将其映射到Flink计数器。 Flink计数器只有inc和dec方法,因此在报告时间到来之前,应用程序可以调用inc或dec来更改计数器的值。 在报告计数器的