《flink》专题

-

Apache Flink:. count tWindow()是在发生大量事件后处理代码的正确方法吗?

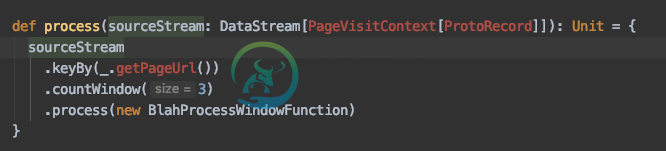

Apache Flink:. count tWindow()是在发生大量事件后处理代码的正确方法吗?在Apache Flink 1.8.1上 我正在阅读https://flink.apache.org/news/2015/12/04/Introducing-windows.html,我试图弄清楚使用是否适合我的用例:当N个用户访问我网站的帮助页面时,我想将他们全部标记为客户服务外展。我很困惑,因为上的留档有限,我很难确认它是否已被弃用以支持另一种方法。 然后找到留档是如此有限。充其量,我发现它列

-

Apache Flink 1.3.2与Kafka 1.1.0的连接问题

我正在使用Apache Flink 1.3.2的集群。我们正在使用Kafka消息,自从将代理升级到1.1.0(从0.10.2)后,我们经常在日志中发现此错误: 因此,有时我们在处理过程中会遇到缺失事件。我们在工作中使用FlinkKafkaConsumer010。 已启用检查点(间隔10秒,超时1分钟,检查点之间的最小暂停时间为5秒,最大并发检查点时间为1秒。E2E的平均持续时间不到1秒,甚至不到半

-

Flink自定义分区器示例

我试图处理的用例如下: 我们有一个来自Kafka的数据流 所以举个例子: 让我们假设所有消息都是表示编码数据的字节数组 编码数据中具有特定值的所有消息都应由一个操作员处理 这样,当我们接收到与相同值对应的特定消息时,这些消息可以作为状态存储在操作符上(在分区器之后),并可用于丰富后续消息 问题: 自定义分区程序会对此有所帮助吗 如果不是,那么什么是一个好的解决方案 有人可以在Flink中为数据流共

-

Flink·Kafka:为什么我会丢失信息?

我编写了一个非常简单的Flink流媒体作业,它使用从Kafka获取数据。 这工作得很好,每当我在Kafka上将某些内容放入主题时,它都会被我的Flink作业接收并处理。现在我试图看看如果我的Flink作业由于某种原因不在线会发生什么。所以我关闭了flink作业并继续向Kafka发送消息。然后我再次开始我的Flink作业,并期望它会处理同时发送的消息。 然而,我得到了以下信息: 因此,它基本上忽略了

-

如何使用Flink SQL按事件时间对流进行排序

我有一个无序的

-

使用度量的Flink事件计数

我在《Kafka》中有一个主题,在这里我得到了json格式的多种类型的事件。我创建了一个filestreamsink,用bucketing将这些事件写入S3。 现在我想将每个事件的每小时计数作为指标发布给prometheus,并在此基础上发布grafana仪表板。 因此,请帮助我如何使用flink指标实现每个事件的小时计数并发布到prometheus。 谢谢

-

Apache Flink:如何为键控的CoFlatMapFunction划分事件?

这是关于连接键控流的一个非常基本的问题。 如果我有两个具有共享相同逻辑键的相关事件的流,并且这些流正在连接(使用该键进行逻辑连接),并且所有这些流都以并行方式运行 这是一个关于医院患者流的虚构示例——温度流和心跳流。我们希望使用和通过患者的id加入这两个流。 假设它以并行度=3运行,操作员任务A、B、C,并且它们都在不同的物理机器中运行。 Flink将保证患者“JohnDoe”的所有温度事件都将在

-

Flink表API

我正在流媒体环境中使用Flink的表API和/或Flink的SQL支持(Flink 1.3.1、Scala 2.11)。我从一个数据流【Person】开始,Person是一个case类,看起来像: 在我开始将属性带入图片之前,一切都按预期进行。 例如: 。。。导致: 线程“main”组织中出现异常。阿帕奇。Flink。桌子api。TableException:不支持类型:组织中的任何。阿帕奇。Fl

-

Flink富集具有流转时长的传入数据

为了调试我们的应用程序,我们将所有传入数据(s3接收器)保存在图形的单独部分(甚至在时间戳/水印处理之前)。我们的数据已经包含了时间戳(event timestamp),在保存数据之前,我们想再添加一个字段,其中在消息实际进入flink时会有一个时间戳(处理时间)。 如何最好地做到这一点?也许flink为此提供了一个特殊的API,现在我们正在做非常简单的

-

Flink消息像Storm一样重试

我正在尝试构建一个Flink作业,该作业将从Kafka源读取数据并进行一系列处理,包括很少的REST调用,然后最终进入另一个Kafka主题。 我试图解决的问题是消息重试。如果REST API中存在瞬时错误怎么办?如何像Storm支持的方式那样,对这些消息进行基于指数退避的重试? 我有两种方法可以考虑 使用TimerService,但如果发生故障,状态将开始不受控制地扩展。 将失败的消息写入不同的K

-

Flink:MaxOutOfOrderness和AllowedLatenness之间的差异

在Flink中,有两个东西提供了相似的行为。两者之间的区别是什么。 MaxOutOfOrness:与BoundedOutOfOrdernessTimestampExtractor一起使用。通过将事件时间后面的水印延迟MaxOutOfOrdeness值,允许流的元素按maxOutOfOrdeness值的大小乱序。 允许延迟:在此参数定义的更多时间内保持窗口状态。 当你已经可以通过maxOutOfOr

-

Apache Flink:setParallelism()和setMaxParallelism()的区别是什么

我尝试为Flink作业设置最大并行度,使用方法,但它似乎不起作用。 我还修改了标准WordCount示例以运行一些测试,似乎方法对本地环境或独立集群没有任何影响。 setMaxParallelism()如何工作?

-

Apache Flink vs Twitter Heron?

比较Flink与Spark Streaming、Flink与Storm、Storm与Heron,有很多问题。 这个问题的起源是因为Apache Flink和Twitter Heron都是真正的流处理框架(不是微批处理,如Spark Streaming)。Storm去年已被Twitter退役,他们正在使用Heron代替(基本上是Storm重新设计的)。 斯利姆·巴尔塔吉(SlimBaltagi)在《

-

如何减少或禁用Flink中的检查点日志

我正在使用Flink 1.11.1,并在Kubernetes上以独立模式运行它,hdfs用于存储和HA。最近,我尝试启用Flink检查点功能。但我注意到jobmanger和TaskManager都记录了太多与检查点相关的日志,这很烦人。示例如下: 工作经理 任务经理 有什么方法可以禁用或减少检查点的日志吗?任何帮助都将不胜感激!

-

Flink故障恢复:如果JobManager或TaskManager失败怎么办

我正在阅读Flink官方文档关于任务失败恢复:https://ci.apache.org/projects/flink/flink-docs-stable/dev/task_failure_recovery.html 据我所知,这个文档告诉我们,如果某个任务由于某种原因失败,Flink可以借助检查点机制来恢复它。 所以现在我还有两个问题: > 如果TaskManager失败怎么办?据我所知,任务分