《雪花算法》专题

-

Apache Flume花费的时间比创造性命令多

我在本地文件系统中有24GB文件夹。我的任务是将该文件夹移动到HDFS。我有两种方法。1)hdfs dfs-复制来自本地 /home/data/ /home/ 这大约需要 15 分钟才能完成。 2)使用水槽。 这是我的经纪人 这一步花了将近一个小时将数据推送到HDFS。 据我所知,Flume是分布式的,所以Flume加载数据的速度应该比copyFromLocal命令更快。

-

如何选择我的火花程序的scala版本?

我正在构建我的第一个Spark应用程序,用IDEA开发。 在我的集群中,Spark的版本是2.1.0,Scala的版本是2.11.8。 http://spark.apache.org/downloads.html告诉我:“从2.0版本开始,Spark默认是用Scala 2.11构建的。Scala 2.10用户应该下载Spark源代码包,并使用Scala 2.10支持进行构建”。 所以我的问题是:“

-

如何在spring boot中处理RequestParam中的花括号

我有一个带有GET服务的spring启动应用程序。 的值是一个编码值。 如果我把下面作为值传递给参数子 它无法捕获请求,并且控件不在函数内部。 如果我们作为值传递给参数子: 它很好用。 > 由于服务器无法处理该请求,所以返回400。我需要捕获这些请求,然后通过正确编码来处理它们。前进的道路是什么? 我是新来的Spring启动/Spring和Java本身。如果我能得到一些见解,那就太好了。 另外,我

-

Pyspark拆分字符串类型的火花数据框

我正在使用spark(批处理,而不是流)从kafka topic中读取数据来创建spark dataframe。我想使用spark将这个数据帧加载到cassandra。Dataframe是字符串格式,如下所示。 root |-value:string(nullable = true) 我尝试使用','分隔符拆分数据帧记录,并形成新的数据帧,我可以将其数据到cassandra。 创建了如下的火花DF

-

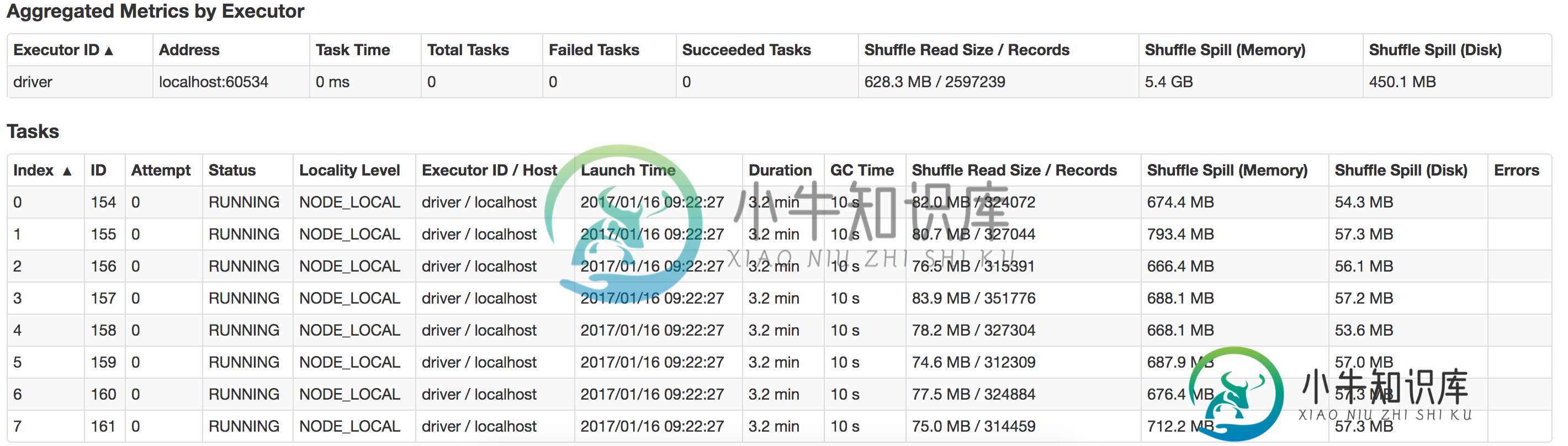

火花驱动程序内存和执行器内存

火花驱动程序内存和执行器内存我是Spark的初学者,我正在运行我的应用程序,从文本文件中读取14KB的数据,执行一些转换和操作(收集、收集AsMap),并将数据保存到数据库 我在我的macbook上本地运行它,内存为16G,有8个逻辑核。 Java最大堆设置为12G。 这是我用来运行应用程序的命令。 bin/spark-submit-class com . myapp . application-master local[*

-

火花中的coalesce(Num分区)是否经过洗牌?

我在火花变换函数中有一个简单的问题。 coalesce(numPartitions) - 将 RDD 中的分区数减少到 numPartitions。可用于在筛选大型数据集后更有效地运行操作。 我的问题是 > < Li > < p > coalesce(num partitions)真的会从filterRDD中删除空分区吗? coalesce(numPartitions)是否经历了洗牌?

-

使用java将拼花文件从Lambda保存到S3

我有一个用例,我需要将拼花文件从Lambda保存到S3。我需要以追加模式存储Lambda函数中触发的事件。 我尝试使用Avro,但它不允许将数据以追加模式存储在同一个拼花文件中。 到目前为止,我发现只要spark允许在附加模式下将数据存储在拼花文件中…然后,我可以使用Lambda提交一个存储数据的spark作业。你认为这个可能的解决方案如何? 然而,真的不存在不使用spark的解决方案吗?预先感谢

-

每个分区中对象数量的火花合并

我们开始在团队中尝试spark。在我们减少spark中的工作后,我们希望将结果写入S3,但是我们希望避免收集Spark结果。目前,我们正在为RDD的每个分区写文件,但是这会产生很多小文件。我们希望能够将数据聚合到几个文件中,这些文件按照写入文件的对象数量进行分区。例如,我们的总数据是100万个对象(这是不变的),我们希望生成40万个对象文件,而我们当前的分区生成大约2万个对象文件(这因每个作业而异

-

处理dataskew而不加盐的连接键在火花

我正在尝试将一个100万行数据帧与一个30行数据帧进行内部连接,这两个表都有相同的连接键,spark正在尝试执行排序合并连接,因此我的所有数据最终都在同一个执行器中,例如,Job从未完成 我试着跟随 广播 已重新分区 查询执行计划 分区数的输出 即使我重新分区/广播数据,火花在加入时将所有数据带到一个执行器,数据在一个执行器上会发生倾斜。我还尝试将sortMergeJoinspark.sql.jo

-

匹配花括号的Java regex-“无效转义序列”

我希望通过将嵌套的JSON字符串递归地拆分{}来解析它们。我得到的regex是“{([^}]*.?)}”,我已经测试过它可以恰当地获取我想要的字符串。但是,当我试图将它包含在Java中时,我得到了以下错误:“无效的转义序列(有效的转义序列是 这是我的代码,也是错误发生的地方: 我做错了什么?

-

Spark仅保存(写入)拼花地板一个文件

如果我写信 临时工。拼花文件夹我得到了和行号相同的文件号 我想我不太了解拼花地板,但它是自然的吗?

-

火花MLLib线性回归模型截距总是0.0?

也就是说,我希望截距为4,权重为(2,3)。 如果我运行linearregressionwithsgd.train(...)在原始数据上,模型是: 而且预测都是南:

-

斯卡拉火花 将多个列对分解成行

如何将多个列对分解为多行? 我有一个包含以下内容的数据帧 我想要一个最终的数据帧,如下所示 我试着使用下面的代码,但是它返回了4条记录,而不是我想要的两条记录

-

带API23(棉花糖)的Android SDK支持Java8吗?[副本]

IntelliJ Android Studio上次更新(2016年1月30日起)支持Java8吗? 我用了一个lambda表达式 注意:我使用的是最后一个API级别

-

火花 Java - 将多个列收集到数组列中

我有一个包含多列的数据框架: 我现在想将组合成一列。但是,我不知道列列表会有多大,否则我可以使用UDF3来组合这三个。 所以期望的结果是: 我怎样才能实现这一点? 不工作的伪代码: 最坏的解决方法是对输入列的数量执行switch语句,然后为每个输入列编写一个UDF,即2-20个输入列,如果提供了更多的输入列,则抛出一个错误。