《pytorch》专题

-

PyTorch上实现卷积神经网络CNN的方法

本文向大家介绍PyTorch上实现卷积神经网络CNN的方法,包括了PyTorch上实现卷积神经网络CNN的方法的使用技巧和注意事项,需要的朋友参考一下 一、卷积神经网络 卷积神经网络(ConvolutionalNeuralNetwork,CNN)最初是为解决图像识别等问题设计的,CNN现在的应用已经不限于图像和视频,也可用于时间序列信号,比如音频信号和文本数据等。CNN作为一个深度学习架构被提出的

-

Pytorch入门之mnist分类实例

本文向大家介绍Pytorch入门之mnist分类实例,包括了Pytorch入门之mnist分类实例的使用技巧和注意事项,需要的朋友参考一下 本文实例为大家分享了Pytorch入门之mnist分类的具体代码,供大家参考,具体内容如下 以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持呐喊教程。

-

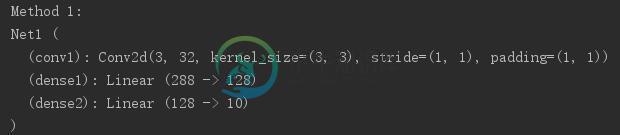

pytorch构建网络模型的4种方法

pytorch构建网络模型的4种方法本文向大家介绍pytorch构建网络模型的4种方法,包括了pytorch构建网络模型的4种方法的使用技巧和注意事项,需要的朋友参考一下 利用pytorch来构建网络模型有很多种方法,以下简单列出其中的四种。 假设构建一个网络模型如下: 卷积层--》Relu层--》池化层--》全连接层--》Relu层--》全连接层 首先导入几种方法用到的包: 第一种方法 这种方法比较常用,早期的教程通常就是使用这种

-

pytorch中的多元输入LSTM

我想在Pytorch中实现多变量输入的LSTM。 在这篇使用keras的文章https://machinelearningmastery.com/how-to-develop-lstm-models-for-time-series-forecasting/之后,输入数据的形状是(样本数、时间步数、并行特征数) 在keras,这似乎很容易:

-

使用PyTorch实现自定义数据集

我正试图修改这个来自的前馈网络https://github.com/yunjey/pytorch-tutorial/blob/master/tutorials/01-basics/feedforward_neural_network/main.py 使用我自己的数据集。 我定义了一个自定义数据集,其中两个1微米数组作为输入,两个标量对应的输出: 我已更新超参数以匹配新的输入大小(2) 我还改变了t

-

pytorch量子化卷积中的偏置是如何工作的?

我试图在PyTorch中执行静态训练后量化。对于这个例子,我尝试用偏置量化Conv2d层: PyTorch文档明确指出,偏差不是量子化的,而是保持为浮动张量。输出的整数表示产生: 但是,浮点表示法产生: 我搜索了关于这个问题的信息,得出的结论是,用于卷积输出再量化的刻度和零点考虑了偏差,并且在GEMM操作期间,偏差被量化为int32_t,然后被添加到GEMMint32_t结果中...从上述示例中,

-

在删除了一些Python文件之后,我不能再通过pip安装pytorch了

不幸的是,我删除了Python的一些文件。我有macOS Catalina,我想用以下命令安装pytorch: 错误:命令出错,退出状态为1:/library/framework/python.framework/versions/3.8/bin/python3.8-u-c'import sys,setuptools,tokenize;sys.argv[0]=‘“’”‘/private/var/f

-

Pytorch GRU错误运行时错误:大小不匹配,m1:[1600 x 3],m2:[50 x 20]

目前,我正在尝试为LSTM和GRU建立培训模型。LSTM工作得很好,但一旦我切换到GRU训练,就会出现错误,例如大小不匹配错误。 这是我的密码 这就是我犯的错误 ------------------------------------------------------------------------------中的运行时错误回溯(最近一次调用上次)---- 火车(模型,train_list,

-

Pytorch简单线性Sigmoid网络不学习

我正在学习pytorch,并试图将网络训练为异或门。一切运行顺利,但就是不学习。它确实改变了它的权重,但是它会收敛到超出预期结果的每一个输入的结果中。 我尝试了许多学习率和权重初始化。 因此,输入是A和B门,如果两者相等,则返回1,否则返回0,如下所示: 这是我对模型建模和训练的尝试: 这是一次以0.001学习率进行100000次迭代的运行: 我真的迷路了。这不管用吗?

-

在ResNet50中对pytorch中包含10个类的图像进行分类时遇到此错误。我的代码是:

这是我正在实现的代码:我使用CalTech256数据集的子集对10种不同动物的图像进行分类。我们将介绍数据集准备、数据扩充,然后介绍构建分类器的步骤。 错误是: 运行时错误回溯(最近一次调用last)in()6#为25个历元7个历元=30训练模型---- 列车内和验证(模型、损耗标准、优化器、EPOCH)43 44#计算损耗--- ~\anaconda3\lib\site-包\torch\nn\模

-

如何解决PyTorch中奇怪的cuda错误?

我从凯拉斯搬到了皮托克。我对搬到CUDA这件事很陌生。我花了好几个小时在网上冲浪,却什么都没找到?修复可能是一两行。如果有人知道如何解决这个问题,我会很感激的? 下面是我的代码,首先我将我的u-net模型定义为一个nn类。类似于以下代码的模块: 然后我像下面的代码一样运行我的unet。请注意,在定义模块时,我将其设置为cuda。我还将输入数据及其标签设置为cuda。 但是我得到了这个错误: Run

-

基于pytorch的多变量线性回归

我正在研究Pytorch的线性回归问题 我在单变量情况下取得了成功,但是当我执行多变量线性回归时,我得到了以下错误。我应该如何执行多变量线性回归? TypeError Traceback(最近调用最后一次)in()9optimizer.zero_grad()#渐变10输出=模型(输入)#输出--- /anaconda/envs/tensorflow/lib/python3.6/site-packa

-

PyTorch中RNN(nn. LSTM、nn. GRU等)的输出h_n是如何构建的?

医生说 形状的大小(num\u layers*num\u directions,batch,hidden\u size):包含t=seq\u len的隐藏状态的张量 现在,批次和hidden_size维度几乎不言自明。不过,第一个维度仍然是个谜。 我假设所有层的所有“最后一个单元”的隐藏状态都包含在该输出中。但是,例如,“最上层”中“最后一个单元格”的隐藏状态的索引是什么<代码>h\u n[-1]

-

PyTorch中的“视图”方法是如何工作的?

我对下面代码片段中的方法感到困惑。 我的困惑在于以下几行。 什么是张量。view()函数的作用是什么?我在很多地方见过它的用法,但我不明白它是如何解释它的参数的。 如果我将负值作为参数赋给函数,会发生什么情况?例如,如果我调用,? 有人能用一些例子解释一下函数的主要原理吗?

-

Pytorch Batch范数层不同于Keras Batch范数

我试图将预训练的BN权重从pytorch模型复制到其等效的Keras模型,但我一直得到不同的输出。 我阅读了Keras和Pytorch BN文档,我认为差异在于它们计算“平均值”和“var”的方式。 Pytorch: 平均值和标准偏差是按小批量的每个尺寸计算的 来源:Pytorch BatchNorm 因此,他们对样本进行平均。 Keras: 轴:整数,应规格化的轴(通常是特征轴)。例如,在具有d