《神策数据》专题

-

3.10.4 对齐策略

要实现完美的多分辨率适配效果,UI 元素按照设计分辨率中规定的位置呈现是不够的,当屏幕宽度和高度发生变化时,UI 元素要能够智能感知屏幕边界的位置,才能保证出现在屏幕可见范围内,并且分布在合适的位置。我们通过 Widget(对齐挂件) 来实现这种效果。 下面我们根据要对齐元素的类别来划分不同的对齐工作流: 需要贴边对齐的按钮和小元素 对于暂停菜单、游戏金币这一类面积较小的元素,通常只需要贴着屏幕边

-

5. 策略模式

5.1. 模式动机 完成一项任务,往往可以有多种不同的方式,每一种方式称为一个策略,我们可以根据环境或者条件的不同选择不同的策略来完成该项任务。 在软件开发中也常常遇到类似的情况,实现某一个功能有多个途径,此时可以使用一种设计模式来使得系统可以灵活地选择解决途径,也能够方便地增加新的解决途径。 在软件系统中,有许多算法可以实现某一功能,如查找、排序等,一种常用的方法是硬编码(Hard Coding

-

Tea-用户策略

为了提高语言实用性,Tea将用户分为普通用户和高级用户。 普通用户主要开发业务功能,他们更关心代码的开发效率、易读性和稳定性。 高级用户主要开发底层框架,他们更关心代码的运行效率、可重用性和可扩展性。 Tea 语言提高了大量技术以支持底层开发,但普通用户仍然可以在不了解这些技术的情况下完成任务。 对于普通用户,需要学习的知识有: 变量和函数定义 逻辑语句和常用表达式 简单的面向对象能力。 对于高级

-

网易雷火数值策划面试凉凉经

网易雷火数值策划面试凉凉经面了雷火,被面试官狠狠摧残了,自己提前准备的东西感觉什么都没用上。虽然自己从来没觉得自己能过但是面完还是好难过

-

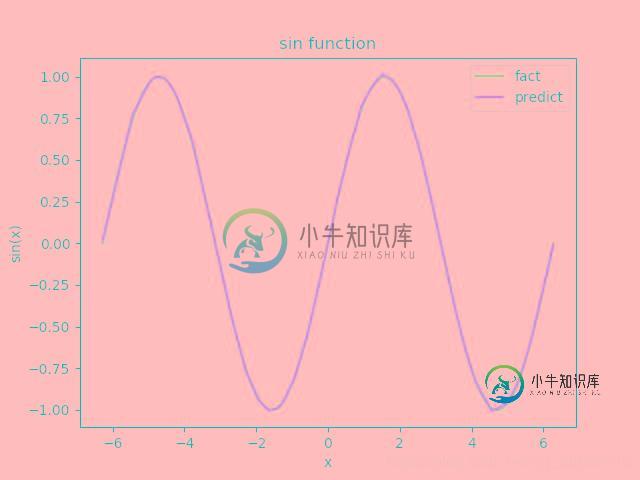

使用 pytorch 创建神经网络拟合sin函数的实现

使用 pytorch 创建神经网络拟合sin函数的实现本文向大家介绍使用 pytorch 创建神经网络拟合sin函数的实现,包括了使用 pytorch 创建神经网络拟合sin函数的实现的使用技巧和注意事项,需要的朋友参考一下 我们知道深度神经网络的本质是输入端数据和输出端数据的一种高维非线性拟合,如何更好的理解它,下面尝试拟合一个正弦函数,本文可以通过简单设置节点数,实现任意隐藏层数的拟合。 基于pytorch的深度神经网络实战,无论任务多么复杂,都

-

220918 字节后端笔试 金字塔 神奇数列 ASDF 书柜

220918 字节后端笔试 金字塔 神奇数列 ASDF 书柜卧槽 节! 第一题 AC 金字塔 方块的宽和高都是1,单位是m;不存在重叠的方块 输入: n表示金字塔的层数,接下来n行,第 i 行表示第 i 层 第一个数m,表示这行有m个方块的左边缘的起始位置p[j] 单位是cm 默认递增 输出: 剩余的方块个数 方块存在至少要满足一个条件: 在第一层 重心在之前一层的方块上 左边缘和右边缘都在之前一层的方块上 不满足条件的方块可认为直接消失 数据范围: 1

-

基于参数共享的卷积神经网络权值计算

基于参数共享的卷积神经网络权值计算在阅读墨菲的《机器学习:概率观点》一书和迈克·奥尼尔的这篇文章时,我遇到了一些关于卷积神经网络中权重数的计算,我想了解这些计算。网络架构如下: 这是上述文章的解释: 第2层也是一个卷积层,但有50个要素地图。每个特征映射是5x5,特征映射中的每个单元是前一层所有6个特征映射对应区域的5x5卷积核,每个是13x13特征映射。因此,第2层中有5x5x50=1250个神经元,(5x5 1)x6x50=7

-

利用Hyperopt调整神经网络参数:如何转储试验

而且,它会在我的本地驱动器上加载一个10GB大小的文件。也就是说,它不仅保存了试验对象,而且保存了整个模型。您能否帮助我保存较小大小的试验对象(例如,XGBoost试验文件的大小为1MB),并避免错误。 谢谢你。

-

图像训练: 用卷积神经网络识别手写数字

在本教程中,我们将构建一个TensorFlow.js模型,用卷积神经网络对手写数字进行分类. 首先,我们将通过“查看”成千上万的手写数字图像及其标签来训练分类器. 然后我们将使用模型从未见过的测试数据来评估分类器的准确性. 先决条件 本教程假设您熟悉TensorFlow.js的基础构建模块 (张量,变量,和操作),以及优化器和损失的概念. 有关这些主题的更多背景信息, 我们建议在本教程之前完成以下

-

说一下卷积神经网络

本文向大家介绍说一下卷积神经网络相关面试题,主要包含被问及说一下卷积神经网络时的应答技巧和注意事项,需要的朋友参考一下 首先是LeNet,七层结构,也就是早期的神经网络,但是中途一直没有得到发展,直到2012年出现了AlexNet,采用了(数据增强,大数据集(imagenet),dropout,relu激活函数,同时使用了GPU)这些技巧,使得准确率得到显著提升;VGG提出了一个新的概念,用小的卷

-

神经网络训练的建议

神经网络训练的建议在本章中,我们将了解可以使用TensorFlow框架实现的神经网络训练的各个方面。 以下几个建议,可以评估 - 1. 反向传播 反向传播是计算偏导数的简单方法,其中包括最适合神经网络的基本形式的合成。 2. 随机梯度下降 在随机梯度下降中,批处理是示例的总数,用户用于在单次迭代中计算梯度。到目前为止,假设批处理已经是整个数据集。最好的例子是谷歌规模; 数据集通常包含数十亿甚至数千亿个示例。 3.

-

人工神经网络是什么

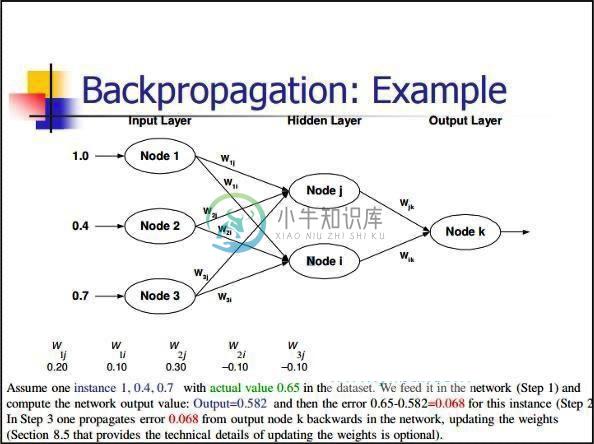

人工神经网络是什么主要内容:MP神经元模型,感知机模型,反向传播算法,总结在本教程的开篇《 人工智能是什么》一节中详细的阐述了深度学习发展历程,以及人工智能、机器学习、深度学习三者间的关系。就目前而言,这三者中红到发紫的当属“深度学习”。 深度学习(Deep Learning)这一概念是由 Geoffrey Hinton(深度学习之父)于 2006 年提出,但它的起源时间要早得多,可追溯至 20 世纪四五十年代,也就是人类刚刚发明出电子计算机时就已经提出来了,但当时并非

-

神经网络的反向传播

我正在尝试实现一个简单的神经网络。我知道已经有很多可用的库,这不是重点。 我的网络只有3层:一个输入层一个隐藏层一个输出层 输出层有8个神经元,每个神经元代表不同的类。 我知道如何实现feedfoward算法,但我真的很难实现反向传播算法。 这是我到目前为止得出的结论: 我尝试使用Iris数据集进行测试:https://en.wikipedia.org/wiki/Iris_flower_data_

-

如何可视化神经网络

我想画一幅神经网络的动态图,观察学习过程中权重的变化和神经元的激活。如何在Python中模拟该过程? 更准确地说,如果网络形状是:[1000,300,50],那么我希望绘制一个三层的神经网络,其中分别包含1000,300和50个神经元。此外,我希望这张图片能够反映出每一时期每一层神经元的饱和程度。 我不知道怎么做。有人能告诉我一些情况吗?

-

多输出卷积神经网络

我正在开发一种卷积神经网络用于图像分类或更好的车牌分类。这些车牌最多包含8个字符,每个字符可以包含37个字符(A-Z、0-9和空格)。我现在想知道如何设计网络中的最后两层。我认为,最后一个必须是具有37个概率的softmax层。这应该完全连接到一个(?)神经元在前一层?我想,在前一层我们需要8个神经元,因为之前的车牌上有8个字符,但我不确定。在此层之前,我添加了一些卷积层和maxPooling层。