《猫眼》专题

-

在熊猫中同时使用loc和iloc

假设我有下面的数据框,我想将

-

熊猫:将两列成对排序[重复]

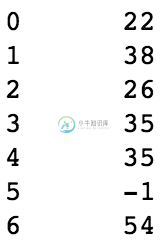

我正在尝试对两个熊猫数据框列进行排序。我知道Python有自己的内置函数: 但我想知道熊猫是否也有这个功能,是否可以将两列作为一对一起完成。 例如,我有以下数据集: 我想获得以下信息: 基本上我在这里做的是,我正在对列“特征”进行排序,以从最小值到最大值,但是我希望“总和”中的相应值也发生变化。 有人能帮我解决这个问题吗?我在Stackoverflow上看到过其他帖子,但是我没有找到解释这个过程的

-

分组/分类年龄列在Python熊猫

分组/分类年龄列在Python熊猫我有一个数据框,上面写着有一列 <代码> 我想对这些年龄段进行分组,并创建一个类似这样的新专栏 如何使用Pandas库实现这一点。 我试过这样做 但这样做我得到了这个警告 /Users/Anand/miniconda3/envs/learn/lib/python3.7/site packages/ipykernel_launcher.py:3:SettingWithCopyWarning:试图在数

-

在熊猫数据框中规范化列

我有一个熊猫数据框,它有语料库的术语频率,术语为行,年份为列,就像这样: 我希望能够通过将每个单词的值除以给定年份的总单词数来标准化它们——有些年份包含两倍多的文本,所以我试图按年缩放(像谷歌图书一样)。我已经看了如何缩放单个列的例子,克里斯·阿尔邦和我在SO上看到了缩放所有列的例子,但是每次我试图将这个数据框转换为一个数组来缩放时,事情都会窒息列这个词不是数字。(我尝试将术语列设置为索引,但不太

-

通过标准查找猫鼬子文档

我刚刚被这个问题缠住了。我有两个猫鼬模式: 问题是,如何从每个父文档中获取所有子文档(在这种情况下,对象)?假设我有一些数据: 我想在一个查询中检索所有18岁以上的儿童。有可能吗?每一个回答都将不胜感激,谢谢!

-

熊猫当月工作日股价数据

上面的问题是假设一周有7天。它试图计算每周有7天。我的数据是由(工作日)每日价格组成的,有时可能会因为市场因假期关闭而错过一周的几天。 我的问题是如何找到给定日期的一个月中的一周。注:我突出了“给定日期”,因为这个过程每天都在处理,所以任何展望到月底的答案都可能不起作用。 我的尝试是向前看,但不是最佳的: 如果你发现这个问题有任何问题,或者它是重复的,请告诉我。我已经寻找了一段时间的解决办法。

-

将熊猫数据帧转换为系列

我对熊猫有些陌生。我有一个熊猫数据框,是一行23列。 我想把它转换成一个系列?我想知道做这件事最像蟒蛇的方式是什么? 我试过pd。系列(我的结果),但它抱怨。它还没有聪明到意识到它仍然是数学术语中的“向量”。 谢谢!

-

Python熊猫-删除nans[重复]的问题

我正在努力去除nans。已经花了一些时间寻找解决方案,但似乎没有任何效果。 下面我附上我的代码样本。整个笔记本可以在我的GitHub这里找到:https://GitHub . com/jarsonX/Temp _ files/blob/main/W3-探索性数据分析(1)。ipynb 我错过了什么? 更新: 我设法过滤掉了南斯:

-

大熊猫read_csv混合dtype失败[重复]

我有一个63 MB的csv文件和患者的血液测试。我无法获得DataFrame。它说: 类型警告:列(5,12,20,21,22,23,24,25,26,30,32,35,36,37,38,39,40,41,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64请在导入时指定dtype选项,或者设置low_memory=Fa

-

熊猫重置索引未生效[重复]

熊猫重置索引未生效[重复]我不确定我在哪里误入歧途,但我似乎无法重置数据帧上的索引。 当我运行时,我得到下面的输出: 如您所见,数据帧是一个切片,因此索引超出了范围。我想做的是重置此数据帧的索引。所以我运行。这将产生以下结果: 这看起来像是一个新的索引,但事实并非如此。运行同样,索引仍然相同。试图使用或会导致数据帧出现问题。 如何才能真正重置索引?

-

按行筛选熊猫数据帧[重复]

按行筛选熊猫数据帧[重复]我想过滤熊猫DataFrame,它从DataFrame中过滤掉除值中声明的行之外的所有其他列。我如何才能做到这一点并获得预期输出。 预期输出:

-

获取下面的日志在日志猫

我要把这个日志放进我的日志里 I/zygote:后台并发复制GC释放148531(5MB)AllocSpace对象,18(936KB)LOS对象,32%自由,12MB/18MB,暂停3.758ms总计217.199ms 这是需要解决的问题还是可以忽略的问题

-

熊猫求和再除以唯一计数

我有一个df看起来是这样的: 现在我想创建一个名为temp_test的df,它显示日期、收入总和、唯一篮子ID的计数,最后还有一列每个篮子的平均收入。 但是,我的rev_per_basket列只显示了NAN。理想情况下,它应该显示226.66、475和450。知道哪里出了问题吗?谢谢!

-

如何合并 pyspark 和熊猫数据帧

我有一个非常大的 pyspark 数据帧和一个较小的熊猫数据帧,我读入如下: 这两个数据帧都包含标记为“A”和“B”的列。我想创建另一个 pyspark 数据帧,其中只有 df1 中的那些行,其中“A”和“B”列中的条目出现在 中同名的列中。也就是说,使用 df2 的列“A”和“B”过滤 df1。 通常我认为这将是一个连接(通过实现),但是如何将熊猫数据帧与 pyspark 数据帧连接起来? 我负

-

熊猫附加不同于文件[副本]

这正是我正在做的 试图得到这个结果 我得到的是 我已经尝试了这些参数的所有组合,但它总是向我显示一堆新行,这些行的值位于新的分隔列上,而且它还更改了我在初始数据集中定义的列的顺序。(我也尝试了。concat的各种功能,但它仍然给出了类似的问题,wven使用Axis=0) 因为即使是文档中的示例在代码结构相同的情况下也没有显示这个结果,如果有人能告诉我发生了什么,为什么发生了什么,以及如何修复这个问