TensorRT 是一个高性能深度学习推理平台,它包括深度学习推理优化器和运行时,可为深度学习推理应用提供低延迟和高吞吐量。在推理期间,基于 TensorRT 的应用比仅 CPU 平台的执行速度快 40 倍。

TensorRT 基于 CUDA,NVIDIA 的并行编程模型,能够利用 CUDA-X AI 中的库、开发工具和技术,为人工智能、自动机器、高性能计算和图形优化所有深度学习框架的推理。

此库包含 TensorRT 插件和解释器(Caffe 和 ONNX),还有一些演示 TensorRT 平台的使用和功能的示例应用。

-

序言 这篇文章总结了训练好的pytorch模型转成tensorrt模型部署的几种方式,转换原理流程大致如下: 导出网络定义以及相关权重; 解析网络定义以及相关权重; 根据显卡算子构造出最优执行计划; 将执行计划序列化存储; 反序列化执行计划; 进行推理 值得注意的是第三点,可以看到tensorrt转换出来的模型实际上是和硬件绑定的,也就是在部署的过程中,如果你的显卡和显卡相关驱动软件(cuda、c

-

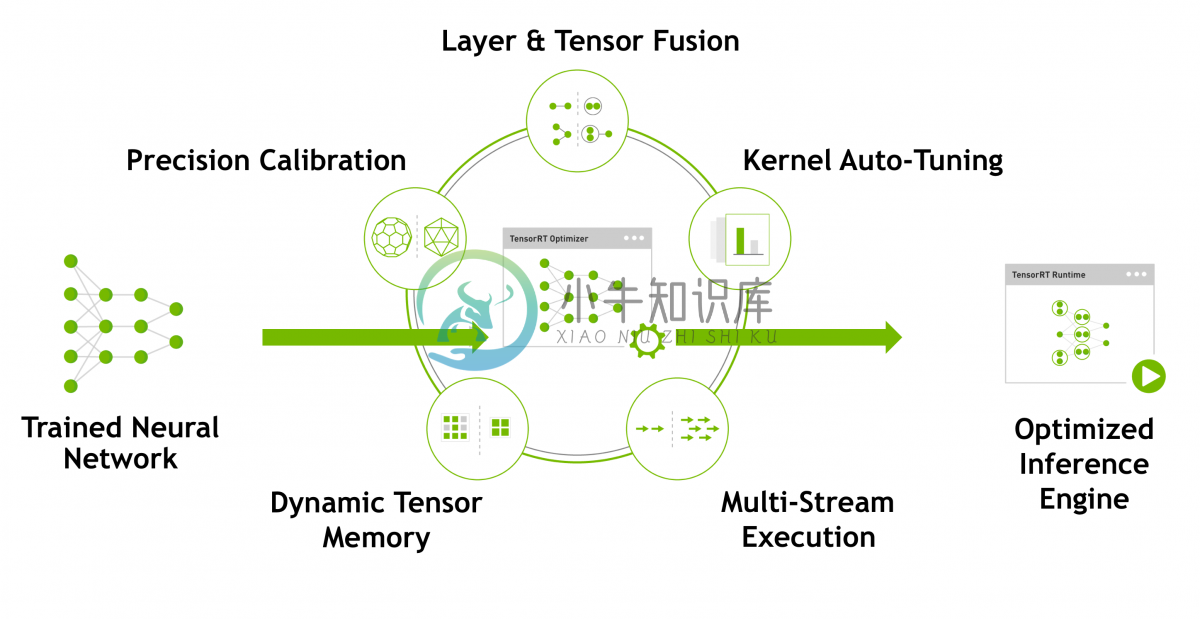

NVIDIA TensorRT是一种高性能神经网络推理(Inference)引擎,用于在生产环境中部署深度学习应用程序,应用有图像分类、分割和目标检测等,可提供最大的推理吞吐量和效率。TensorRT是第一款可编程推理加速器,能加速现有和未来的网络架构。TensorRT需要CUDA的支持。TensorRT包含一个为优化生产环境中部署的深度学习模型而创建的库,可获取经过训练的神经网络(通常使用32位

-

0. 前言 之前浏览过Python API并输出了笔记,但在实际使用过程中,上次的笔记没有任何卵用…… 所以,本文根据 API 提供的几个功能,分别介绍相关API以及实例,希望下次用到TensorRT的时候,可以直接在这里复制粘贴。 资料: 官方samples: 在官方Github都能看到,这里还列出了Python实例。 Github: ensorrt-demo:TRT内容不多,有不少 TF 相关

-

1、查看cuda与cudnn的版本 nvcc- V 2、在tensorrt官网上查找对应版本的tensorrt https://developer.nvidia.com/nvidia-tensorrt-download 下载并解压缩至自己期望的目录中 3、添加环境变量 打开bashrc文件 sudo ~/.bashrc 在bashrc文件中添加环境变量 #tensort export LD_L

-

本文首发于https://yangzhenyu.tech/ 作者:Frank 导读:本文主要带来对TensorRT中自带的sample:sampleOnnxMNIST的源码解读,官方例程是非常好的学习资料,通过吃透一个官方例程,就可以更加深刻地了解TensorRT的每一步流程,明白其中套路,再去修改代码推理我们自己的网络就是很容易的事情了。 TensorRT的一份源码要怎么看?TensorRT是一

-

1 什么是TensorRT 一般的深度学习项目,训练时为了加快速度,会使用多GPU分布式训练。但在部署推理时,为了降低成本,往往使用单个GPU机器甚至嵌入式平台(比如 NVIDIA Jetson)进行部署,部署端也要有与训练时相同的深度学习环境,如caffe,TensorFlow等。由于训练的网络模型可能会很大(比如,inception,resnet等),参数很多,而且部署端的机器性能存在差异,就

-

1. Tensorrt安装 最近考虑对已经训练好的Pytorch模型进行Float16优化,以达到部署时inference减小耗时,显存开销。可是很多博客写的乱七八糟,我这里整理一份自己安装的过程。供大家参考。 首先我们需要查看自己服务器或者GPU是什么版本的驱动,然后才可以安装对应版本的Tensorrt 1.1 查看cuda版本 [~]$ nvcc -V nvcc: NVIDIA ® Cuda

-

面了英伟达的GPU C++ Modeling Engineer 投递的时候看要求是熟练掌握C++ 结果面试的时候都是体系结构 人麻了,一点没看 问的都是cache之类的,梦回大二的组成原理,但是那书早被我卖了,几百年没看了 问面试官,是不是岗位不太匹配 面试官说,体系结构这么不熟的头一次见 跟面试官说直接放弃面试了,感觉她面的也挺难受的 还是等华子泡出来吧,折腾来折腾去也挺累了 #24届软开秋招面

-

software testing -drive sim部门 c++: 1.顺时针旋转90度二维矩阵 用的是轮转的方法,问是否可以直接交换? 180度旋转呢? 2.虚函数是什么?父类里面virtual关键字的 3.static可以当虚函数吗?不可以,因为虚函数在运行的时候才知道要调用父类还是子类方法。static是在编译的时候就知道了。 4.你对自动驾驶有了解吗? 5.英伟达gpu有了解吗? 6.s

-

问题列表 《深度学习》 8.4 参数初始化策略 一般总是使用服从(截断)高斯或均匀分布的随机值,具体是高斯还是均匀分布影响不大,但是也没有详细的研究。 但是,初始值的大小会对优化结果和网络的泛化能力产生较大的影响。 一些启发式初始化策略通常是根据输入与输出的单元数来决定初始权重的大小,比如 Glorot and Bengio (2010) 中建议建议使用的标准初始化,其中 m 为输入数,n 为输出

-

#英伟达面经# 攒人品 岗位是deep learning performance architect intern,base上海,中文面试 大概是40min左右的自我介绍,介绍实习经历/项目的过程中针对细节提问,非常个人化,而且由于面试官做的是偏底层的,问的问题也会往底层考,有些答上来了有些没答出来。 因为有icpc/ccpc经历,40min之后又问了一些基础的算法问题,最后问了一个特别简单的co

-

主要内容 课程列表 专项课程学习 辅助课程 论文专区 课程列表 课程 机构 参考书 Notes等其他资料 卷积神经网络视觉识别 Stanford 暂无 链接 神经网络 Tweet 暂无 链接 深度学习用于自然语言处理 Stanford 暂无 链接 自然语言处理 Speech and Language Processing 链接 专项课程学习 下述的课程都是公认的最好的在线学习资料,侧重点不同,但推

-

Google Cloud Platform 推出了一个 Learn TensorFlow and deep learning, without a Ph.D. 的教程,介绍了如何基于 Tensorflow 实现 CNN 和 RNN,链接在 这里。 Youtube Slide1 Slide2 Sample Code

-

本来想着国庆后再投,怕国庆过不好,国庆前就投了,很多东西没复习。面了几家最后接百度了,谢谢百度收留我。 cpp基础部分 1.static 2.const 3.cpp内存结构 4.谈谈那几个智能指针 5.那四个强制转换 6.看.so动态库里的啥东西,这个不会,连题意都没记全,太菜了。 7.析构函数能不能传参,能不能有返回值 8.cpp的多态,运行时多态那问的具体怎么实现,我就说了说虚函数表那些,感觉

-

全程拷打项目(因为项目是和tf与机器学习相关的) 手写conv2D的计算函数(因为项目里有个conv3D相关的tf算子,但是没有写出来) 手写nms算法(写得很慢,之前又因为也是做项目,没有仔细研究源码) 之前使用opencl比较多,cuda使用得比较少,而且机器学习相关的算法也不是很精通,第二天就挂了