QNNPACK (Quantized Neural Networks PACKage) 是一款针对移动 AI 进行优化的高性能内核库。这个库加速了多项操作,包括高级神经网络架构所使用的深度卷积。

QNNPACK 的目标并非是由机器学习研究人员直接使用,相反,它旨在为高级深度学习框架提供低级性能原语(low-level performance primitives)。QNNPACK 已经被集成到 Facebook 的一系列应用程序中,并被部署在全球的 10 亿台移动设备上。

QNNPACK 也已集成在 PyTorch 1.0 中,并已支持 Caffe2 模型表示。

-

与浮点计算一样,依旧是4x8的分块,为防止饱和将uint8塞进int16进行计算,这样一个寄存器装载8个数,本篇主要关注指令集。 指令集总结: vld1_dup_u8(const uint8_t*):广播broadcast uint8_t到8x8 vld1_u8(const uint8_t*):加载8x8 vmovl_u8(const uint8x8_t):扩展指令集,返回uint16x8

-

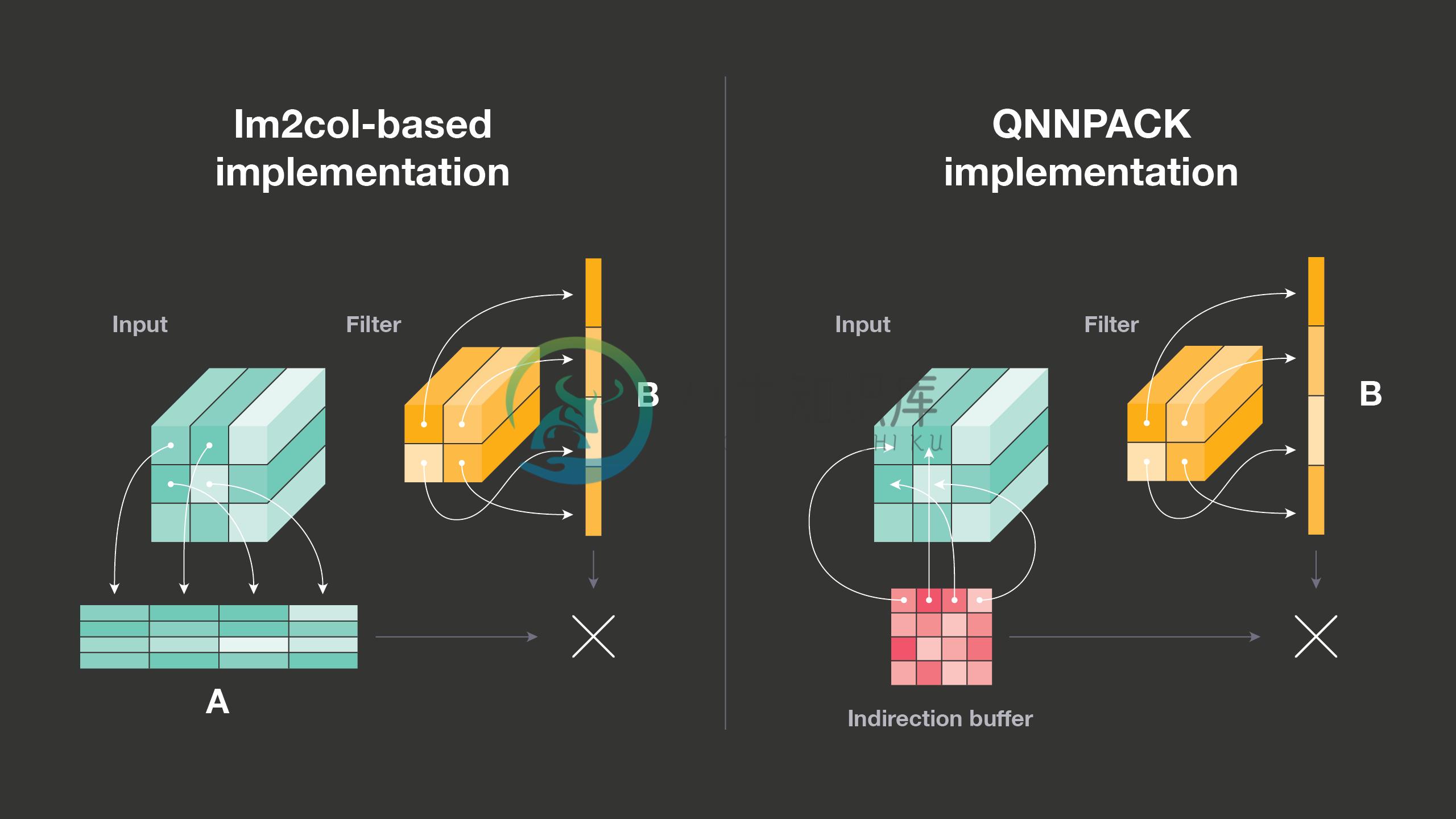

46.1 深度卷积 分组卷积(grouped convolution)将输入和输出通道分割成多组,然后对每个组进行分别处理。在有限条件下,当组数等于通道数时,该卷积就是深度卷积,常用于当前的神经网络架构中 深度卷积对每个通道分别执行空间滤波,展示了与正常卷积非常不同的计算模式。因此,通常要向深度卷积提供单独实现,QNNPACK 包括一个高度优化版本 3×3 深度卷积。 深度卷积的传统实现是每次都在

-

本节将讨论优化与深度学习的关系,以及优化在深度学习中的挑战。在一个深度学习问题中,我们通常会预先定义一个损失函数。有了损失函数以后,我们就可以使用优化算法试图将其最小化。在优化中,这样的损失函数通常被称作优化问题的目标函数(objective function)。依据惯例,优化算法通常只考虑最小化目标函数。其实,任何最大化问题都可以很容易地转化为最小化问题,只需令目标函数的相反数为新的目标函数即可

-

本书将全面介绍深度学习从模型构造到模型训练的方方面面,以及它们在计算机视觉和自然语言处理中的应用。

-

本书将全面介绍深度学习从模型构造到模型训练的方方面面,以及它们在计算机视觉和自然语言处理中的应用。Github 地址:https://github.com/d2l-ai/d2l-zh

-

主要内容 课程列表 专项课程学习 辅助课程 论文专区 课程列表 课程 机构 参考书 Notes等其他资料 卷积神经网络视觉识别 Stanford 暂无 链接 神经网络 Tweet 暂无 链接 深度学习用于自然语言处理 Stanford 暂无 链接 自然语言处理 Speech and Language Processing 链接 专项课程学习 下述的课程都是公认的最好的在线学习资料,侧重点不同,但推

-

Google Cloud Platform 推出了一个 Learn TensorFlow and deep learning, without a Ph.D. 的教程,介绍了如何基于 Tensorflow 实现 CNN 和 RNN,链接在 这里。 Youtube Slide1 Slide2 Sample Code

-

本文向大家介绍用过哪些移动端深度学习框架?相关面试题,主要包含被问及用过哪些移动端深度学习框架?时的应答技巧和注意事项,需要的朋友参考一下 参考回答: 开源的有:小米的MACE,骁龙的SNPE,腾讯的FeatherCNN和ncnn,百度的mobile-deep-learning(MDL);caffe、tensorflow lite都有移动端,只是可能没有上面的框架效率高。据传还有支付宝的xNN,商

-

现在开始学深度学习。在这部分讲义中,我们要简单介绍神经网络,讨论一下向量化以及利用反向传播(backpropagation)来训练神经网络。 1 神经网络(Neural Networks) 我们将慢慢的从一个小问题开始一步一步的构建一个神经网络。回忆一下本课程最开始的时就见到的那个房价预测问题:给定房屋的面积,我们要预测其价格。 在之前的章节中,我们学到的方法是在数据图像中拟合一条直线。现在咱们不

-

深度学习的总体来讲分三层,输入层,隐藏层和输出层。如下图: 但是中间的隐藏层可以是多层,所以叫深度神经网络,中间的隐藏层可以有多种形式,就构成了各种不同的神经网络模型。这部分主要介绍各种常见的神经网络层。在熟悉这些常见的层后,一个神经网络其实就是各种不同层的组合。后边介绍主要基于keras的文档进行组织介绍。