《scala》专题

-

如何使用Docker在Spark容器中运行Scala代码?

问题内容: 我使用以下Dockerfile创建了一个Spark容器: 我还有两个用Scala编程语言编写的文件,这对我来说听起来很新。问题在于容器只知道Java,而没有安装任何其他命令。有什么方法可以在容器上没有安装任何程序的情况下运行Scala? 文件名是和。这是initDocuments.scala文件: 我也尝试了以下方法,但不起作用。 错误: PS: 我试图使用以下命令来更改代理地址,但我

-

Scala案例分类和不可变性

本文向大家介绍Scala案例分类和不可变性,包括了Scala案例分类和不可变性的使用技巧和注意事项,需要的朋友参考一下 示例 Scala编译器默认在参数列表中为每个参数加上前缀val。这意味着,默认情况下,案例类是不可变的。每个参数都具有一个访问器方法,但是没有可变器方法。例如: 在案例类中将参数声明为var会覆盖默认行为,并使案例类可变: 案例类为“可变”的另一个实例是案例类中的值是可变的: 请

-

Scala语言基本设置

本文向大家介绍Scala语言基本设置,包括了Scala语言基本设置的使用技巧和注意事项,需要的朋友参考一下 示例 创建一个SCALA_PROJECT/build.gradle具有以下内容的文件: 运行gradle tasks以查看可用任务。 运行gradle create-dirs以创建src/scala, src/resources目录。 运行gradle build以构建项目并下载依赖项。

-

Scala将Scala集合转换为Java集合,反之亦然

本文向大家介绍Scala将Scala集合转换为Java集合,反之亦然,包括了Scala将Scala集合转换为Java集合,反之亦然的使用技巧和注意事项,需要的朋友参考一下 示例 当您需要将集合传递到Java方法中时: 如果Java代码返回Java集合,则可以通过类似的方式将其转换为Scala集合: 请注意,这些是装饰器,因此它们仅将基础集合包装在Scala或Java集合接口中。因此,通话.asJa

-

Scala特质基础

本文向大家介绍Scala特质基础,包括了Scala特质基础的使用技巧和注意事项,需要的朋友参考一下 示例 这是Scala中特性的最基本版本。 由于没有为trait声明超类Identifiable,因此默认情况下它是从AnyRefclass扩展的。因为没有getIdentifier提供的定义Identifiable,所以Puppy该类必须实现它。然而,Puppy继承的实现printIdentific

-

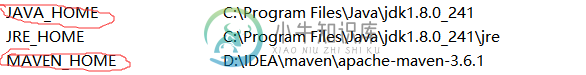

在IDEA中安装scala、maven、hadoop遇到的问题小结

在IDEA中安装scala、maven、hadoop遇到的问题小结本文向大家介绍在IDEA中安装scala、maven、hadoop遇到的问题小结,包括了在IDEA中安装scala、maven、hadoop遇到的问题小结的使用技巧和注意事项,需要的朋友参考一下 小白在通过IDEA使用scala、maven、hadoop遇到的问题 问题一:idea new 新文件没有scala;File->setting->Plugins,然后搜索scala插件安装。安装完成后重

-

Scala没有参数的实例化类:{} vs()

本文向大家介绍Scala没有参数的实例化类:{} vs(),包括了Scala没有参数的实例化类:{} vs()的使用技巧和注意事项,需要的朋友参考一下 示例 假设我们有一个MyClass类,没有构造函数参数: 在Scala中,我们可以使用以下语法实例化它: 或者我们可以简单地写: 但是,如果不注意,在某些情况下,可选的括号可能会产生某些意外的行为。假设我们要创建一个任务,该任务应在单独的线程中运行

-

Spring Cloud数据流自定义Scala处理器无法从Starter Apps(SCDF 2.5.1)发送/接收数据

我一直在为Spring云数据流在Scala中创建一个简单的自定义处理器,并且在向starter应用程序发送/接收数据时遇到了问题。我无法看到任何消息在流中传播。流的定义是时间触发器。时间单位=秒|传递日志|日志其中传递日志是我的自定义处理器。 我使用的是Spring Cloud Data Flow 2.5.1和Spring Boot 2.2.6。 这是处理器使用的代码-我使用的是功能模型。 应用y

-

为什么scalatest不能编译?

我有一个简单的测试设置,如 但当我尝试编译测试时,我会遇到53个错误,比如 实际上并没有传达任何关于问题所在的有用信息。我只能假设在我的构建中没有正确配置某些内容。sbt文件或其他地方。 这段代码确实曾经工作过,在我清理东西的过程中,事情发生了变化,现在它被破坏了,没有好的诊断。 有人能提出要找的东西吗?

-

ScalaTest v3:为什么需要实现convertToLegacyEqualizer

使用ScalaTest 3.0.0环境:Scala 2.11.8、sbt 0.13.5、IntelliJ 14.1.4 建筑sbt只有 以下测试通过。然而,IntelliJ在MyMiniTest下方标记了一条弯曲的红线,并显示警告信息: 类“MyMiniTest”必须声明为抽象的,或实现抽象成员“convertToLegacyEqualizer[T](左:T):TripleEqualSupport

-

Maven模块找不到scalatest的依赖项

在使用scalatest时,我遇到了一个奇怪的问题。我有一个带有多个模块的maven项目。如果我直接在模块中执行mvn测试。它可以正常工作,但如果在根文件夹中执行,它会抱怨编译时缺少包(依赖项)。 我的配置如下所示: 插件配置: 如果我从maven scala插件中删除目标,它将编译,但scalatest将找不到测试源并退出,并且没有执行任何测试 : 你知道我做错了什么吗?! 干杯

-

使用Java包含Scalatest时Maven构建失败

我正在尝试使用scala-maven-plugin: 3.1.0和Java1.5。然而,我的maven构建失败,出现不兼容错误。 还有一个不支持的类版本警告 插件的文档说明它需要Java 1.5,所以我看不出有什么问题。我在本地使用Java 1.5,也在maven构建中使用。 对问题所在有何建议?我不知道在哪里可以使用另一个版本的Java来编译我的任何类,所以我猜测这是我的一个依赖项中的不兼容,但

-

Scala将元组向量映射到对象向量

我试图将元组向量转换为向量[人],但上面的代码会导致强制转换异常,即使存在隐式的元组-人转换函数? 线程“main”java中出现异常。lang.ClassCastException:scala。Tuple2无法转换为示例。例如,测试$人。测试$$anonfun$2$$anonfun$应用$1。在scala应用(测试scala:19)。收集迭代器$类。scala上的foreach(迭代器。scal

-

PyFlink-Scala UDF-如何在表API中转换Scala映射?

我正在尝试将Scala UDF( 的(嵌套)Scala对象? 代码 Scala自定义项 下沉 错误 谢谢

-

如何计算spark scala中的数据帧大小

我想编写一个具有重分区的大型数据帧,所以我想计算源数据帧的重分区数。 数据帧/default_blocksize的大小 所以请告诉我如何在spark scala中计算数据帧的大小 提前谢谢。