《scala》专题

-

将带有List的scala hashmap转换为带有java List的java hashmap

我是scala和Spark的新手,我有以下大小写类A ClassCastException:Scala.Collection.Mutable.WrappDarRay$OFRef不能强制转换为java.util.List 请帮忙。

-

使用Scala将Spark Dataframe上的多列转换为一列map

我有一个数据帧,它有可变数量的列,如Col1,Col2,Col3。我需要使用下面的代码将Col1和Col2合并到一列数据类型映射中。 但是在不知道列的数量和名称的情况下,如何对所有的列都这样做呢?

-

Amazon SES证书格式-将Scala应用程序(Play框架)从Sendrid迁移到SES

我正在尝试使用Sendgrid将Scala应用程序(Play framework)迁移到AmazonSES。我在SES中有一个注册域,正在尝试通过SMTP接口发送电子邮件。我通过控制台生成了一个具有SMTP用户名(看起来像访问密钥)和SMTP密码(看起来像密钥ID)的IAM用户。我得到的。 我通读并将秘密访问密钥转换为亚马逊SES SMTP密码,使用https://docs.aws.amazon.

-

Intellij:基于SBT的Scala项目不构建Java9

我尝试将基于Scala/sbt的项目切换到Java9。如果我用sbt编译项目,它就可以工作。 如果我尝试使用IntelliJ的build选项构建项目,我会立即得到错误 我尝试添加模块作为依赖项 并添加到IntelliJ的编译器设置中(javac以及scala编译器) 但不幸的是,没有帮助。

-

使用spring mvc的scala中的JSR303 ConstraintValidator

我已经混合了斯卡拉-Java spring-引导mvc项目。我试图使用 实现请求bean的自定义验证器,我从这里和其他线程中了解到,用Java编写注释更好,scala支持JSR-303验证吗? 我用Java编写了自定义约束注释,用scala编写了ConstraintValidator类,但当我指定@Constraint(validatedBy=ScalacustomerValidator.clas

-

当我在Scala中发现数据处于不一致状态时,要抛出哪个异常?

我有一个从数据源读取数据的小型Scala程序。此数据源当前是一个。csv文件,因此它可能包含数据不一致。 在为我的数据实现存储库模式时,我实现了一个方法,该方法将通过一个应该是唯一的特定字段返回一个对象。然而,我不能保证它真的是独一无二的,就像在一个游戏中一样。csv文件,我不能像在真实数据库中那样强制执行数据质量。 因此,该方法检查存储库中是否有一个或零个具有请求的字段值的对象,这很好。但我对S

-

Scala:项目包含Akka时的Spark异常

我有一个使用spark的项目,我想在其中使用Akka。该项目以前工作得很好,但当我将此添加到中时: 并尝试运行该项目,我得到以下错误: [错误](run-main-0)org.apache.spark.sparkException:作业由于阶段失败而中止:任务序列化失败:java.lang.ClassNotFoundException:Scala.Function0 [错误]java.lang.C

-

无法使用scala解密OpenSSL生成的私钥

我已经使用openssl生成了一个私钥,并在Terminal/command中执行以下命令: null 所有这些都无法解密我的密钥。下面是我根据这篇文章编写的类[https://stackoverflow.com/questions/35276820/decrypting-an-openssl-pem-encoded-rsa-privest-key-with-java]: 我对安全问题一无所知,所

-

如何在scala中用数字创建TestNG数据提供程序?

这听起来很愚蠢,但我在StackOverflow或Google上都找不到答案。我需要做一件非常简单的事情——将一个每个集合中包含两个数字的数据提供程序传递给我的TestNG测试,但我没有成功。这是我的代码: 我的测试看起来是这样的 当我试图运行它时,我得到下一条错误消息: 数据提供程序公共java.lang.Object[]必须返回Object[][]或Iterator[],而不是类[Ljava.

-

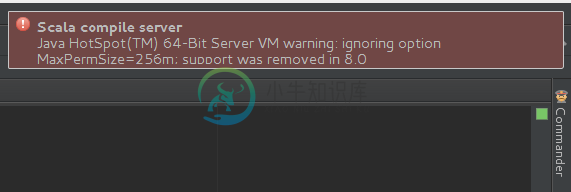

Scala 编译服务器 - VM 警告 [重复]

Scala 编译服务器 - VM 警告 [重复]我在一个项目中使用java scala(与sbt一起)。 语言信息: 当我运行任何时,我得到一个奇怪的警告提示: 我无法理解这种行为。 更新: 我检查了 选项,它具有相同的行为: 感谢这么快的解释1.8Java新功能! 但是如何解决警告的发生? 以下是的内容: Eclipse有< code>eclipse.ini: 更新2 我从两个配置文件中删除了包含的所有行。 但是这个错误警告一直出现(当<co

-

在Scala-Spark1.5.2中递归过滤RDD

我有一个有50列的RDD,我想为每一行获取第一个元素和最后5列,其中最后一行的第一个字符的值是一个数字,如果最后一列的第一个字符是一个字符,重复地继续这个过程。例如,让我们假设原始RDD具有以下内容(为了使其更容易被读取,没有包含键): 按照这个语法,我还可以过滤原始RDD的第N个元素: 我的问题是,是否有任何可能的方法来迭代地指定映射和/或过滤器中的元素范围或类似的东西,并在一对或一个句子中执行

-

Spark-Scala RDD

我有一个RDD,其模式如下: (我们称之为) 我希望创建一个新的RDD,每一行都为,键和值属于。 我希望输出如下: 有人能帮我处理这段代码吗? 我的尝试: 错误:值映射不是Char的成员 我理解这是因为map函数只适用于,而不是每个。请帮助我在中使用嵌套函数。

-

Spark/Scala:将RDD传递给函数

我很好奇在Spark中把一个RDD传递给一个函数到底做了什么。 假设我们如上定义一个函数。当我们调用函数并传递一个现有的RDD[String]对象作为输入参数时,这个my_function是否将这个RDD作为函数参数进行“复制”?换句话说,是按引用调用还是按值调用?

-

在Apache Spark(Scala)中使用reduceByKey

如何实现reduceByKey而不是上面的代码来提供相同的映射?

-

将包含选项卡的代码粘贴到scala repl中

那么,有什么方法可以将带有选项卡的代码放入REPL中呢?