《高可用》专题

-

MongoDB中的高可用性

大家都说mongoDB是CAP定理中的CP!但通过使用主从复制,它也具有高可用性(如果主复制失败,其余成员将自动尝试选择新的主复制)。我的问题是,在什么情况下(以及如何)它可以有AP(最终的一致性)?

-

Verticles - 高可用性(High Availability)

高可用性 (HA)可以在Verticles deployed时启动,当vert.x 的实例突然死了,从集群重新部署另外的vert.x 实例。 若要启用高可用性运行verticle,只是追加-ha开关: vertx run my-verticle.js -ha 当启用高可用性,无需添加-cluster。 有关高可用性功能和配置的高可用性和故障转移(High Availability and Fail

-

火花流和高可用性

我正在构建作用于多个流的Apache Spark应用程序。 我确实阅读了文档中的性能调优部分:http://spark.apache.org/docs/latest/streaming-programming-guide.html#performan-tuning 我没有得到的是: 1)流媒体接收器是位于多个工作节点上,还是位于驱动程序机器上? 2)如果接收数据的节点之一失败(断电/重新启动)会发

-

CAS的高可用性配置

我在Java8和Tomcat8上实现了高可用性的CAS5,用haproxy作为负载均衡器,redis作为票证注册中心。对于票证注册表,请遵循此处给出的详细信息。关于部署,CAS部署在两个tomcats上,即T1和T2。 如果我没有关闭登录的实例,那么就没有问题,可以注销,票证被成功销毁。 我试过两种方法。 使用tomcat会话复制。已将添加到CAS中,并在中添加未注释的. 没有会话复制。

-

诊断高可用性--ActiveMQ Artemis

在ActiveMQ Artemis中有诊断HA问题的方法吗?我有一对共享存储服务器,工作非常好。当我关闭主服务器时,副服务器接管,直到主服务器告诉它它恢复了,然后主服务器接管,副服务器恢复为副服务器。 我把配置复制到另一对服务器上,但这一台不起作用。 据我所知,一切看起来都很好。群集出现在控制台中,两个服务器连接。当我关闭主服务器时,辅助服务器会记录以下消息: 在工作对中,就在这条消息之后,第二个

-

集群部署 - HAProxy高可用

在每个 HAproxy 节点上安装和配置 keepalived 来实现浮动 IP 地址。 CentOS 7: yum install keepalived 假设配置了两个 HAproxy 节点:node1、node2 在node1上修改 keepalived 配置文件(/etc/keepalived/keepalived.conf),写入如下内容: ! Configuration File for

-

7. 实践案例 - 高可用

Kubernetes 从 1.5 开始,通过 kops 或者 kube-up.sh 部署的集群会自动部署一个高可用的系统,包括 etcd 集群模式 apiserver 负载均衡 controller manager、scheduler 和 cluster autoscaler 自动选主(有且仅有一个运行实例) 如下图所示 注意:以下步骤假设每台机器上 Kubelet 和 Docker 已配置并处于

-

部署高可用 etcd 集群

kuberntes 系统使用 etcd 存储所有数据,本文档介绍部署一个三节点高可用 etcd 集群的步骤,这三个节点复用 kubernetes master 机器,分别命名为etcd-host0、etcd-host1、etcd-host2: etcd-host0:10.64.3.7 etcd-host1:10.64.3.8 etcd-host2:10.66.3.86 使用的变量 本文档用到的变量

-

创建高可用etcd集群

kuberntes 系统使用 etcd 存储所有数据,本文档介绍部署一个三节点高可用 etcd 集群的步骤,这三个节点复用 kubernetes master 机器,分别命名为test-001.jimmysong.io、test-002.jimmysong.io、test-003.jimmysong.io: test-001.jimmysong.io:172.20.0.113 test-002.j

-

事务分组与高可用

最佳实践1:TC的异地多机房容灾 假定TC集群部署在两个机房:guangzhou机房(主)和shanghai机房(备)各两个实例 一整套微服务架构项目:projectA projectA内有微服务:serviceA、serviceB、serviceC 和 serviceD 其中,projectA所有微服务的事务分组tx-transaction-group设置为:projectA,projectA正

-

集群部署 - 可扩展高可用集群

本文档提供一个可扩展、高可用的 Seafile 集群架构。这种架构主要是面向较大规模的集群环境,可以通过增加更多的服务器来提升服务性能。如果您只需要高可用特性,请参考3节点高可用集群文档。 架构" class="reference-link"> 架构 Seafile集群方案采用了3层架构: 负载均衡层:将接入的流量分配到 seafile 服务器上。并且可以通过部署多个负载均衡器来实现高可用。 Se

-

JFrame可调整高度

问题内容: 允许用户调整窗口的宽度和高度。是否存在允许用户仅调整高度大小的方法? 谢谢。 编辑: 下面的解决方案似乎不起作用。在360x600 JFrame上, 仍然允许完全拉伸JFrame的宽度,而设置则不允许任何拉伸。 问题答案: 下面的代码可以正确完成工作。

-

高可用和集群简述 - 高可用主要场景和对应思路

适用于redis非重度用户,内存占用不大,总体内存大小的增长趋势可预估,有一定停机时间的系统——纵向扩容即可满足,可以对全库进行主从复制即满足需求而不需要做分片,一般针对单个小型项目的cache 等场景。一般采用一主多从的sentinel方案进行部署。

-

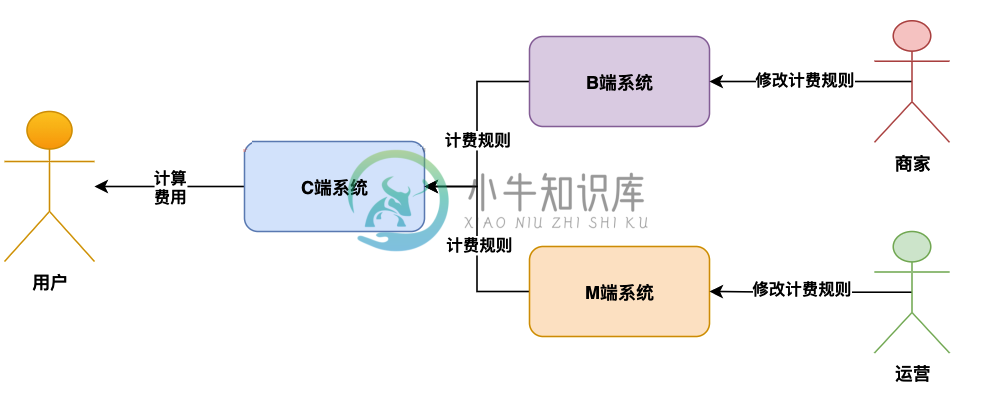

高可用高并发架构系统该如何设计?

高可用高并发架构系统该如何设计?主要内容:背景,计费业务系统架构设计,计费业务数据补偿系统设计,总结背景 今天给大家分享一个话题,就是对于线上跟钱有关的计费类的系统,在线上可能出现的一些把钱算错的问题,以及我们如何来设计架构解决这些问题。 但凡是跟算钱相关的系统,都是每个公司的重中之重,比如说价格系统、运费系统、计费系统、支付系统、基金系统、财务系统、结算系统等等,因为这些系统运行过程中,随时可能因为技术问题或者运营的人为误操作问题,把钱给算错了。 所以今天来给大家讲讲这一类跟算钱有关的系统,我

-

Kafka 和 ZookePeer 高可用性配置

我想在我的生态系统中建立一个高可用性的kafka-zookeper。我有2个数据中心,每个数据中心有3台物理服务器。 服务器1-第一个Kafka经纪人 服务器2-第二个Kafka代理 服务器3-第三个Kafka Broker 所以一个具有 3 个代理的 Kafka 集群 Zookepeer集成-3个物理服务器中的3个zookeeper实例 配置与DC1相似 现在我的问题是- 通过执行上述设置,我们