《运筹优化》专题

-

优化oracle jdbc批插入

我需要使用JDBC在Oracle数据库中进行大量插入,即两位数百万。为此,我使用了类似于以下类的东西,灵感来自使用JDBC进行批处理插入的高效方法: 虽然这种插入方式很好,但速度非常慢。JDBC batch insert performance描述了MySQL基本上可以解决这个问题,因为在Oracle上似乎不存在,但在这里没有太大帮助。 为了提高性能,我还尝试将语句切换为一个大的

-

优化tomcat启动时间

我的应用程序非常大,例如,在web inf/lib中包含310个JAR,总计100Mb。启动服务器,以下步骤需要13秒: 该应用程序依赖于web片段和注释来正确启动。 我尝试了以下方法来跳过13秒的扫描时间: > 修改<code>conf/context。属性为logEffectiveWebXml=“true”的xml 中提取< code>web.xml片段,将其保存在< code > web a

-

Volatile和编译器优化

如果关闭了编译器优化(gcc-o0...),那么说'volatile'关键字没有区别是可以的吗? 我制作了一些示例“C”程序,并且仅当打开编译器优化时,才在生成的汇编代码中看到易失性和非易失性之间的区别,即((gcc-o1....)。

-

优化Node.js内存消耗

不是内存泄漏或类似的问题,因为第一次连接后内存使用量不会增加,所以优化可能是加载更少的模块或做一些不同的事情...

-

优化阵列的分区

我当时正在解决一个编程挑战问题,但我的解决方案是对大量数据给出超时/错误。有人能帮我优化解决方案吗? 问题: 给你一个由N个整数组成的数组。现在需要固定X,使以下两个值之间的差值最小: 如果X的值更多,则打印最小的一个。 约束: <代码>1 输入: 第一行包含整数N(表示大小) 第二行包含空格分隔的数字(用于数组) 我在测试这个输入 答案应该是2(如果从零开始计算,那么是1),但我的代码给出了4。

-

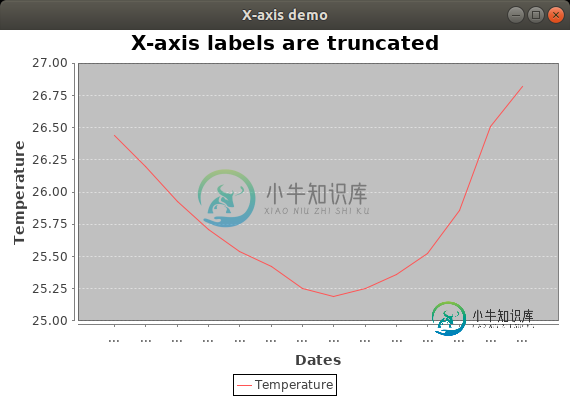

Jfreechart优化X轴标签

Jfreechart优化X轴标签在JFreechart中,我有一个带有日期(和时间)的X轴。 我怎样才能让JFreechart优化它们并充分利用它们? 现在它包含的标签比空间多,所有标签都转换为“…”。 如果不是所有的刻度都有标签,这是完全可以的,但是我想要尽可能多的(如果它们合适并且可以完全显示)。 我怎样才能做到这一点? 这里是完整的最小源来重现截断的标签。(默认情况下,JFreechart不处理优化: 我更喜欢像@tras

-

我应该优化多少?

关于编译器(GCC)所做的优化,标准做法是什么?每个选项(-O、-O1、-O2、-O3、-Os、-s、-fexpensive-optimizations)有什么不同,我如何决定什么是最优的?

-

优化的汇编代码

因此,通常关于通过汇编代码提高性能的问题的答案是“不要打扰,编译器比你聪明”。我明白了。 但是,我注意到优化的线性代数库(例如ACML)可以比标准编译库实现2到5倍的性能改进。例如,在我的8核机器上,与现有的单线程BLAS实现相比,优化的矩阵乘法运行速度快了30倍以上,这意味着,在考虑了由于使用所有内核而提高的8倍之后,仅仅通过优化仍然可以提高4倍。 所以在我看来,优化的汇编代码确实可以带来巨大的

-

优化算术编码器

优化算术编码器我正在优化名为PackJPG的C库的编码步骤 我使用英特尔 VTune 分析了代码,发现当前的瓶颈是 PackJPG 使用的算术编码器中的以下函数: 这个函数好像借鉴了一些来自:http://paginas . Fe . up . pt/~ vinho za/itpa/BOD den-07-algorithm-tr . pdf我已经设法对函数做了一些优化(主要是通过加快位写的速度)但是现在卡住了。

-

函数返回值优化?

我正在编写自己的编程语言,由于各种原因,它编译为C。(其中之一是我对汇编知之甚少)。 我有一个关于编译器(例如GCC或Clang)如何优化从函数返回值的问题。假设我有这样的代码: 我的理解是,您可能希望变量A在从FUNC返回时复制到B(如果A和B是结构,这可能会很昂贵)。编译器会认识到在这种情况下,B可以指向a所在的位置,而不需要拷贝吗? 如果main()看起来像这样:怎么办? 谢谢大家!

-

优化Spring Data JPA查询

我正在为框架生成的查询寻找可能的优化。据我所知,过程如下: > 您可以将域对象声明为POJO并添加几个注释,例如、、等。 您声明您的存储库,例如每个接口 使用(2),您有几个选项来描述您的查询:例如,每个方法名或 如果我写一个类似如下的查询: SQL查询是自动生成的,其中订单的每一列都会被解析,然后依次针对订单位置和依赖对象/表。就像我写道: 因此,如果我需要来自多个联接对象的一些信息,查询可能非

-

Hazelcast射流内部优化

提前致谢

-

点燃数据流优化

我正在使用以下设置: 我的记录大小大约是2000字节。并查看“Grid-Data-Loader-Flusher”线程状态,如下所示: 线程数平均最长持续时间网格-数据-加载器-冲洗器-#100 38 4,737,793.579 30,427,862 180,036,156 数据流的最佳配置是什么? 谢谢

-

优化字符串分析

我需要解析“txf”格式的数据文件。这些文件可能包含 1000 多个条目。由于格式像JSON一样定义得很好,我想做一个像JSON这样的通用解析器,它可以序列化和解串化txf文件。 与JSON相反,标记没有办法识别对象或数组。如果一个带有相同标签的条目出现,我们需要把它看作一个数组。 标记对象的开始。 标记对象的成员 标记对象的结尾 下面是一个示例“txf”文件 我能够使用NSScanner创建通用

-

性能优化 - profile接口

profiler 是 Elasticsearch 5.0 的一个新接口。通过这个功能,可以看到一个搜索聚合请求,是如何拆分成底层的 Lucene 请求,并且显示每部分的耗时情况。 启用 profiler 的方式很简单,直接在请求里加一行即可: curl -XPOST 'http://localhost:9200/_search' -d '{ "profile": true, "qu