《大数据分析》专题

-

Elastic search不提供大量的页面大小数据

问题内容: 要获取的数据大小:大约20,000 问题:在python中使用以下命令搜索Elastic Search索引数据 但没有得到任何结果。 如果我给的尺寸小于或等于10,000,则可以正常使用,但不能与20,000一起使用, 请帮助我找到最佳的解决方案。 PS:在深入研究ES时发现此消息错误: 结果窗口太大,从+大小必须小于或等于:[10000],但为[19999]。有关请求大数据集的更有效

-

加载大于h2o中的内存大小的数据

问题内容: 我正在尝试加载大于h2o中的内存大小的数据。 H2o 博客提到: 这是连接到的代码: 给 我试图将169 MB的csv加载到h2o中。 这引发了错误, 这表示内存不足错误。 问题:如果H2o承诺加载大于其内存容量的数据集(如上面的博客引文所述,交换到磁盘机制),这是加载数据的正确方法吗? 问题答案: 由于性能太差,默认情况下前一会默认禁用“交换到磁盘”。流血边缘(不是最新稳定的)具有启

-

科大讯飞 大数据工程师 一面凉经

科大讯飞 大数据工程师 一面凉经笔试过了一个月给捞起来了 一面 45min 1. 自我介绍 2. 细聊项目,很细(一上来就忘了数据量,尴尬) 3. 特征工程怎么做的 4. iv值的计算方法 5. AUC的计算方法 6. 正反例不平衡对auc有影响吗 7. 知道过拟合吗 8. 逻辑回归怎么解决过拟合问题 9. 写个函数指针 10. pandas库有哪些数据类型 11. 怎么取两个dataframe有差异的部分(忘了具体函数了,讲了

-

PHP的serialize序列化数据以及JSON格式化数据分析

本文向大家介绍PHP的serialize序列化数据以及JSON格式化数据分析,包括了PHP的serialize序列化数据以及JSON格式化数据分析的使用技巧和注意事项,需要的朋友参考一下 PHP的serialize是将变量序列化,返回一个具有变量类型和结构的字符串表达式,而JSON则是一种更轻、更友好的用于接口(AJAX、REST等)数据交换的格式。 其实两者都是以一种字符串的方式来体现一种数据结

-

经纬恒润数据事业部数据分析实习生面试

经纬恒润数据事业部数据分析实习生面试一位面试官,大概40分钟,只有一面 1.确认实习时间,什么时候开始实习,能做多长时间 2.自我介绍 3.面试官介绍了他们的四个方向 4.介绍项目,具体怎么做的包括了数据预处理,模型等 5.不用内置函数怎么算根号二,比如保留小数点后16位,想了半天,说了两种方法,说完第一种方法后面试官问还有没有其他的方法,说了第二种方法后面试官问还有没有其他的方法,没回答上来 6.田字格或九宫格从左上角到右上角不走

-

交通银行江苏省分行_一面(数据分析)

交通银行江苏省分行_一面(数据分析)交行 金融科技储备生_数据分析 面试官两人,一个组同时把4人拉进面试间。每个人轮流发言。问题就两个:自我介绍,以及做过的项目 神仙打架,一堆有实习经历的大佬,还做了一堆牛逼的项目,呆过各种牛逼的实验室 总的来说,我这个没实习的跨专业小辣鸡,没有丝毫的竞争优势 #交通银行##交通银行面试#

-

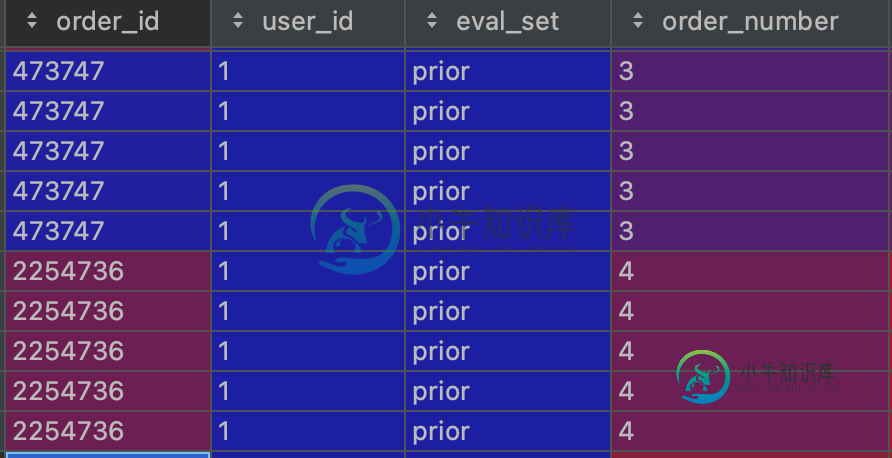

无环路分离数据帧

无环路分离数据帧我有一个包括客户篮子的数据集。我想用一个来分割每个用户篮。因此,我有一个列表,其中我应该使用一个循环来获得一个,以便在pandas矢量化中使用它,如下所示: 我使用函数而不是,但它确实很慢。 根据我的orders列表,它包括百万个元素,我应该使用orders列表的元素来获取用户的篮子。 实际上,我想通过来分割每个用户的篮子,而要这样做,我需要对大小为4000000的orders列表进行迭代,所以这

-

第三部分:衍生数据

在本书的第一部分和第二部分中,我们自底向上地把所有关于分布式数据库的主要考量都过了一遍。从数据在磁盘上的布局,一直到出现故障时分布式系统一致性的局限。但所有的讨论都假定了应用中只用了一种数据库。 现实世界中的数据系统往往更为复杂。大型应用程序经常需要以多种方式访问和处理数据,没有一个数据库可以同时满足所有这些不同的需求。因此应用程序通常组合使用多种组件:数据存储,索引,缓存,分析系统,等等,并实现

-

分配pandas数据框列dtypes

问题内容: 我想在中设置多列的(我有一个文件,我不得不手动将其解析为列表列表,因为该文件不适合) 我懂了 我可以设置它们的唯一方法是循环遍历每个列变量并使用重铸。 有没有更好的办法? 问题答案: 从0.17开始,您必须使用显式转换: (如下所述,在0.17中已不再使用“魔术”了) 您可以将它们应用于要转换的每一列: 并确认dtype已更新。 适用于大熊猫0.12-0.16的旧/建议答案:您可以用来

-

按X列分组数据框

问题内容: 我有一个数据框,我想将一个函数应用于每2列(或3列,它是变量)。 例如,下面的示例,我想将均值函数应用于0-1、2-3、4-5,.... 28-29列 问题答案: 也可以使用,并且可以接受一系列的组标签。如果您的列在您的示例中那样是方便的范围,那么这很简单: (这是因为给出了。) 即使我们不是很幸运,我们仍然可以自己建立适当的小组:

-

Python数据集切分实例

Python数据集切分实例本文向大家介绍Python数据集切分实例,包括了Python数据集切分实例的使用技巧和注意事项,需要的朋友参考一下 在处理数据过程中经常要把数据集切分为训练集和测试集,因此记录一下切分代码。 测试代码如下: 结果如下: 从上图可以看出,原数据集按照5:1被随机分为两部分。但是此种方法存在一个缺点–每次调用次函数切分同一个数据集切分出来的结果都不一样,因此常在np.random.permutatio

-

用elasticsearch分离数据访问

我刚刚开始了解弹性搜索,我想知道它是否适合我的情况: 考虑一个系统,公司(有多名员工)可以注册和管理他们的客户,并向他们的客户发送文件。 现在,我想让公司能够搜索他们的文档,但只搜索他们的文档,而不是其他公司的文档。换言之:如何分离这些公司的数据进行搜索?如何使用elasticsearch实现这一点? 这种分离是由elasticsearch本身处理的吗?一、 e.我的系统中的公司和elastics

-

按列值拆分数据帧

我有列。 如何根据值将其拆分为2? 第一个将包含

-

Kafka:主题与分区数据

通过Kafka文档和各种其他资源,我了解到Kafka中的消息被组织成主题。此外,主题可以分解为多个分区,每个分区可以托管在不同的服务器上。这提供了冗余和可伸缩性。 我不确定这里的“破碎”这个词是什么意思。这是否意味着,如果添加到主题的消息是,例如“1 2 3 4 5 6 7”,那么在将其分解为分区后,我们将有一个分区仅包含整个主题的子部分。就像一个分区有“1 2 3”,而另一个分区有“4 5 6”

-

Spring数据可分页性能

好吧,这很烦人,我真的不知道该怎么解决,所以事情是这样的。 获得了一个返回分页数据的应用程序,如下所示: 检索结果需要花费很长时间。 但是,如果我调用like(使用上面安装的相同可分页对象): 并且存储库上有: 而且,结果马上就会出现。 我假设,对于第一种永远需要的情况,Spring首先检索所有数据(不限制行),然后返回一个带有结果数量信息的页面。 不知道是否与注释有关。 我使用的是2.3.0。顺