《猫眼娱乐》专题

-

熊猫在具有不同名称的列上合并并避免重复[重复]

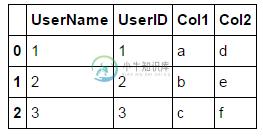

熊猫在具有不同名称的列上合并并避免重复[重复]如何将两个熊猫DataFrames合并到两个具有不同名称的列上,并保留其中一个列? 这提供了一个像这样的数据帧 但是很明显,我正在合并和,所以它们是相同的。我想让它看起来像这样。有什么干净的方法可以做到这一点吗? 我唯一能想到的方法是在合并之前将列重新命名为相同的列,或者在合并之后删除其中一个列。如果熊猫自动掉落其中一只,我会很高兴,或者我可以做类似的事情

-

基于其他数据帧中的列值在熊猫数据帧中创建列

我有两个熊猫数据框 步骤2:对于flag=1的行,AA_new将计算为var1(来自df2)*组“A”和val“AA”的df1的'cal1'值*组“A”和val“AA”的df1的'cal2'值,类似地,AB_new将计算为var1(来自df2)*组“A”和val“AB”的df1的'cal1'值*组“A”和val“AB”的df1的'cal2'值 我的预期输出如下所示: 以下基于其他stackflow

-

通过在熊猫的不同列上应用条件过滤数据帧[重复]

我正在寻找通过以下条件过滤df的方法: 由创建的

-

在熊猫中查找时间序列范围中的最小和最大日期

我有一个数据框,如下所示,带有网站名称和每个网站的日期范围。 我希望找到每个站点的开始和结束日期,并按如下方式布置数据框架: 我知道我可以找到整个范围的最小值和最大值,如下所示: 只是不确定最好的方法是将它分别应用于每个站点。

-

最小/最大分组在熊猫中使用单独的时间戳列[重复]

我有一个熊猫数据框与重叠的时间跨度,看起来像这样: 我的目标是获得每组的最小值和最大值。我试过: 但这只按的最小值和最大值进行分组,而我正在寻找每组的的最小值和的最大值。 例如,在聚合之后,grp6应该具有最小的和最大的 熊猫有没有一个简单的解决办法?

-

猫鼬-5.3。4-防止对带有字符串的查询强制转换为ObjectId

我试图在用户模型上找到一个基于字符串的令牌。我收到错误: 文档的存储方式如下: 我这样查询文档: 这是我当前的模式: 我猜mongoose正试图将这个十六进制字符串转换成一个_id值?是否有某种方法可以防止mongoose将字符串强制转换为?

-

有没有一种方法自动生成ObjectId时,猫鼬模型是新的'ed?

有没有一种方法可以在mongoose中声明一个模型模式,这样当模型是新的时,_id字段就会自动生成? 例如: 但这当然不起作用,因为new ObjectId()只在模式初始化时被调用。因此,两次调用new person()将创建两个具有相同_id值的对象。 那么,有没有一种方法可以让我每次执行“newperson()”时都会生成一个新的ObjectId()? 我之所以尝试这样做,是因为我需要知道新

-

为什么我的熊猫数据框列也是数据框,而不是系列?

结束时更新更新2结束时更新 我从这里读到:从dataframe列获取列表 熊猫数据框列在拉出时是熊猫系列 然而,我的情况并非如此: 第一部分(建立DataFrame读取json刮擦)因为它包含业务信息,我不能显示完整的代码,但基本上它读取一行数据(存储在系列中),并在DataFrame的末尾追加。 下一部分(检查类型):(请忽略函数的功能) 最后调用函数:(“Raw_Impressions”是一个

-

Python熊猫数据帧:为数据帧的两列分配函数返回元组

我想使用返回元组的函数将两列添加到数据帧

-

使用包含时间序列的多索引重新采样熊猫数据框

问题内容: 为创建这个问题的重复而道歉。我有一个数据框,其形状大致如下图所示: 返回: 我将需要重新采样以得出每日滚动平均值,即应用。 我尝试了两种方法: 1 -拆垛和堆积,建议在这里 这返回一个错误 2 -使用,建议在这里 这不会返回错误,但似乎并没有适当地对df重新采样/分组。结果似乎包含每小时数据点,而不是每天: 问题答案: 首先让我们定义一个重采样函数: 然后,我们对job_id进行分组并

-

在matplotlib中从熊猫系列绘制线图时显示分类的x轴值

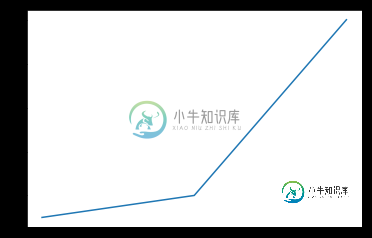

在matplotlib中从熊猫系列绘制线图时显示分类的x轴值问题内容: 如何获得[a,b,c]的x轴值显示? 问题答案: 您可以使用来显示xtick标签: 输出:

-

请说一下,有了淘宝之后,天猫app存在的意义是什么?

本文向大家介绍请说一下,有了淘宝之后,天猫app存在的意义是什么?相关面试题,主要包含被问及请说一下,有了淘宝之后,天猫app存在的意义是什么?时的应答技巧和注意事项,需要的朋友参考一下 1 实现阿里在C2C及B2C的双布局 淘宝是网购零售平台,是C2C的个人网上交易平台,产品来源多为批发或***。天猫是线上综合购物平台,拥有20+w知名品牌,是在线B2C购物平台,是品牌的集合销售商城。 淘宝店是

-

如果熊猫数据框具有超过10行,则将其分成两部分

问题内容: 我有一个巨大的CSV文件,其中包含许多行很多的表。我想简单地将每个数据框拆分成2个(如果包含10行以上)。 如果为true,我希望第一个数据框包含前10个,其余的包含在第二个数据框中。 有便利的功能吗?我环顾四周,但发现没有什么用处… 即? 问题答案: 如果满足条件,这将返回拆分的DataFrames,否则返回原始的和(然后您将需要分别处理)。请注意,这假设拆分仅需每次进行一次,并

-

你如何读取一个gejason网址到geopandas数据帧或熊猫数据帧?

我尝试了这个,但是我有一个混乱的前景 {“类型”:“特征集合”,“特征”:[{“类型”:“特征”,“几何”:{“类型”:“点”,“坐标”:[-73.87057,40.773757]},“属性”:{“tpep_dropoff_datetime”:“2013-04-02T16:00:00.000”,“行程距离”:“11.279999999999999”,“dropoff_经度”:“-73.870570

-

熊猫:是否可以使用任意长的布尔条件过滤数据帧?

如果您确切地知道如何过滤数据帧,那么解决方案很简单: