《储存卡》专题

-

Spring JPA存储库动态查询

目前我一直在使用以下Spring JPA存储库自定义查询, 我需要修改这个查询时,筛选文本将是逗号分隔的值。但按照以下方式,它将是一个动态查询,我如何执行它。 我需要构建动态查询,

-

Maven不使用本地存储库

我的Maven配置有一个小问题。这里所有其他的问题和答案都没有解决我的问题,所以我要开始一个新的问题。 我的问题是,我的Maven没有使用本地存储库。它总是从远程存储库中获取工件。 当下载工件或构建项目时,它被安装在本地存储库中,因此路径是正确的。 问题是:当我构建一个快照项目时,它只安装在本地存储库中(应该是这样的,不要每次都在我的nexus上发布)。当我构建另一个项目时,在pom.xml中有前

-

专家存储库身份验证

我尝试将安装程序部署到本地存储库: --设置。xml-- --波姆。xml--- 当我执行“mvn部署”时,我收到错误: 艺术家日志: 如果我将服务器/存储库id更改为“myserver.com”-部署工作!但这不适合我,因为在myserver上,这不适用于svn。通用域名格式 我试图将标签“配置文件”和“镜像”添加到server.xml和“分发管理”添加到pom.xml-得到相同的错误 服务器/

-

启动配置单元元存储

我们正试图在Linux服务器上启动hive元存储,但我们面临一个问题。如果我们尝试使用以下命令启动配置单元元存储服务: sudo hive服务转移 我们会遇到很多这样的错误: 原因:java.sql。SQLException:拒绝用户“hive”@“sandbox.hortonworks的访问。com“(使用密码:YES)在com.mysql.jdbc.SQLError.createSQLExce

-

JFrog artifactory远程存储库工件

JFrog artifactory看到了远程存储库的树,但没有看到其工件。 选择高级远程存储库设置中的“本地存储工件”设置。

-

Azure Cosmos DB Mongo API存储过程

我需要帮助编写SP在Mongo API与返回相同的json,我保存或新的json与选定的属性

-

日志存储位置ELK堆栈

我正在使用logstash进行集中式日志记录。我在托运人节点上使用logstash转发器,在收集器节点上使用ELK堆栈。我想知道日志存储在elasticsearch中的位置,我没有看到日志所在位置创建的任何数据文件stored.Do有人知道吗?

-

用Python编写Google云存储流

我试图将一个用编写的函数迁移到 实时解压缩并逐行读取 对每一行执行一些光转换 将未压缩的输出(一次一行或块)写入GCS 输出是>2GB,但略小于3GB,所以它适合。 null AFAIC,我将坚持,因为输出可以放入内存--就目前而言--但是多部分上传是以最少的内存支持任何输出大小的方法。 想法还是替代方案?

-

使用CloudFlare CDN Google云存储桶

我在谷歌云存储桶中有文件。 如何将这些文件设置为Cloudflare CDN的原点? (Cloudflare控制面板似乎只想要根域上的网站...?)

-

在Cassandra中存储灵活模式

我正在尝试设计一个新的应用程序,它使用Cassandra而不是传统的SQL数据库。集群和水平扩容功能对我的用例特别有用。 我有这样的情况,我有多个记录,它们可能彼此非常不同。例如,如果我存储不同的运动信息,对于足球,我会存储两支球队、球员、半场和全场比赛后的结果、红牌、黄牌等信息,而如果是网球比赛,则会存储两名对手、盘数等信息。 我不希望每个运动都有一个表(有负载),并且希望能够添加新的运动,而不

-

访问秘密存储的服务

为了更清楚地说明,我明白最终必须有人被信任。例如,ops工程师可以拥有自己的凭据来访问Vault,并获得相同数据库的密码。这将允许用户访问,但不允许该用户模拟服务。是否有任何理由ops工程师也应该知道服务自己的凭据,以便在初始化后访问保险库?

-

SQL插入,更新存储过程

分隔符$$CREATE PROCEDURE

-

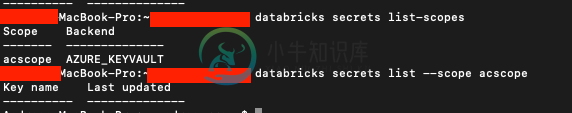

Azure数据块装载blob存储

Azure数据块装载blob存储我正在尝试将一个blob存储从我的存储帐户映射到我的databricks集群。我正在跟踪这个链接,显然我只需要在我的笔记本上执行这段代码: 代码蟒蛇: 我被困在参数中:< code>(scope = " 在Database ricks CLI上尝试过:

-

Azure Data Lake Gen2与存储帐户

我需要处理一些大数据并计划部署数据砖集群 除了HDFS支持,我还应该使用Data Lake Gen2对抗存储帐户的一个重要功能是什么 启用了分层命名空间的存储帐户v2==Data Lake Gen2。如果是,我可以使用文件系统创建文件共享并像存储帐户的文件系统一样将其装载到VM中吗 对于从Databricks访问数据,这两种方法中哪一种更适合大数据工作负载。我可以看到存储帐户也可以作为DBFS挂载

-

使用Cassandra作为事件存储

我想尝试使用Cassandra作为事件源应用程序中的事件存储。我对事件存储的要求非常简单。事件“模式”应该是这样的: id:聚合根实体的id data:序列化的事件数据(例如JSON) 时间戳:事件发生时 sequence_number:事件的独特版本 我对卡桑德拉完全陌生,所以请原谅我对即将写的东西的无知。我只有两个查询,我想对此数据运行。 为我提供给定聚合根 ID 的所有事件 如果序列号为 我