《美的群面》专题

-

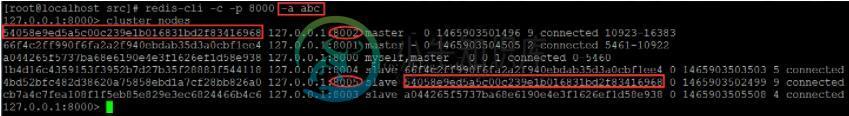

基于redis集群设置密码的实例

基于redis集群设置密码的实例本文向大家介绍基于redis集群设置密码的实例,包括了基于redis集群设置密码的实例的使用技巧和注意事项,需要的朋友参考一下 注意事项: 1.如果是使用redis-trib.rb工具构建集群,集群构建完成前不要配置密码,集群构建完毕再通过config set + config rewrite命令逐个机器设置密码 2.如果对集群设置密码,那么requirepass和masterauth都需要设置,

-

节点中的Redis队列。js集群环境

使用节点。js集群支持,我希望主进程生成添加到Redis队列的数据项。然后,我想运行多个读取Redis队列的工作进程。当然,只有一个工作进程应该使用从队列中检索到的数据项。 为了让我开始学习,您能建议从节点包支持或原始Redis命令的角度来完成这项工作吗?让我强调一下,消费者是节点中独立的进程。js集群环境,我们可以在其中调整竞争从单个Redis队列读取的工作进程的数量,以调整整体系统性能。

-

Vert中的群集和共享数据。x个

我在Vert发展。x(基于Netty和Hazelcast),我正在尝试在两个服务器实例之间共享数据(在同一局域网上的不同机器中的每个实例)。 我的问题是我不知道如何配置vert. x服务器以允许它们共享它们的并发内存映射(理论上说这是可能的)。 我已经阅读了Vert. x和Hazelcast的许多文档,但还没有结果。(我不知道如何强制vert. x加载hazelcast xml配置文件)。 提前感

-

群体中的Kafka单一消费者失败

我正处于探索Kafka0.8.1.1版本的初始阶段。 使用API进行触发器再平衡 将kafka配置为等待消费者活动一段时间,并假设它被不优雅地关闭,自动重新平衡。 这里的问题是,分配给死亡使用者的分区中的所有消息都保留在队列中,并且在重新平衡发生之前不会被处理。

-

Apache在未加入群集的Kubernetes上点火

我正在尝试用Kubernetes建立一个简单的两个节点点火集群。当直接在VM上运行时,相同的配置工作良好。 更新: 点火配置:

-

使用不同机器配置的hadoop集群

我有两台linux机器,都有不同的配置 机器1:16 GB RAM、4个虚拟内核和40 GB HDD(主从机) 我想运行我的spark应用程序,并尽可能多地利用虚拟内核和内存,但我无法确定是什么设置。 我的spark代码类似于: 到目前为止,我尝试了以下几种: 任何帮助都将不胜感激。

-

群集顶点中的SockJS连接。x环境

vertx应用程序在两个EC2实例上的Docker容器中运行,并且是集群的。 集群是通过hazelcast aws插件实现的,应用程序的启动如下: 没有以编程方式设置任何与群集相关的内容。 客户端在第一个请求上打开一个套接字并将其用于未来的类似请求。 每个请求将: 通过向事件总线发布消息来启动与服务器的异步请求 在事件总线上注册一个使用者,该事件总线将处理上述结果,并将引用传递给它应该将结果发送到

-

Vertx |群集中垂直线的全局状态

新手警报。 我正在尝试在Vertx中编写一个简单的模块,它每10秒轮询一次数据库(PostGres)并将结果推送给客户端。我正在考虑将阻塞代码(通过JDBC查询数据库)限制在工作垂直中,上面的其余层是完全非阻塞和异步的。 此模块将打包为一个jar,并分发到不同的应用程序(通常是webapps),这些应用程序可以通过javascript桥订阅事件总线。 我这里的问题是在集群环境中,我有5个运行ver

-

Jenkins的HELM安装无法连接到群集

null NewJenkins.Values具有以下特性。 报告的错误是。 我在谷歌上搜索了一段时间,很多网站都提到了服务帐户设置,但没有任何工作。 还有别的步骤吗?

-

更新使用timeuuid作为群集列的行

我想做的是,根据

-

清除Kafka消费群体中的Kafka成员

我有一个问题,来自一个消费群体的许多Kafka客户端没有正确关闭,因此Kafka集群认为它们仍然是连接的。因此,我无法使用新版本的客户端连接到消费者组。会卡在再平衡这一步。 根据文档,应在< code>session.timeout.ms或maximum < code > group . max . session . time out . ms 之后删除它们。起初我试图将< code>sessi

-

跨集群的Apache Kafka消费者组示例

我是Kafka的新手,我已经在3台服务器上实现了KAFKA集群,并且在3台服务器中运行消费者,每台服务器有3个消费者,即…3x3=9个消费者。 我的问题是:-1.当我为同一主题在整个集群中提供相同的组ID时,我没有收到任何重复消息,但当我为相同主题在集群中提供3个不同的消费者组ID时我收到的重复消息正好是3? 请帮忙如何利用消费群体?

-

Kafka——特定抵消的消费群体创造?

在Kafka中创建主题后,您可以创建任意数量的消费者组,只需尝试使用这些组来阅读主题。 我想创建一个额外的消费者组来监控真实消费者组的消息内容——一个用来偷看他们消息的组。因此,GUI会让您单击任何消费者组的“偷看”,“偷看”组的偏移量将更新为被监控组的偏移量,然后它会向您显示该偏移量中的消息。 不过我很困惑,因为你不能在第一次就明确地创建一个消费者群体。您似乎必须阅读一条消息才能获得在动物园管理

-

检查Kubernetes群集中失败的pods日志

我有一个Kubernetes集群,其中不同的pod在不同的名称空间中运行。我如何知道是否有pod出现故障? 是否有任何单个命令来检查失败的pod列表或重述的pod列表? 重新启动的原因(日志)?

-

用于集群间通信的Kafka MirorMaker2端口

我已经为两个Kafka集群(名为DC、DR)设置了带有主动-主动策略的Apache MirrorMaker 3.0.0。因此,MirrorMaker2将有关DC的主题复制为DC。 在每个集群中,我设置了3个kafka代理节点。 假设使用了以下 IP 配置 连接制造商属性 我只想了解是否只有9092端口足以进行集群间通信(记录、偏移和其他元数据转换),或者我们是否还需要在一些端口上开放连接?