《上海航空工业集团》专题

-

等待异步批处理作业结果的Spring集成配置

我使用Spring Batch admin项目,在该项目中,我得到了一个异步处理特定文件夹中文件的作业。目前,我通过batch admin ui通过传递相关作业参数来运行它。 现在,我正试图通过使用文件入站通道适配器自动化此过程。我已经配置了服务激活器,它将在收到文件时调用批处理作业。我现在有一个新的要求,即在第一个文件上载作业完成后调用另一个批处理作业。为此,我创建了另一个服务激活器,它使用第一

-

如何从本地提交spark作业并连接到Cassandra集群

可以任何一个请让我知道如何提交火花作业从本地和连接到卡桑德拉集群。 目前,我在通过putty登录到Cassandra节点并提交下面的dse-spark-submit job命令后提交了Spark作业。

-

游戏行业面试有一份作品集真的很重要!

游戏行业面试有一份作品集真的很重要!一份好的高质量的作品集是续简历后给面试官留下好印象的另一法宝,一般面试官在看完简历后,如果对你这个人有一个初步的好印象的话,会继续将你的作品集探索下去。 除了我们熟悉的美术岗位的同学需要准备的是美术作品集外,不同岗位对作品集的要求和形式也不同: 针对游戏策划同学: 一定要提供个人游戏经历相关作品!! 包括游戏名称、玩过的时长、获得的游戏成就以及付费情况,个人对游戏的分析及理解等等... 【面试成功

-

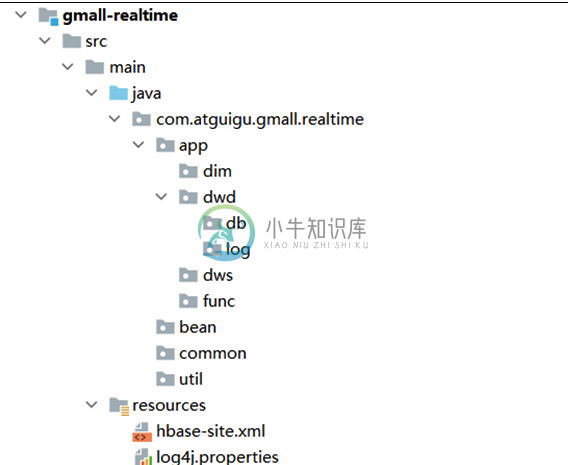

用户行为数据和业务数据采集以及ODS层

用户行为数据和业务数据采集以及ODS层主要内容:1.数据仓库环境准备,2.数据仓库运行环境,3.数仓开发之ODS层1.数据仓库环境准备 1.1 导入依赖 1.2 创建相关包 log.properties 2.数据仓库运行环境 需要搭建Flink, HBase, Mysql, Redis, ClickHouse 环境 2.1 Hbase环境 pom hbase-site.xml 2.2 模拟数据 通常企业在开始搭建数仓时,业务系统中会存在历史数据,一般是业务数据库存在历史数据,而用户行为日志无历史数据。假定数仓

-

为什么在空字符串上“拆分”会返回非空数组?

问题内容: 在空字符串上分割将返回大小为1的数组: 考虑这返回空数组: 请解释 :) 问题答案: 出于同样的原因 和 将返回一个大小为2的数组。将第一个匹配之前的所有内容作为第一个元素返回。

-

MSbuild错误:找不到v140的生成工具(平台工具集='v140')

我有一个由大量项目(C和C#)组成的解决方案。我将解决方案升级到VS2015,因此大多数解决方案的工具集版本现在设置为V140,但少数项目需要保留在V110(第三方库等)中。当我在Visual Studio 2015中构建解决方案时,它构建得很好,但当TeamFoundationServer尝试构建它时,它失败,出现以下错误: C:\ProgramFiles(x86)\MSBuild\Micros

-

如何获得排序集上的DIFF

问题内容: 如何从排序集中获得最加权的元素,但不包括在另一个集合(或列表或哈希)中找到的那些元素。 我唯一的选择是一对一地从排序集中获取元素并与“禁用”项目列表进行比较吗?由于与服务器的事务如此之多,这不会很慢吗? 这里的方法是什么? 问题答案: 注意:我认为您的意思是 如您所知,它不能对已排序的集合进行操作-这是因为定义已排序的集合之间的差异并不容易。 您可以做的是首先使用ZUNIONSTORE

-

修改的基础集合上的Spliterator

我知道这在生产中绝不应该发生,但我正在试图理解一些关于spliterator的错综复杂的细节,并撞见了下面这个“谜题”(至少对我来说是个谜题): (代码段%1) 这段代码按预期打印(cough我已经预期了一个,但我理解行为cough),即,它在列表上创建了一个拆分器,当列表有6个元素时,该拆分器将被拆分。 我不明白的是以下几点: (片段2) 我预计这段代码会失败,但它确实失败了,因为在的行上有一个

-

Stormpath Spring Boot集成-上下文重复

我试图将Stormpath登录工作流添加到我的Spring Boot应用程序中,该应用程序在/api上下文中运行,该上下文在我的application.properties中定义为server.context-path=/api。 当我访问一个受限路径时,我会得到Stormpath登录页面,其中包含一个“Next”请求参数http://localhost:8080/api/login?next=%

-

如何在群集上保存文件

问题内容: 我已使用连接到集群,并使用将程序发送到集群 我想将结果保存在文本文件中,并尝试使用以下几行: 但是,它们都不起作用。程序完成,我在中找不到文本文件。你知道我该怎么做吗? 另外,有没有一种方法可以直接写入本地计算机? 编辑:我发现该目录不存在,所以现在我将结果另存为: 但这会创建一个名为的目录,并且我里面有很多文件,里面有部分结果。但是我想要一个包含最终结果的文件。有什么想法我该怎么做?

-

Rmtcars数据集上的线性回归

本文向大家介绍Rmtcars数据集上的线性回归,包括了Rmtcars数据集上的线性回归的使用技巧和注意事项,需要的朋友参考一下 示例 内置的mtcars数据框包含有关32辆汽车的信息,包括它们的重量,燃油效率(以每加仑英里为单位),速度等。(要了解有关数据集的更多信息,请使用help(mtcars))。 如果我们对燃油效率(mpg)和重量(wt)之间的关系感兴趣,我们可以开始用以下公式绘制这些变量

-

Spark在Yarn集群exitCode=13上运行:

我是一名spark/纱线新手,在提交纱线集群上的spark作业时遇到exitCode=13。当spark作业在本地模式下运行时,一切正常。 我使用的命令是: Spark错误日志:

-

spring集成-SFTP确保上传成功

如何确保文件是否成功上传到SFTP服务器。我想确保SFTP上传成功,然后我只想应用其他逻辑。这是我要上传的代码。 我看到日志看起来不错。已验证文件正在上传到SFTP服务器。但不知何故,我无法确保文件正在上传到服务器上。请告知如何添加代码以确保文件上传成功。

-

用kubernetes上的sentinel连接redis集群

我已经使用以下指南成功地设置了一个密码保护的redis群集: 我使用ruby和下面的连接字符串…我做错了吗? 我得到的错误是:

-

在主节点上安装kubernetes群集

我对container worrld是新手,并试图在两个linux VM中本地设置一个kubernetes集群。在集群初始化期间,它卡在 KubeADM-1.6.0-0.x86_64.rpm KubectL-1.6.0-0.x86_64.rpm Kubelet-1.6.0-0.x86_64.rpm