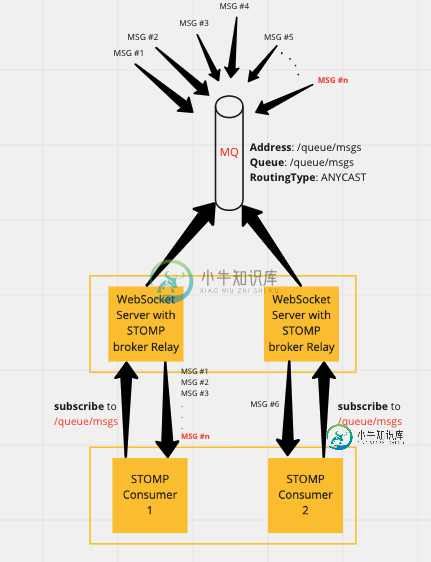

ActiveMQ Artemis队列不会将消息均匀地分配给STOMP使用者。如何才能实现均匀的负载平衡?

如图所示,在队列-/queue/msgs上发布的n条消息中,消费者(stomp-consumer1和stomp-consumer2)之间的分布是不均匀的。我可以观察到,stomp-consumer2只接收到n条消息中的一条。

两个使用者都传递完全相同的STOMP报头。以下是-

STOMP连接头

-

null

-

null

broker.xml

<?xml version="1.0"?>

<configuration

xmlns="urn:activemq"

xmlns:xi="http://www.w3.org/2001/XInclude"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="urn:activemq /schema/artemis-configuration.xsd">

<core

xmlns="urn:activemq:core" xsi:schemaLocation="urn:activemq:core ">

<name>activemq-558f6696fc-2kx8q</name>

<persistence-enabled>true</persistence-enabled>

<journal-type>ASYNCIO</journal-type>

<paging-directory>data/paging</paging-directory>

<bindings-directory>data/bindings</bindings-directory>

<journal-directory>data/journal</journal-directory>

<large-messages-directory>data/large-messages</large-messages-directory>

<journal-datasync>true</journal-datasync>

<journal-min-files>2</journal-min-files>

<journal-pool-files>10</journal-pool-files>

<journal-device-block-size>4096</journal-device-block-size>

<journal-file-size>10M</journal-file-size>

<journal-buffer-timeout>24000</journal-buffer-timeout>

<journal-max-io>4096</journal-max-io>

<disk-scan-period>5000</disk-scan-period>

<max-disk-usage>90</max-disk-usage>

<critical-analyzer>true</critical-analyzer>

<critical-analyzer-timeout>120000</critical-analyzer-timeout>

<critical-analyzer-check-period>60000</critical-analyzer-check-period>

<critical-analyzer-policy>HALT</critical-analyzer-policy>

<page-sync-timeout>368000</page-sync-timeout>

<acceptors>

<acceptor name="artemis">tcp://0.0.0.0:61616?tcpSendBufferSize=1048576;tcpReceiveBufferSize=1048576;amqpMinLargeMessageSize=102400;protocols=CORE,AMQP,STOMP,HORNETQ,MQTT,OPENWIRE;useEpoll=true;amqpCredits=1000;amqpLowCredits=300;amqpDuplicateDetection=true</acceptor>

<acceptor name="amqp">tcp://0.0.0.0:5672?tcpSendBufferSize=1048576;tcpReceiveBufferSize=1048576;protocols=AMQP;useEpoll=true;amqpCredits=1000;amqpLowCredits=300;amqpMinLargeMessageSize=102400;amqpDuplicateDetection=true</acceptor>

<acceptor name="stomp">tcp://0.0.0.0:61613?tcpSendBufferSize=1048576;tcpReceiveBufferSize=1048576;protocols=STOMP;useEpoll=true</acceptor>

<acceptor name="hornetq">tcp://0.0.0.0:5445?anycastPrefix=jms.queue.;multicastPrefix=jms.topic.;protocols=HORNETQ,STOMP;useEpoll=true</acceptor>

<acceptor name="mqtt">tcp://0.0.0.0:1883?tcpSendBufferSize=1048576;tcpReceiveBufferSize=1048576;protocols=MQTT;useEpoll=true</acceptor>

</acceptors>

<security-settings>

<security-setting match="#">

<permission type="createNonDurableQueue" roles="amq"/>

<permission type="deleteNonDurableQueue" roles="amq"/>

<permission type="createDurableQueue" roles="amq"/>

<permission type="deleteDurableQueue" roles="amq"/>

<permission type="createAddress" roles="amq"/>

<permission type="deleteAddress" roles="amq"/>

<permission type="consume" roles="amq"/>

<permission type="browse" roles="amq"/>

<permission type="send" roles="amq"/>

<!-- we need this otherwise ./artemis data imp wouldn't work -->

<permission type="manage" roles="amq"/>

</security-setting>

</security-settings>

<message-expiry-scan-period>30000</message-expiry-scan-period>

<connection-ttl-override>60000</connection-ttl-override>

<address-settings>

<address-setting match="activemq.management#">

<dead-letter-address>DLQ</dead-letter-address>

<expiry-address>ExpiryQueue</expiry-address>

<redelivery-delay>0</redelivery-delay>

<!-- with -1 only the global-max-size is in use for limiting -->

<max-size-bytes>-1</max-size-bytes>

<message-counter-history-day-limit>10</message-counter-history-day-limit>

<address-full-policy>PAGE</address-full-policy>

<auto-create-queues>true</auto-create-queues>

<auto-create-addresses>true</auto-create-addresses>

<auto-create-jms-queues>true</auto-create-jms-queues>

<auto-create-jms-topics>true</auto-create-jms-topics>

</address-setting>

<address-setting match="/queue/#">

<default-address-routing-type>ANYCAST</default-address-routing-type>

<default-queue-routing-type>ANYCAST</default-queue-routing-type>

</address-setting>

<address-setting match="/topic/#">

<default-address-routing-type>MULTICAST</default-address-routing-type>

<default-queue-routing-type>MULTICAST</default-queue-routing-type>

</address-setting>

<address-setting match="#">

<dead-letter-address>DLQ</dead-letter-address>

<expiry-address>ExpiryQueue</expiry-address>

<auto-delete-queues>false</auto-delete-queues>

<auto-delete-jms-queues>false</auto-delete-jms-queues>

<auto-delete-jms-topics>false</auto-delete-jms-topics>

<auto-delete-addresses>false</auto-delete-addresses>

<max-size-bytes>-1</max-size-bytes>

<message-counter-history-day-limit>10</message-counter-history-day-limit>

<address-full-policy>PAGE</address-full-policy>

<auto-create-queues>true</auto-create-queues>

<auto-create-addresses>true</auto-create-addresses>

<auto-create-jms-queues>true</auto-create-jms-queues>

<auto-create-jms-topics>true</auto-create-jms-topics>

<redelivery-delay-multiplier>1</redelivery-delay-multiplier>

<redelivery-collision-avoidance-factor>0.15</redelivery-collision-avoidance-factor>

<max-redelivery-delay>50000</max-redelivery-delay>

<default-consumer-window-size>0</default-consumer-window-size>

</address-setting>

</address-settings>

<addresses>

<address name="DLQ">

<anycast>

<queue name="DLQ"/>

</anycast>

</address>

<address name="ExpiryQueue">

<anycast>

<queue name="ExpiryQueue"/>

</anycast>

</address>

</addresses>

<wildcard-addresses>

<routing-enabled>true</routing-enabled>

<delimiter>/</delimiter>

<any-words>#</any-words>

<single-word>*</single-word>

</wildcard-addresses>

</core>

</configuration>

使用的受体是端口为61616的artemis受体

共有1个答案

使用acceptorURL参数stompconsumercredits。它的默认值是10240字节,这意味着代理将向每个客户端分派10KB的消息。如果第一个客户机处理这些消息的速度足够快,那么其他消费者可能会挨饿。假设您的STOMP使用者正在使用STOMPacceptor,那么您可以尝试如下所示:

<acceptor name="stomp">tcp://0.0.0.0:61613?tcpSendBufferSize=1048576;tcpReceiveBufferSize=1048576;protocols=STOMP;useEpoll=true;stompConsumerCredits=1</acceptor>

请记住,基于stompconsumercredits将消息分批分派给使用者是一种性能优化,它可以防止客户端和代理之间为获取消息而进行的大量网络往返。我建议您测试stompconsumercredits的不同值,以找到您用例的最佳性能,因为对于2个使用者使用一个小值,实际上可能会降低总体消息吞吐量,而对于1个使用者使用一个大值。

另外,值得注意的是,在ActiveMQ Artemis 2.16.0(尚未发布)中,您可以在STOMPsubscribe框架中使用自定义头(即consumer-window-size)来优化每个客户机,而不是将其设置在所有客户机的acceptor级别。

-

0.1-0.2:********** 0.2-0.3:******** 0.3-0.4:********* 0.5-0.6:********* 0.6-0.7:********* 0.7-0.8:********* 0.4-0.5:********* 0.5-0.6:********* 0.6-0.7:********* 0.1-0.2:********* 0.2-0.3:********* 0.

-

问题内容: 我的网页上有一个宽度固定的容器,其中包含用于登录的表单元素。在这些元素下方有一个提交按钮,忘记密码的链接等。 碰巧最后一个线元素需要的宽度比框提供的宽度少。如何均匀地传播它们?我不要 默认 | ABC | 将线居中 | ABC | 也不是桌子的布局 | A | B | C | 相反,我正在寻找实现的CSS方法: 那是: 在所有元素之间放置相等的空间 将整个内容居中,避免第一侧或最后侧

-

我们在AWS上运行16个节点kafka集群,每个节点是m4. xLargeEC2实例,具有2TB EBS(ST1)磁盘。Kafka版本0.10.1.0,目前我们有大约100个主题。一些繁忙的话题每天会有大约20亿个事件,一些低量的话题每天只有数千个。 我们的大多数主题在生成消息时使用UUID作为分区键,因此分区分布相当均匀。 我们有相当多的消费者使用消费群体从这个集群消费。每个使用者都有一个唯一的

-

问题内容: 我有一个任意长度的列表,我需要将其分成相等大小的块并对其进行操作。有一些明显的方法可以做到这一点,例如保留一个计数器和两个列表,当第二个列表填满时,将其添加到第一个列表中,并为第二轮数据清空第二个列表,但这可能会非常昂贵。 我想知道是否有人对任何长度的列表都有很好的解决方案,例如使用生成器。 我一直在寻找有用的东西,itertools但找不到任何明显有用的东西。可能已经错过了。 问题答

-

问题内容: 我知道如果我使用Java的Random生成器,并使用nextInt生成数字,则数字将均匀分布。但是,如果我使用2个Random实例,并使用两个Random类生成数字,会发生什么。数字是否会均匀分布? 问题答案: 每个实例生成的数字将均匀分布,因此,如果将两个实例生成的随机数序列组合在一起,则它们也应均匀分布。 请注意,即使结果分布是均匀的,您也可能要注意种子,以避免两个生成器的输出之间

-

我想有一个主题与10个分区。我使用的是Kafka的默认配置。我用帮助器脚本创建了一个有10个解析的主题,现在我将为它生成消息。 问题是,消费者似乎只有5个分区可以从中获取数据。 让我们更详细地描述一下。 我知道每个分区需要一个使用者线程。我希望能够提交每个分区的偏移量,这是可能的,只有当我有一个线程每个消费连接器每个分区(我是使用高级消费)。 当我这样做10次时,我有10个消费者,每个分区每个线程