LR的推导,损失函数

参考回答:

逻辑回归本质上是线性回归,只是在特征到结果的映射中加入了一层逻辑函数g(z),即先把特征线性求和,然后使用函数g(z)作为假设函数来预测。g(z)可以将连续值映射到0 和1。g(z)为sigmoid function.

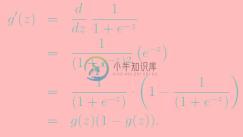

sigmoid function 的导数如下:

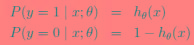

逻辑回归用来分类0/1 问题,也就是预测结果属于0 或者1 的二值分类问题。这里假设了二值满足伯努利分布,也就是

其也可以写成如下的形式:

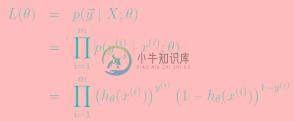

对于训练数据集,特征数据x={x1, x2, … , xm}和对应的分类标签y={y1, y2, … , ym},假设m个样本是相互独立的,那么,极大似然函数为:

log似然为:

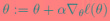

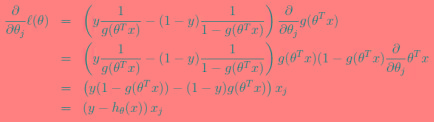

如何使其最大呢?与线性回归类似,我们使用梯度上升的方法(求最小使用梯度下降),那么

。

如果只用一个训练样例(x,y),采用随机梯度上升规则,那么随机梯度上升更新规则为:

损失函数:

-

本文向大家介绍LR的损失函数相关面试题,主要包含被问及LR的损失函数时的应答技巧和注意事项,需要的朋友参考一下 参考回答: M为样本个数,为模型对样本i的预测结果,为样本i的真实标签。

-

本文向大家介绍LR推导相关面试题,主要包含被问及LR推导时的应答技巧和注意事项,需要的朋友参考一下 参考回答: 逻辑回归本质上是线性回归,只是在特征到结果的映射中加入了一层逻辑函数g(z),即先把特征线性求和,然后使用函数g(z)作为假设函数来预测。g(z)可以将连续值映射到0 和1。g(z)为sigmoid function. 则 逻辑回归用来分类0/1 问题,也就是预测结果属于0 或者1 的二

-

本文向大家介绍gbdt的损失函数?相关面试题,主要包含被问及gbdt的损失函数?时的应答技巧和注意事项,需要的朋友参考一下 gbdt可以用多种损失函数来进行拟合回归树

-

本文向大家介绍Lasso的损失函数相关面试题,主要包含被问及Lasso的损失函数时的应答技巧和注意事项,需要的朋友参考一下 参考回答:

-

本文向大家介绍SVM的损失函数相关面试题,主要包含被问及SVM的损失函数时的应答技巧和注意事项,需要的朋友参考一下 参考回答:

-

损失函数 1. 二分类 在二分类问题中,目标$y$只能取两个值。在本节笔记中,我们将展示如何建模这个问题,通过令$y \in{-1,+1}$,这里如果这个例子是正类的一个元素,我们说$y$是$1$,如果这个例子是负类的一个元素,我们说$y = - 1$。和往常一样,我们假设我们的输入特征$x \in \mathbb{R}^{n}$。 和我们处理监督学习问题的标准方法一样,我们首先为我们的假设类选择