spider_cnblogs

spider_cnblogs 是专门爬取博客园的文章并自动将文章转成 .md 存储至本地的爬虫。

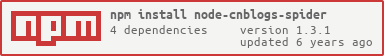

安装

npm install node-cnblogs-spider --save

使用

var ncs = require('node-cnblogs-spider')

ncs([

http://xxxx,

http://xxxx

])

示例

依赖

to-markdown 将html转md

cheerio 类似于Sizzle的nodejs的实现

bluebird 是对es6种Promise方法的封装与ose展库

文档

- [译] NodeJS 错误处理最佳实践

- Nodejs异步异常处理domain

- 使用Promise尽量脱离回调地狱,使得代码可读性更高

- html转md格式的包还是有缺陷的,不然完美展现出

.md - 生成本地文件使用的是stream实现,效率更高。但是要注意文件的命名规范。

License

MIT

-

参考: https://www.cnblogs.com/it-Ren/p/13619189.html 使用dart-sass替代node-sass 由于npm6.9以上支持新功能package alias对包重命名 可以既满足包名为node-sass,但实际是使用的dart-sass的效果 npm install node-sass@npm:dart-sass 参考: https://zhuan

-

需要安装node.js npm install font-spider -g 安装字蛛 可能会报很多错 检查是否安装完成 font-spider --version 打包: doc命令进入目录所在位置 然后font-spider *.html或者font-spider 文件所在目录下的*.html 注:引入文件因为ttf 类似otf会找不到文件 转载于:https://www.cnb

-

步骤一:安装必要模块 (1)cheerio模块 ,一个类似jQuery的选择器模块,分析HTML利器。 (2)request模块,让http请求变的更加简单 (3)mysql模块,node连接mysql的模块 npm i cheerio request mysql -D 步骤二:分析爬取网址的内容 目标URL: http://zzk.cnblogs.com/s/blogpost?Keywords=

-

原文链接:https://www.runoob.com/xpath/xpath-syntax.html XPath 术语 XPath 节点 七种类型:在 XPath 中,有七种类型的节点:元素、属性、文本、命名空间、处理指令、注释以及文档(根)节点。 XML 文档是被作为节点树来对待的。树的根被称为文档节点或者根节点。 节点关系:父、子、同胞、先辈、后代 XPath 语法 XPath 使用路径表达

-

注font-spider为插件在node上使用只支持utf-8,若无法转换请记得查看下载的字体是否有问题!!编码问题再转一次码 @font-face { font-family: "MJWB"; src: url("字体文件.eot"); src: url("字体文件.eot?#font-spider") format("embedded-opentype"), u

-

anyproxy node-v6.11.0-win-x64 微信客户端 python3.5 https://github.com/Apokar/wechat-spider 转载于:https://www.cnblogs.com/auschwitzer/p/9373362.html

-

spider使用java语言开发,使用Spring作为IoC容器,采用TCP/IP协议,在此基础上,结合SaaS金融交易系统的特性进行针对性和重点设计,以更加灵活和高效的满足金融交易系统多租户、高可用、分布式部署的要求。spider默认采用JSON作为序列化机制,后续版本可能会考虑支持protobuf(java/c++/c#均有类库支持)。 为了最大化性能以及稳定性,spider基于Oracle

-

解决方法之一: 1、确保所有的Pojo都包含了默认的构造器; 转载于:https://www.cnblogs.com/zhjh256/p/5984148.html

-

1.spider 安装 1.1.MariaDB 安装 1.1.1 下载MariaDB wget https://mirrors.tuna.tsinghua.edu.cn/mariadb//mariadb-10.3.16/bintar-linux-x86_64/mariadb-10.3.16-linux-x86_64.tar.gz https://mariadb.com/downloa

-

############################ requests的使用 import requests # 发送请求, 使用的函数按照HTTP访问的方法,主要:get、post、put、delete、head、options,patch # 最终都是调用了request函数,这个函数的原型是: def request(method, url, **kwargs): # kwargs可以填

-

详见代码: #include <cstdio> #include <cstring> #include <cstdlib> #include <cmath> #include <algorithm> #include <iostream> #define INF 0x3f3f3f3f #define MAXN 1000005 using namespace std; /* 题意:给定N个柱子,现

-

本文向大家介绍node实现爬虫的几种简易方式,包括了node实现爬虫的几种简易方式的使用技巧和注意事项,需要的朋友参考一下 说到爬虫大家可能会觉得很NB的东西,可以爬小电影,羞羞图,没错就是这样的。在node爬虫方面,我也是个新人,这篇文章主要是给大家分享几种实现node 爬虫的方式。第一种方式,采用node,js中的 superagent+request + cheerio。cheerio是必须

-

本文向大家介绍基于C#实现网页爬虫,包括了基于C#实现网页爬虫的使用技巧和注意事项,需要的朋友参考一下 本文实例为大家分享了基于C#实现网页爬虫的详细代码,供大家参考,具体内容如下 HTTP请求工具类: 功能: 1、获取网页html 2、下载网络图片 多线程爬取网页代码: 截图: 以上就是本文的全部内容,希望对大家的学习有所帮助。

-

本文向大家介绍node+express制作爬虫教程,包括了node+express制作爬虫教程的使用技巧和注意事项,需要的朋友参考一下 最近开始重新学习node.js,之前学的都忘了。所以准备重新学一下,那么,先从一个简单的爬虫开始吧。 什么是爬虫 百度百科的解释: 爬虫即网络爬虫,是一种自动获取网页内容的程序。是搜索引擎的重要组成部分,因此搜索引擎优化很大程度上就是针对爬虫而做出的优化。 通俗一

-

3 Node 基础 3.1 安装 打开 Node官网 ,引入眼帘的就是它的下载地址了,windows下提供的是安装程序(下载完之后直接双击安装),linux下提供的是源码包(需要编译安装),详细安装流程这里省略掉,我想这个不会难倒各位好汉。 3.2 旋风开始 在讲 Node 语法之前先直接引入一段 Node 的小例子,我们就从这个例子着手。首先我们在随意目录下创建两个文件 a.js b.js。 e

-

突然,在我的一个jenkins环境构建开始失败,而在本地机器中,它似乎工作正常,因为我安装了python, 从日志中,我能够检测到问题是内部依赖,即node-gyp v3.5.0从node-sass v3.8.0当我通过访问这个关于node-gyp的研究,并发现需要安装Python的先决条件。 所以我的问题是,我可以安装哪个版本的node sass来绕过这个问题,还是有更好的解决方案,因为我的构建

-

本文向大家介绍简单实现Node的Events模块?相关面试题,主要包含被问及简单实现Node的Events模块?时的应答技巧和注意事项,需要的朋友参考一下 参考回答: 简介:观察者模式或者说订阅模式,它定义了对象间的一种一对多的关系,让多个观察者对象同时监听某一个主题对象,当一个对象发生改变时,所有依赖于它的对象都将得到通知。 node中的Events模块就是通过观察者模式来实现的: 这样,eve