基于C#实现网页爬虫

本文实例为大家分享了基于C#实现网页爬虫的详细代码,供大家参考,具体内容如下

HTTP请求工具类:

功能:

1、获取网页html

2、下载网络图片

using System;

using System.Collections.Generic;

using System.IO;

using System.Linq;

using System.Net;

using System.Text;

using System.Threading.Tasks;

using System.Windows.Forms;

namespace Utils

{

/// <summary>

/// HTTP请求工具类

/// </summary>

public class HttpRequestUtil

{

/// <summary>

/// 获取页面html

/// </summary>

public static string GetPageHtml(string url)

{

// 设置参数

HttpWebRequest request = WebRequest.Create(url) as HttpWebRequest;

request.UserAgent = "Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.0; Trident/4.0)";

//发送请求并获取相应回应数据

HttpWebResponse response = request.GetResponse() as HttpWebResponse;

//直到request.GetResponse()程序才开始向目标网页发送Post请求

Stream responseStream = response.GetResponseStream();

StreamReader sr = new StreamReader(responseStream, Encoding.UTF8);

//返回结果网页(html)代码

string content = sr.ReadToEnd();

return content;

}

/// <summary>

/// Http下载文件

/// </summary>

public static void HttpDownloadFile(string url)

{

int pos = url.LastIndexOf("/") + 1;

string fileName = url.Substring(pos);

string path = Application.StartupPath + "\\download";

if (!Directory.Exists(path))

{

Directory.CreateDirectory(path);

}

string filePathName = path + "\\" + fileName;

if (File.Exists(filePathName)) return;

// 设置参数

HttpWebRequest request = WebRequest.Create(url) as HttpWebRequest;

request.UserAgent = "Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.0; Trident/4.0)";

request.Proxy = null;

//发送请求并获取相应回应数据

HttpWebResponse response = request.GetResponse() as HttpWebResponse;

//直到request.GetResponse()程序才开始向目标网页发送Post请求

Stream responseStream = response.GetResponseStream();

//创建本地文件写入流

Stream stream = new FileStream(filePathName, FileMode.Create);

byte[] bArr = new byte[1024];

int size = responseStream.Read(bArr, 0, (int)bArr.Length);

while (size > 0)

{

stream.Write(bArr, 0, size);

size = responseStream.Read(bArr, 0, (int)bArr.Length);

}

stream.Close();

responseStream.Close();

}

}

}

多线程爬取网页代码:

using System;

using System.Collections.Generic;

using System.ComponentModel;

using System.Data;

using System.Drawing;

using System.IO;

using System.Linq;

using System.Text;

using System.Text.RegularExpressions;

using System.Threading;

using System.Threading.Tasks;

using System.Windows.Forms;

using Utils;

namespace 爬虫

{

public partial class Form1 : Form

{

List<Thread> threadList = new List<Thread>();

Thread thread = null;

public Form1()

{

InitializeComponent();

}

private void button1_Click(object sender, EventArgs e)

{

DateTime dtStart = DateTime.Now;

button3.Enabled = true;

button2.Enabled = true;

button1.Enabled = false;

int page = 0;

int count = 0;

int personCount = 0;

lblPage.Text = "已完成页数:0";

int index = 0;

for (int i = 1; i <= 10; i++)

{

thread = new Thread(new ParameterizedThreadStart(delegate(object obj)

{

for (int j = 1; j <= 10; j++)

{

try

{

index = (Convert.ToInt32(obj) - 1) * 10 + j;

string pageHtml = HttpRequestUtil.GetPageHtml("http://tt.mop.com/c44/0/1_" + index.ToString() + ".html");

Regex regA = new Regex("<a[\\s]+class=\"J-userPic([^<>]*?)[\\s]+href=\"([^\"]*?)\"");

Regex regImg = new Regex("<p class=\"tc mb10\"><img[\\s]+src=\"([^\"]*?)\"");

MatchCollection mc = regA.Matches(pageHtml);

foreach (Match match in mc)

{

int start = match.ToString().IndexOf("href=\"");

string url = match.ToString().Substring(start + 6);

int end = url.IndexOf("\"");

url = url.Substring(0, end);

if (url.IndexOf("/") == 0)

{

string imgPageHtml = HttpRequestUtil.GetPageHtml("http://tt.mop.com" + url);

personCount++;

lblPerson.Invoke(new Action(delegate() { lblPerson.Text = "已完成条数:" + personCount.ToString(); }));

MatchCollection mcImgPage = regImg.Matches(imgPageHtml);

foreach (Match matchImgPage in mcImgPage)

{

start = matchImgPage.ToString().IndexOf("src=\"");

string imgUrl = matchImgPage.ToString().Substring(start + 5);

end = imgUrl.IndexOf("\"");

imgUrl = imgUrl.Substring(0, end);

if (imgUrl.IndexOf("http://i1") == 0)

{

try

{

HttpRequestUtil.HttpDownloadFile(imgUrl);

count++;

lblNum.Invoke(new Action(delegate()

{

lblNum.Text = "已下载图片数" + count.ToString();

DateTime dt = DateTime.Now;

double time = dt.Subtract(dtStart).TotalSeconds;

if (time > 0)

{

lblSpeed.Text = "速度:" + (count / time).ToString("0.0") + "张/秒";

}

}));

}

catch { }

Thread.Sleep(1);

}

}

}

}

}

catch { }

page++;

lblPage.Invoke(new Action(delegate() { lblPage.Text = "已完成页数:" + page.ToString(); }));

if (page == 100)

{

button1.Invoke(new Action(delegate() { button1.Enabled = true; }));

MessageBox.Show("完成!");

}

}

}));

thread.Start(i);

threadList.Add(thread);

}

}

private void button2_Click(object sender, EventArgs e)

{

button1.Invoke(new Action(delegate()

{

foreach (Thread thread in threadList)

{

if (thread.ThreadState == ThreadState.Suspended)

{

thread.Resume();

}

thread.Abort();

}

button1.Enabled = true;

button2.Enabled = false;

button3.Enabled = false;

button4.Enabled = false;

}));

}

private void Form1_FormClosing(object sender, FormClosingEventArgs e)

{

foreach (Thread thread in threadList)

{

thread.Abort();

}

}

private void button3_Click(object sender, EventArgs e)

{

foreach (Thread thread in threadList)

{

if (thread.ThreadState == ThreadState.Running)

{

thread.Suspend();

}

}

button3.Enabled = false;

button4.Enabled = true;

}

private void button4_Click(object sender, EventArgs e)

{

foreach (Thread thread in threadList)

{

if (thread.ThreadState == ThreadState.Suspended)

{

thread.Resume();

}

}

button3.Enabled = true;

button4.Enabled = false;

}

}

}

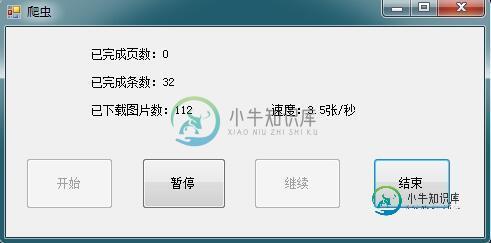

截图:

以上就是本文的全部内容,希望对大家的学习有所帮助。

-

本文向大家介绍基于C#实现网络爬虫 C#抓取网页Html源码,包括了基于C#实现网络爬虫 C#抓取网页Html源码的使用技巧和注意事项,需要的朋友参考一下 最近刚完成一个简单的网络爬虫,开始的时候很迷茫,不知道如何入手,后来发现了很多的资料,不过真正能达到我需要,有用的资料--代码很难找。所以我想发这篇文章让一些要做这个功能的朋友少走一些弯路。 首先是抓取Html源码,并选择<ul class="

-

本文向大家介绍基python实现多线程网页爬虫,包括了基python实现多线程网页爬虫的使用技巧和注意事项,需要的朋友参考一下 一般来说,使用线程有两种模式, 一种是创建线程要执行的函数, 把这个函数传递进Thread对象里,让它来执行. 另一种是直接从Thread继承,创建一个新的class,把线程执行的代码放到这个新的class里。 实现多线程网页爬虫,采用了多线程和锁机制,实现了广度优先算法

-

本文向大家介绍利用C#实现网络爬虫,包括了利用C#实现网络爬虫的使用技巧和注意事项,需要的朋友参考一下 网络爬虫在信息检索与处理中有很大的作用,是收集网络信息的重要工具。 接下来就介绍一下爬虫的简单实现。 爬虫的工作流程如下 爬虫自指定的URL地址开始下载网络资源,直到该地址和所有子地址的指定资源都下载完毕为止。 下面开始逐步分析爬虫的实现。 1. 待下载集合与已下载集合 为了保存需要下载的URL

-

本文向大家介绍基于nodejs 的多页面爬虫实例代码,包括了基于nodejs 的多页面爬虫实例代码的使用技巧和注意事项,需要的朋友参考一下 前言 前端时间再回顾了一下node.js,于是顺势做了一个爬虫来加深自己对node的理解。 主要用的到是request,cheerio,async三个模块 request 用于请求地址和快速下载图片流。 https://github.com/request/r

-

主要内容:导入所需模块,拼接URL地址,向URL发送请求,保存为本地文件,函数式编程修改程序本节讲解第一个 Python 爬虫实战案例:抓取您想要的网页,并将其保存至本地计算机。 首先我们对要编写的爬虫程序进行简单地分析,该程序可分为以下三个部分: 拼接 url 地址 发送请求 将照片保存至本地 明确逻辑后,我们就可以正式编写爬虫程序了。 导入所需模块 本节内容使用 urllib 库来编写爬虫,下面导入程序所用模块: 拼接URL地址 定义 URL 变量,拼接 url 地址。代码如下所示:

-

本文向大家介绍基于jQuery实现网页进度显示插件,包括了基于jQuery实现网页进度显示插件的使用技巧和注意事项,需要的朋友参考一下 相信大家都见过类似的网站功能,这种形式的进度显示可以很方便的让用户去理解和操作, 以下是插件的测试截图 ,提供了两个皮肤 使用js编写 可以灵活的生成进度条 方便进对一些工作进度进行图形显示 1、简单的调用 //所有步骤的数据 var stepListJson=[