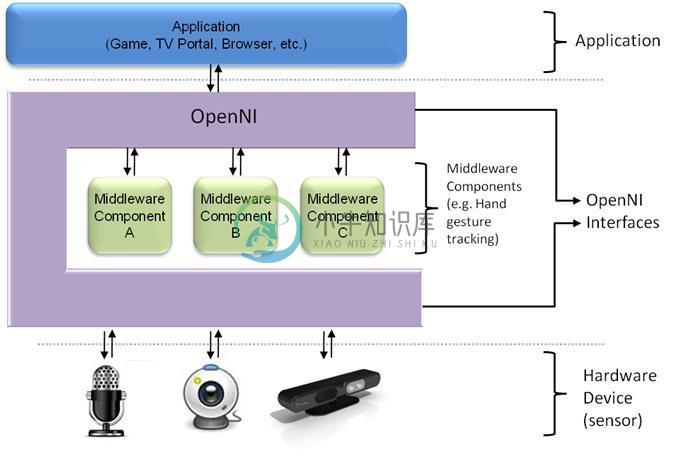

OpenNI(开放自然交互)是一个多语言,跨平台的框架,它定义了编写应用程序,并利用其自然交互的API。OpenNI API由一组可用来编写通用自然交互应用的接口组成。

OpenNI的主要目的是要形成一个标准的API,来搭建以下两方面之间通信的桥梁:

1、视觉和音频传感器(包括分析周围环境的设备);

2、视觉和音频感知中间件(用于实时的记录音频和视觉分析的数据并理解它们的软件组件)。

例如,一个中间件可以接收一副有人的图像,计算并返回人手掌在图像中的位置。OpenNI提供了一组基于传感器设备的API,以及一组由中间件组件实现的API。通过打破传感器和中间件之间的依赖,使用OpenNI的API编写应用程序就不需要额外的努力去处理由不同的中间件共存带来的问题(跨平台)。

OpenNI的API还允许开发人员直接基于最原始的数据格式编写中间件上层的算法,而不管这些数据是由哪个传感器设备产生的。同时OpenNI的这种机制给了传感器制造商一个充分的自由空间去制造自己的传感器而不用考虑上层OpenNI兼容的应用程序。

OpenNI API使得自然交互应用开发人员通过传感器输出的标准化了的数据类型来处理真实的三维数据(这些标准化的数据类型可以表示人体全身,手的位置,或者仅仅是一个含有深度信息的像素图等)。编写应用程序的时候不用考虑传感器或中间件供应商相关的细节。

-

原文:https://blog.csdn.net/magicfrog2009/article/details/73658581 OpenNI中文译为开放自然语言交互,用官方的表述来讲就是a standard framework for 3D sensing,用于3D感知的开发接口; OpenNI2是第二代版本,相对于第一代更加专注于对3D设备的支持和数据的获取,移除了手势识别等中间件的方式,代码更

-

OpenNI (Version 1.5.4.0 - May 7th 2012) --------------------------------------- Website: http://www.primesense.com Forum: http://groups.google.com/group/openni-dev Wiki: http://wiki.openni.org Binarie

-

在使用openni2时报错 Traceback (most recent call last): File “C:/Users/asus/Desktop/相机标定/test.py”, line 142, in dev.set_depth_color_sync_enabled(True) File “C:\Users\asus\AppData\Roaming\Python\Python38\site

-

我曾尝试在VisualStudio2008中设置Interactive Broker的C API,但我知道的C非常有限,并且不断出现错误: 1)是否有任何方法可以使用某种轻量级的脚本语言来连接到Interactive Brokers并进行交易。 像Python这样轻量级的东西就可以了,是的,我已经研究过IBMY,但我不明白java2python系统是如何工作的。 2) 您是如何设置您的自动系统的,

-

这是我第一次与kotlin mvp Rx一起使用mockito,并且,我得到一个错误“wanted但not invoked-but,This mock正好有1个交互” 这里是我的演示者类 这里是我的演示者视图 }此处是我的AppSchedulerProvider类AppSchedulerProvider:SchedulerProvider{override fun trampoline():Sch

-

Xcode 7.3 beta 3 中 iOS 和 OS X 的 Playground 添加了交互性,它允许你在 Playground 中与你写的代码进行点击、拖拽、输入以及其他交互。这些界面的响应将和它们在应用中完全一致。可交互的 Playground 可以帮助你快速建模和建立你的应用,并且提供了一个与你代码交互的完美方式。 任何指定到 XCPlaygroundPage 中 liveView 属性

-

交互可以添加基本的基于鼠标的行为到任何元素。 使用交互,我们可以创建可排序列表,可调整大小的元素,拖放行为.Interactions还为更复杂的小部件和应用程序构建了很好的构建块。 Sr.No. 互动和描述 1 Drag able 在任何DOM元素上启用可拖动功能。 2 Drop able 允许任何DOM元素丢弃。 3 Resize able 允许任何DOM元素调整大小。 4 Select abl

-

按钮 角度传感器 滑动电位器 摇杆 多路触摸

-

按钮 角度传感器 滑动电位器 摇杆 多路触摸