《兴业数金》专题

-

如何在同一管道中使用ApacheBeamPython作业从BigQuery和文件系统读取数据?

我正在尝试使用下面的代码从Bigquery读取一些数据,并从文件系统读取一些数据。 但是,当我运行这个管道时,我得到了以下错误 Traceback(最近一次调用):File"/etl/dataflow/etlTXLPreprocessor.py",第125行,在run()File"/etl/dataflow/etlTXLPreprocessor.py",第120行,在runp.run()中。wai

-

是否需要澄清将作业映射/减少到数据集的计算机平均值?

我正在学习map/reduce,我正在研究计算数据集中特定列中所有值的平均值的问题。 到目前为止,我在上看到的所有解决方案都遵循这一思路 数据集 1 2 3 4 5 映射作业:生成键、值对,键为1 (1,1) (1,2) (1,3) 和(1,4) 现在,由于映射作业的输出的键是相同的,因此所有这些键都将发送到一个化简器,在那里我们可以进行计算总和/计数 然而,我的问题是,对所有条目使用相同的键是否

-

2023届校招面经:浦发银行总行业务零售部-数据分析类岗位

2023届校招面经:浦发银行总行业务零售部-数据分析类岗位TimeLine:一面20221108,二面20221124 BG:北邮本硕,管理类专业,两段实习经历:字节数据分析师、美团商业分析师 一面 群面,10名候选人,5分钟阅读题目,每人1分钟时间陈述个人看法,10分钟时间团队讨论,5分钟时间汇报,之后会对一部分面试者进行单独提问 二面 5分钟时间,体验很一般,面试官会在面试者回答问题时打断发言,且面试官问的问题与岗位本身无太大关联 1. 1分钟时间自

-

java - Java 对于MYSQL树形结构如何统计各个节点对应的业务数量?

对于MYSQL树形结构如何统计各个节点对应的业务数量 例如:mysql有id、type、parentId、num字段,type 1、2、3代表省市县,parentId为父级id,num代表各个类型的人口数量,一个市下面有多个县,市的num数量是该市下所有县num数量的和,省也是同理。 如果县人口出现了变化,有什么方案快速高效的更新各个节点的num。 如果人口变动这个业务在代码中各个模块都有涉及,并

-

请谈谈你的职业规划是怎样的?说说未来1年、3年、5年的职业规划。

本文向大家介绍请谈谈你的职业规划是怎样的?说说未来1年、3年、5年的职业规划。相关面试题,主要包含被问及请谈谈你的职业规划是怎样的?说说未来1年、3年、5年的职业规划。时的应答技巧和注意事项,需要的朋友参考一下

-

是否有可能将一个 Jenkins 作业链接到另一个作业并建立上游/下游关系?

我需要从一个上游作业生成可变数量的作业。AFAIK,没有插件可以做到这一点。最近的一个是多任务插件(https://wiki.jenkins-ci.org/display/JENKINS/Multijob插件)。因此,我想创建一个构建步骤,使用Jenkins API(REST、groovy或Jenkins cli)之一来触发这些构建。但是,如果我这样做,这些构建将变得“分离”(意味着它们没有上游作

-

詹金斯(Jenkins):分组作业并限制该组的构建处理器

问题内容: 我们正在为詹金斯(Jenkins)经营很多工作。目前,这些作业通过使用“主作业”进行了分组。这些仅执行一组的所有工作。但是,如果运行这些主作业之一,它将同时启动约10个其他作业。根据这些工作的持续时间和构建处理器的数量(目前为6个),Jenkins被阻止了更长的时间(最多一个小时)。另一件事是,这些作业实际上并不适合进行如此大规模的并行化。 为了解决这个问题,我正在寻找一种方法(一个插

-

詹金斯间歇挂在git克隆/从github在管道作业结账

您是否看到并有针对该问题的解决方案或调查想法: > 使用GitHub SCM管道的jenkins管道作业在克隆/签出时间歇性挂起 詹金斯日志中没有关于这种情况的报道 只有在我们有大量活动时(通常在sprint演示之前)才会发生这种情况。 一段时间后清除-尚未检测到太多模式 签出gitgit@github.com:MyTeam/myproject-into/var/lib/jenkins/jobs/

-

兑吧荣获艾瑞金瑞奖,领跑企业用户运营服务

5月23日, 2018艾瑞年度高峰会议暨金瑞奖颁奖典礼在北京隆重举行。兑吧作为国内领先的用户运营服务平台,荣膺金瑞奖“企业服务创新奖”。 ::: hljs-center ::: 据悉,“艾瑞年度高峰会议”现已成为中国互联网极具影响力的品牌盛会,金瑞奖由艾瑞咨询超百位权威研究专家团队综合评审,为表彰过去一年在新经济领域有突出表现的创新产品、新技术服务、网络应用以及创新领袖人物而设立的奖项。经过十二年

-

Spring Batch--我有多个作业要顺序执行,并将第一个作业的结果传递给第二个

Spring批处理作业我有多个作业要顺序执行。我需要将工作1的结果传递到工作2,在那里它将被处理,然后将工作2的数据传递到工作3。诸如此类。并且可以使用job1到job5(最后一个作业)的结果并写入输出。 Job1-从db读取并将结果存储在Hashmap中,Job2从文件读取并使用Job1 Hashmap处理结果。 所以请大家给出最好的解决方案。我能够使用ExecutionContext和JobP

-

如何将map reduce作业的输出直接写入分布式缓存,以便传递给另一个作业

我目前正在练习Map-reduce(Hadoop2.2),需要您在其中一个概念上的帮助。 我有一个用例,我想用两个工作来完成。我希望job1的输出被写入分布式缓存,并将其作为输入传递到第二个作业。 注意:这两个文件都包含非常大的数据。 找出每首古典歌曲的平均评分。 我提出的实际/预期解决方案是,我将使用两个链接作业。 1.job1:它将获得所有经典歌曲的ID,并添加到分发缓存 非常感谢你的帮助。

-

将所有映射器中遇到的最大键作为参数传递给下一个作业

我有一系列Map/Reduce作业: Job1将带有时间戳的数据作为键,将一些数据作为值并对其进行转换。 对于Job2,我需要传递Job1中所有映射器的最大时间戳作为参数。(我知道如何将参数传递给映射器/简化器) 我可以跟踪Job1的每个映射器中的最大时间戳,但如何在所有映射器中获得最大时间戳并将其作为参数传递给Job2呢?

-

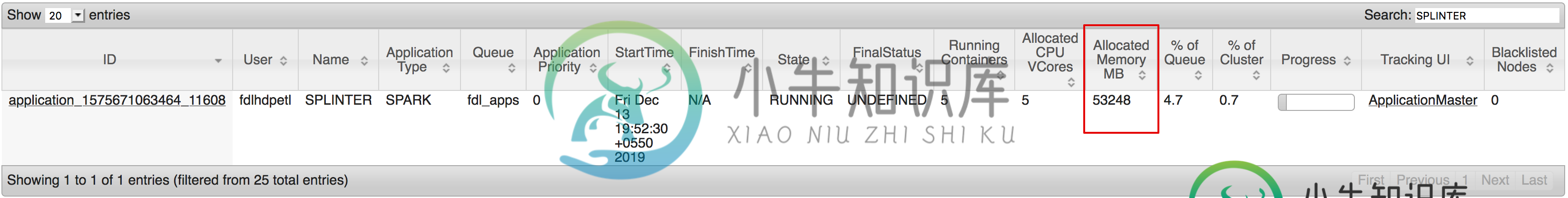

为什么给spark作业的executor内存参数与线程上分配的内存不匹配?

为什么给spark作业的executor内存参数与线程上分配的内存不匹配?我有一个关于火花执行器内存的被遗忘已久的问题。我在代码中为火花作业提供了这些参数。 案例1: 执行人 这是运行的执行器数量及其内存的样子 为什么分配的内存是53248MB(52GB)?它是否也与开销内存值相加?即使是这样= 因此,我再次更改了作业中的内存参数,如下所示: 案例2:这次我给了司机 后台的执行者: 如果添加了所有内存编号,它仍会变为:4 个执行程序 * 每个执行程序 2gb = 火花提

-

在GCP数据流使用apache beam完成作业后,是否有任何方法进行处理?

GCP数据流状态完成/完成后,是否有任何方式进行后处理。我有一个过程,数据流从GCP存储中批量读取一个文件,并执行一些外部api调用以进行转换,然后写回另一个文件。在所有批次转换/处理后,我需要做一些额外的处理。有办法吗?我正在使用ApacheBeam和模板来运行GCPDatatflow。

-

Google数据流作业在writeToBiqquery步骤中失败:“list”对象和“str”对象没有属性“items”

我有一个使用数据流流道运行的光束管道。它接受XML并输出JSON,然后将其存储在BigQuery表中。早些时候,我正在使用束管道将换行符分隔的JSON写入GCS桶,并从文件中创建BQ表,而不对其进行任何更改(使用bigQuery控制台)。作业成功运行,数据被导入到BQ中,没有任何问题。 现在我修改了管道,以便将输出JSON行直接写入BQ表。我使用的是阿帕奇光束。木卫一。WriteToBigQuer