《负载均衡》专题

-

nginx+iis实现简单的负载均衡

nginx+iis实现简单的负载均衡本文向大家介绍nginx+iis实现简单的负载均衡,包括了nginx+iis实现简单的负载均衡的使用技巧和注意事项,需要的朋友参考一下 最近在研究分布式系统架构方面的知识,包括负载均衡,数据库读写分离,分布式缓存redis等。本篇先从负载均衡服务架构入手,关于负载均衡百度百科的定义如下:负载均衡,英文名称为Load Balance,其意思就是分摊到多个操作单元上进行执行,例如Web服务器、FTP服

-

通道池中的Netty负载均衡器

我正在为我的应用程序(两个系统集成)使用protobuf rpc pro。protobuf rpc pro基于Netty并使用Netty的这种依赖关系: 我需要为两个系统之间的通信实现通道池,以获得高性能。一、 在我的实现中,我希望获得多个连接,这些连接将并行发送消息(非阻塞通信)。这里的问题是,我如何检查发送缓冲区是否已满,并切换到另一个连接(如负载平衡)。在Netty或某些外部实现中是否有任何

-

入口和AWS应用型负载均衡

是否需要检查在EKS中创建的入口资源和由AWS负载均衡器控制器创建的应用程序负载均衡器之间的映射? 我的理解是AWS LBC为类“alb”的入口创建了ALB。删除入口资源后,应该删除此ALB。 但这种情况有时不会发生。可能是因为我搞乱了其他相关资源,比如statefulset、service或pod。(或者可能是由于重复部署而没有首先删除?) 那么,有没有办法在AWS中查看入口和相应ALB之间的链

-

gcloud入口负载均衡器/静态ip

设置默认的gce入口控制器,使用设置为响应主机名的入口资源 拥有静态ip的好处(在我目前的观点中)是,你永远不会想知道在哪里配置你的域,它将始终保持相同的ip;另一方面,你可以尽可能多地提供服务 我是使用这个gce负载均衡器的新手,我可以像使用静态ip一样依赖它吗(意味着它永远不会改变)?或者是否有一个层要添加以将静态ip指向负载均衡器? 我这么问是因为您可以设置服务资源的ip。但我还不知道如何使

-

1.6.4 使用多副本和负载均衡

简介 Xiaomi Cloud-ML模型服务支持多副本和负载均衡,用户创建模型服务时指定副本数,又平台创建多副本实例并且实现负载均衡功能,用户可以像使用单节点服务一样访问整个集群。 使用多副本功能 用户创建模型服务时加入 -r 参数即可自动创建多副本实例和负载均衡。 cloudml models create -n linear -v v1 -u fds://cloud-ml/linear -r

-

流量管理 - 发现和负载均衡

本节描述在服务网格中Istio如何在服务实例之间实现流量的负载均衡。 服务注册: Istio假定存在服务注册表,以跟踪应用程序中服务的pod/VM。它还假设服务的新实例自动注册到服务注册表,并且不健康的实例将被自动删除。诸如Kubernetes,Mesos等平台已经为基于容器的应用程序提供了这样的功能。为基于虚拟机的应用程序提供的解决方案就更多了。 服务发现: Pilot使用来自服务注册的信息,并

-

linux下Nginx+Tomcat负载均衡配置方法

本文向大家介绍linux下Nginx+Tomcat负载均衡配置方法,包括了linux下Nginx+Tomcat负载均衡配置方法的使用技巧和注意事项,需要的朋友参考一下 Nginx+tomcat是目前主流的java web架构,如何让nginx+tomcat同时工作呢,也可以说如何使用nginx来反向代理tomcat后端均衡呢?直接安装配置如下: 1、JAVA JDK安装: 2、Nginx安装: 3

-

Traefik边缘路由器前的负载均衡

查看OpenShift HA代理或Traefik项目:https://docs.traefik.io/.我可以看到Traefik入口控制器部署为DaemonSet。它可以使用虚拟主机将流量路由到正确的服务/endpoint。 假设我有一个包含几个节点的Kubernetes集群。我如何避免单点故障? 我应该在我的节点前面有一个负载平衡器(或DNS负载平衡)吗? 如果是,这是否意味着: 负载均衡器会将

-

Spring Cloud Ribbon负载均衡器处理方法

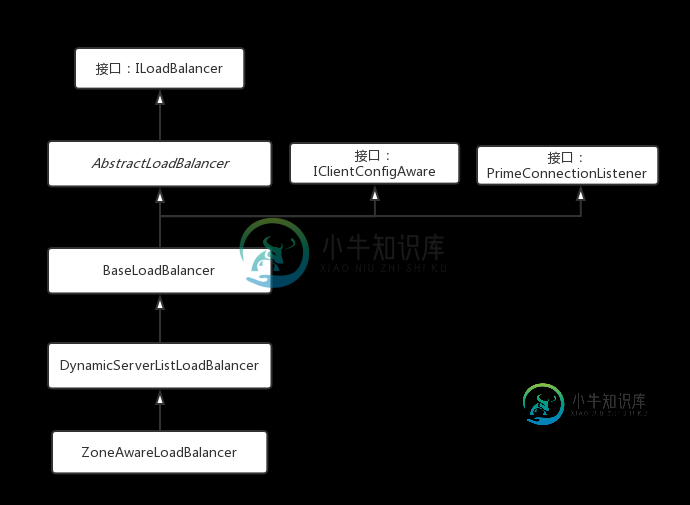

Spring Cloud Ribbon负载均衡器处理方法本文向大家介绍Spring Cloud Ribbon负载均衡器处理方法,包括了Spring Cloud Ribbon负载均衡器处理方法的使用技巧和注意事项,需要的朋友参考一下 接下来撸一撸负载均衡器的内部,看看是如何获取服务实例,获取以后做了哪些处理,处理后又是如何选取服务实例的。 分成三个部分来撸: 配置 获取服务 选择服务 配置 在上一篇《撸一撸Spring Cloud Ribbon的原理》的

-

使用Nginx实现负载均衡的策略

本文向大家介绍使用Nginx实现负载均衡的策略,包括了使用Nginx实现负载均衡的策略的使用技巧和注意事项,需要的朋友参考一下 一、nginx简介 nginx是一个高性能的HTTP服务器和反向代理服务器。它起初是俄罗斯人Igor Sysoev开发的,至今支撑者俄罗斯的很多大型的网站。 二、nginx支持的三种负载均衡策略 轮询:将请求依次轮询发给每个服务器。 最少链接:将请求发送给持有最少活动链接

-

详解 Nginx代理功能与负载均衡

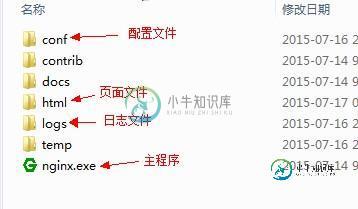

详解 Nginx代理功能与负载均衡本文向大家介绍详解 Nginx代理功能与负载均衡,包括了详解 Nginx代理功能与负载均衡的使用技巧和注意事项,需要的朋友参考一下 序言 Nginx的代理功能与负载均衡功能是最常被用到的,关于nginx的基本语法常识与配置已在上篇文章中有说明,这篇就开门见山,先描述一些关于代理功能的配置,再说明负载均衡详细。 Nginx代理服务的配置说明 1、上一篇中我们在http模块中有下面的配置,当代理遇到状

-

nginx基于tcp做负载均衡的方法

本文向大家介绍nginx基于tcp做负载均衡的方法,包括了nginx基于tcp做负载均衡的方法的使用技巧和注意事项,需要的朋友参考一下 配置多台服务器时,经常需要让各个服务器之间的时间保持同步,如果服务器有外网环境,可以直接同外部的时间服务器更新时间,可以采用rdate命令更新时间: rdate -s tick.greyware.com 可以写个脚本放在/etc/cron.hourly中每小时校

-

python负载均衡的简单实现方法

本文向大家介绍python负载均衡的简单实现方法,包括了python负载均衡的简单实现方法的使用技巧和注意事项,需要的朋友参考一下 提到分发请求,相信大多数人首先会想到Nginx,Nginx作为一种多功能服务器,不仅提供了反向代理隐藏主机ip的能力,还拥有简单的缓存加速功能。当然Nginx最强大的功能还是分发请求,不仅提供了哈希,一致性哈希,负载均衡等多种请求分发模式,还保证了自己服务的轻量和稳定

-

tomcat6_apache2.2_ajp 负载均衡加集群实战分享

本文向大家介绍tomcat6_apache2.2_ajp 负载均衡加集群实战分享,包括了tomcat6_apache2.2_ajp 负载均衡加集群实战分享的使用技巧和注意事项,需要的朋友参考一下 环境: -------------------------------------------- 一台apache2.2服务器,三台tomcat服务器: apache2.2服务器 1.ip:192.168

-

GKE负载均衡器的入口控制器

GCP为GKE负载平衡器提供了自己的托管入口控制器。我还看到了部署和利用Nginx入口控制器的文档。 https://cloud.google.com/community/tutorials/nginx-ingress-gke 内置入口控制器也在负载均衡器级别处理SSL终止。是否有特定的流量处理能力使Nginx成为GKE更好的入口控制候选者?