《负载均衡》专题

-

Google负载均衡器健康检查失败

根据以下官方文件,我在GKE上安装了Kubernetes入口控制器。 入口控制器运行良好。 它自动创建TCP负载平衡器、健康检查和防火墙规则。我的kubernetes群集有3个节点。有趣的是,有两次健康检查失败。它传递给入口控制器正在运行的实例。我调试了它,但没有找到任何线索。谁能帮我一下吗。

-

Azure Service Fabric集群内部负载均衡器

作为开发人员,我们在Azure Service Fabric上编写了微服务,我们可以在Azure中以某种PaaS概念为许多客户运行它们。但我们的一些客户不想在云中运行,因为数据库是内部的,不能从外部获得,甚至不能通过DMZ获得。没关系,我们promise支持它,因为Azure Service Fabric可以作为集群安装在现场。 我建议在一台(或多台)独立的机器上使用负载平衡器,如HA-Proxy

-

第二十章 重定向与负载均衡

内容提要 本章主要介绍了网站重定向和负载均衡的一些技术,术语网站架构方面的知识! 技术概览 重定向技术通常可以用来确定报文是否终结于某个代理、缓存或服务器集群中某台特定的服务器。重定向技术可以将报文发送到客户端没有显示请求的地方去。与此需要涉及到的技术: 1、HTTP重定向 2、DNS重定向 3、任播路由 4、策略路由 5、IP MAC转发 6、IP地址转发 7、WCCP(Web缓存协调协议) 8

-

消费者负载均衡服务RebalanceService入口

主要内容:1 负载均衡or重平衡的触发,1.1 RebalanceService自动重平衡,1.2 Consumer启动重平衡,1.3 Broker请求重平衡,2 小结基于RocketMQ release-4.9.3,深入的介绍了消费者负载均衡服务RebalanceService入口源码。 RocketMQ一个消费者组中可以有多个消费者,在集群模式下他们共同消费topic下的所有消息,RocketMQ规定一个消息队列仅能被一个消费者消费,但一个消费者可以同时消费多个消息队列。这就涉及到如何将多个

-

如何将库伯内特斯通用式“负载均衡器”与特定的云负载均衡器集成

我正在为多云开发一个新的“Kubernetes即服务”平台(如GKE等)。 问题是:K8S服务类型“LoadBalancer”与云负载平衡器(Kubernetes外部)配合使用。吉凯恩 我想在我的新“Kubernetes As a Service”平台上提供类似的功能,用户可以在该平台上选择云提供商,创建Kubernetes集群 在Kubernetes集群创建之前,我能够自动执行流程,但在“K8S

-

在具有nginx和负载均衡器的节点应用中执行负载测试

我有一个节点应用程序,它为用户提供了一个提供在线考试的门户。现在我要在这个服务器上执行负载测试。为此,我使用apache JMeter。在后端,我创建了两个节点服务器实例(8GB ram,每个4个核),并使用Nginx的负载平衡器管理它们。因此,当我对500个用户执行负载测试时,我会得到网关超时(504)错误。另外,对于某些请求,我没有在JMeter中得到响应。同时,当我检查我的两个节点服务器时,

-

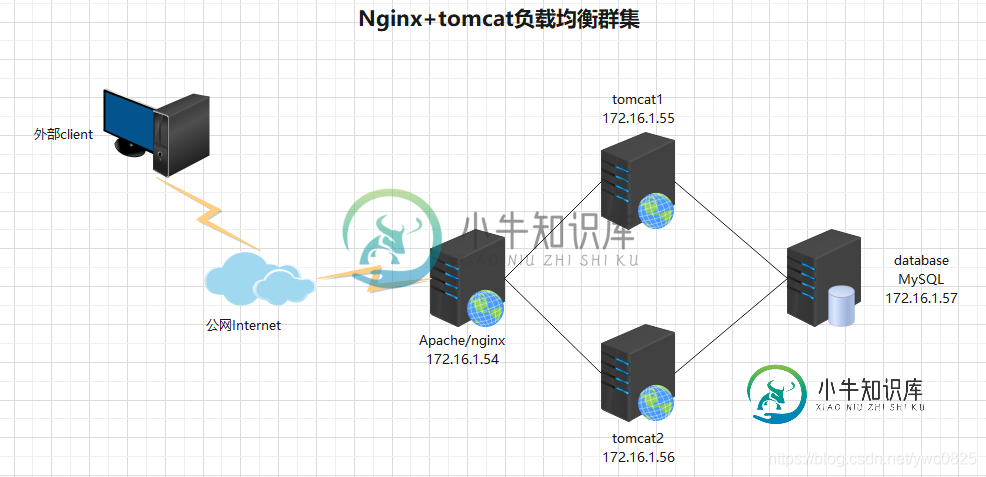

Nginx+tomcat负载均衡集群的实现方法

Nginx+tomcat负载均衡集群的实现方法本文向大家介绍Nginx+tomcat负载均衡集群的实现方法,包括了Nginx+tomcat负载均衡集群的实现方法的使用技巧和注意事项,需要的朋友参考一下 实验环境如下 这里需要准备4台服务器(1台nginx、2台tomcat做负载、一台MySQL做数据存储) 准备软件包如下: 软件包地址连接: 链接: https://pan.baidu.com/s/1Zitt5gO5bDocV_8TgilvRw

-

windows下nginx+tomcat配置负载均衡的方法

本文向大家介绍windows下nginx+tomcat配置负载均衡的方法,包括了windows下nginx+tomcat配置负载均衡的方法的使用技巧和注意事项,需要的朋友参考一下 目标:Nginx做为HttpServer,连接多个tomcat应用实例,进行负载均衡。 注:本例程以一台机器为例子,即同一台机器上装一个nginx和2个Tomcat且安装了JDK1.7。 1、安装Nginx 安装Ngin

-

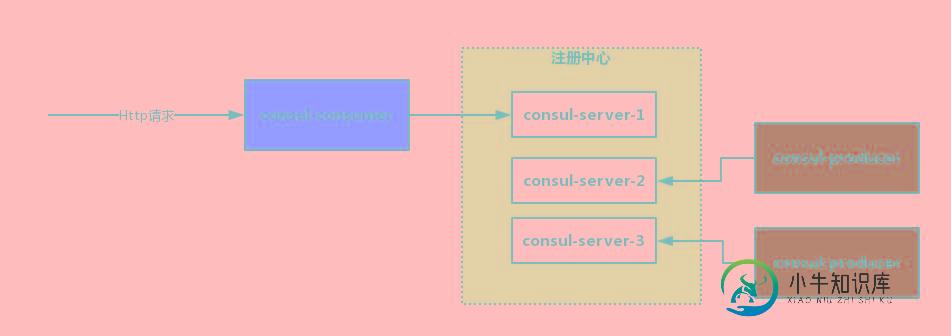

SpringCloud与Consul集成实现负载均衡功能

SpringCloud与Consul集成实现负载均衡功能本文向大家介绍SpringCloud与Consul集成实现负载均衡功能,包括了SpringCloud与Consul集成实现负载均衡功能的使用技巧和注意事项,需要的朋友参考一下 负载均衡(Load Balance,简称LB)是一种服务器或网络设备的集群技术。负载均衡将特定的业务(网络服务、网络流量等)分担给多个服务器或网络设备,从而提高了业务处理能力,保证了业务的高可用性。负载均衡基本概念有:实服务

-

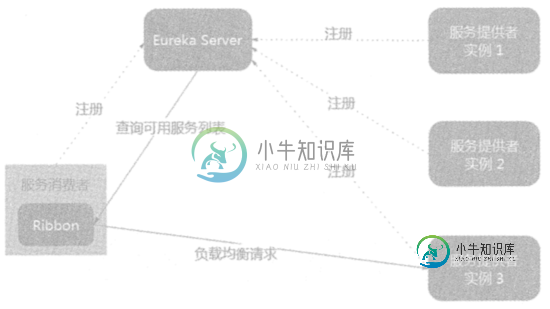

Spring Cloud 负载均衡器 Ribbon原理及实现

Spring Cloud 负载均衡器 Ribbon原理及实现本文向大家介绍Spring Cloud 负载均衡器 Ribbon原理及实现,包括了Spring Cloud 负载均衡器 Ribbon原理及实现的使用技巧和注意事项,需要的朋友参考一下 Ribbon简介 分布式系统中,各个微服务会部署多个实例,如何将服务消费者均匀分摊到多个服务提供者实例上,就要使用到负载均衡器 Ribbon 是负载均衡器 ,它提供了很多负载均衡算法,例如轮询、随即等,在配置服务提供

-

Netty KeepAlive工作得太好了负载均衡器

我们有一个使用嵌入式Netty服务器处理REST请求的系统。该系统位于负载平衡器后面的三台机器上。 我们连接到系统并不断发送请求。 问题是连接永远保持活动状态,所以如果一台机器出现故障并恢复,它永远不会收到任何请求。 Apache有一个配置选项MaxKeepAliveRequest,它是一个连接中关闭连接并打开另一个连接之前的最大请求数。 Netty中是否有等效项?还是我需要自己做?

-

Nginx做NodeJS应用负载均衡配置实例

本文向大家介绍Nginx做NodeJS应用负载均衡配置实例,包括了Nginx做NodeJS应用负载均衡配置实例的使用技巧和注意事项,需要的朋友参考一下 负载均衡可以把用户的请求分摊到多个服务器上进行处理,从而实现了对海量用户的访问支持。负载均衡的架构如图所示: 对于复杂的Web应用来说,用Nginx做前端负载均衡是理所当然的事。 下面,我们用Nginx做NodeJS应用的负载均衡。 1、配置Ngi

-

5种nginx负载均衡配置方法分享

本文向大家介绍5种nginx负载均衡配置方法分享,包括了5种nginx负载均衡配置方法分享的使用技巧和注意事项,需要的朋友参考一下 一、轮询(默认) 每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器down掉,能自动剔除。 二、weight 指定轮询几率,weight和访问比率成正比,用于后端服务器性能不均的情况。 例如: 三、ip_hash 每个请求按访问ip的hash结果分

-

HTTPS-Redirect和AWS负载均衡器背后的Traefik

问题内容: 我正在尝试将所有传入的Traefik从http重定向到https,用于Web应用程序,该应用程序从具有自定义端口的docker容器中获取。 如果我构建了这个docker compose文件,并扩展了应用程序,一切将按预期工作。我可以请求应用程序的http和https,但是我尝试实现仅提供https并将http重定向到https的目的。 由于我使用的是Docker-Compose文件,因

-

内部负载均衡器的GCP健康检查

我在GCP中建立了自己的Elasticsearch集群。群集已启动并运行良好。 集群包含两个客户端节点,我可以使用它们在内部访问并通过运行状况检查http://IP:9200/和