《tensorflow》专题

-

运行g2p-seq2seq--version时加载本机TensorFlow运行时失败

Mac OS我正在尝试使用cMu字典进行语音识别。我采取的步骤: 结果: 名称:tensorflow 版本:1.12。0 摘要:TensorFlow是一个面向所有人的开源机器学习框架 主页:https://www.tensorflow.org/ 作者:谷歌公司 作者电子邮件:opensource@google.com 许可证:Apache 2.0 位置:/Library/Frameworks/Py

-

Tensorflow模型精度和对熊猫数据帧的损失

我正在训练一个张量流DNN模型,它会给出这样的结果, 我可以生成一个数据帧有纪元,损失,准确性,val_accuracy和val_loss? 喜欢

-

Tensorflow训练崩溃在第一个时代的最后一步音频分类器

我试图将最初用Pytorch编写的自定义DNN网络转换为Tensorflow 2,该网络具有所需的输入形状(batchsize,39101,1)。在使用特征提取器并获得具有兼容维度的序列和验证数据集的维度(total_samples,39101,1)之后,我尝试使用模型来训练模型。适合在第一个纪元的最后一步,我面临一个错误,如下所示,这表明我的张量形状正在发生某种变化。我不知道为什么这只发生在最后

-

如何转换一个自定义的损失函数与logits,内置在tensorflow到keras?

我有一个损失函数内建的tenstorflow,它需要logits和标签作为输入: 问题是keras损失函数的格式不同: 它使用y_truey_pred作为输入, 我找到了一种在keras中获取Logit的方法,在模型的最后一层中使用线性激活而不是softmax。 但我需要我的模型在最后一层有softmax激活,你认为解决方案是什么?非常感谢。

-

在Tensorflow估计器中,如何获得列车损失并评估每个全局步骤的损失?

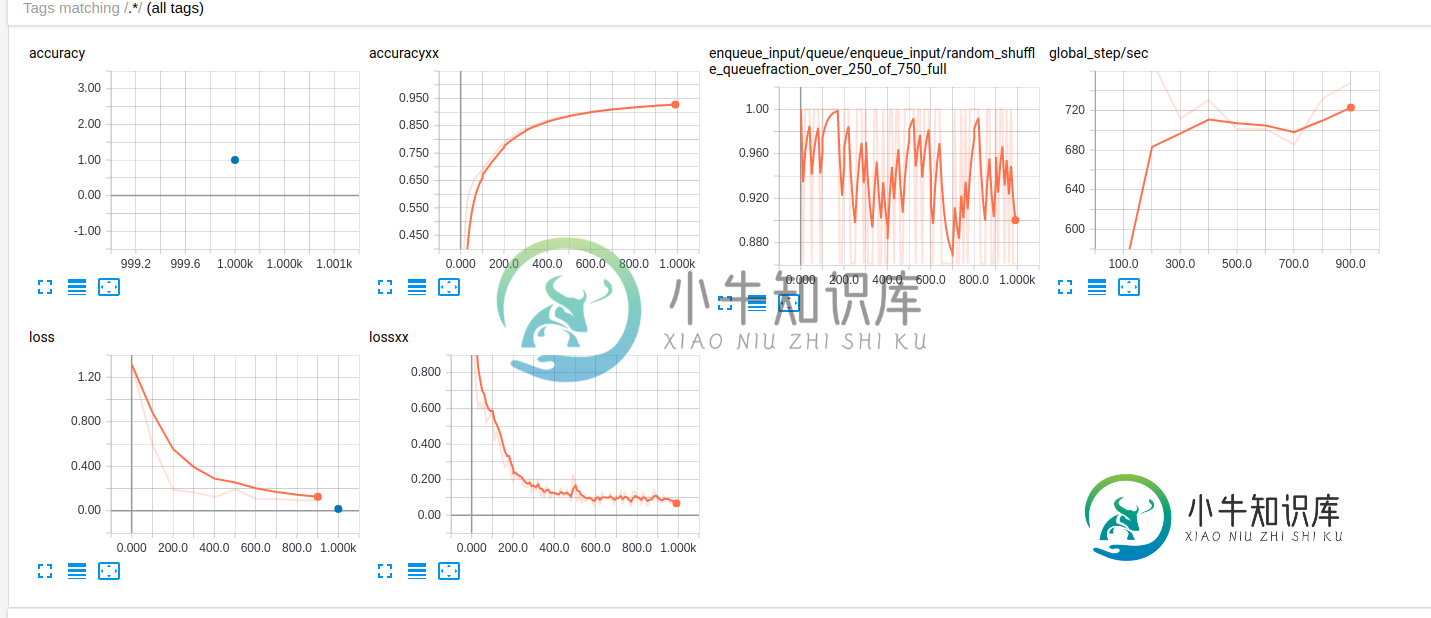

在Tensorflow估计器中,如何获得列车损失并评估每个全局步骤的损失?我每一步都能得到训练损失。但我确实想在tensorboard中的图'lossxx'中添加评估损失。怎么做?

-

Tensorflow:噪声对比估计语言模型

我想将ptb_word_lm.py示例中的损失函数更改为。查看实现: 我想啊 第三个参数(输入)是语言模型的logits, 第四个参数(标签)是语言模型的下一个单词(self.\u targets) num_classes是语音大小 但我不知道前两个参数是什么,权重和偏差。我如何适应到语言模型?谢谢 @亚伦: 谢谢,我尝试了以下方法: 根据这里的文件: > 偏差:形状的张量[num_类]。阶级偏见

-

Python/Tensorflow-我已经训练了卷积神经网络,如何测试它?

我用二进制文件中的以下数据(标签、文件名、数据(像素))训练了一个卷积神经网络(CNN): 每个批次包含所有图像,并运行30个周期: 我的问题是,我想尝试新的图像(test),并想知道返回的类(0,1,2)。在这种情况下我该怎么办?换句话说,我训练了CNN,但如何测试它? 编辑-1 对于评估精度点,我在测试20幅图像时得到以下结果: 当应用获取网络为测试数据点生成的标签时,我得到了以下信息: 为什

-

Tensorflow中的卷积神经网络与自有数据进行预测

我是CNN和Tensorflow的初学者。我试图用自己的数据在tensorflow中实现卷积神经网络进行预测,但我遇到了一些问题。我将Deep MNIST for Experts教程转换为此。对于专家来说,深度分类是一种分类,但我正在尝试回归。另一个问题是,该代码为每一步提供的精度为1。错误的原因是什么?如何将此代码转换为回归? 数据集: 代码: 输出: 我对神经网络和机器学习很陌生,所以请原谅我

-

如何合并不同大小的层以跳过tensorflow/keras中的连接

我在colab中实现了下面的体系结构,用的是tenorflow和keras。我如何连接两个不同形状的不同层,以方便跳过连接。 谢啦 Sai公司

-

使用Tensorflow和Numpy MSE的反向传播不丢弃

我正在尝试创建反向传播,但我不想使用TF中的GradientDescentOptimizer。我只是想更新我自己的权重和偏差。问题是,均方误差或成本并没有接近于零。它只是停留在0.2xxx左右。是因为我的输入是520x1600(是的,每个输入有1600个单位,是的,有520个单位),还是我隐藏层中的神经元数量有问题?我曾尝试使用GradientDescentOptimizer和minimize(c

-

培训期间Tensorflow Slim调试

对于初始模型,我主要遵循这一点。比方说,我想在每个训练循环上打印批次中使用的图像数据,即我想在“微调不同标签集上的模型”中打印每个训练迭代的“images”变量值代码,既然会话实际上是在slim中创建的,我该如何做呢。训练训练功能,因此我无法进行sess。在没有SES的情况下运行([图像])?

-

ConvNet没有改进(Tensorflow)

首先,我想道歉,因为我不允许发布太多代码,因为这是一个大学项目,但我真的被卡住了。 我正在尝试使用CIFAR-10数据集和TensorFlow,使用以下模型来训练ConvNet: 图片:[32,32,3] conv1: 5,5,3,64偏置[64](初始化为0.0) 规范1:depth_radis=4,偏差=1.0,alpha=0.001/9.0,beta=0.75 pool1:ksize=[1,

-

为什么TensorFlow Lite模型在动态范围量化时在延迟上表现出色,而在全整数量化时表现不佳?

我目前正在测试用TensorFlow Lite转换的CNN的推断延迟。我正在测试两个具有相同体系结构的CNN(我正在使用Windows操作系统的笔记本电脑上测试它们): > 第一个模型:使用TFLite优化的TensorFlow模型,并量化其权重(使用Python TFLite API进行转换,并使用TensorFlow.lite.Optimize.DEFAULT进行量化)。它是动态范围量化。 第

-

关于tensorflow lite量化代码、纸张和文档之间不一致的问题

关于tensorflow lite量化代码、纸张和文档之间不一致的问题在google发布的这篇论文(仅用于高效整数算术推理的神经网络量化和训练)中,量化方案描述如下: 哪里 M=S1*S2/S3 S1,S2和S3分别是输入和输出的尺度。 无论是“离线”还是“在线”,S1(和零点Z1)和S2(和零点Z2)都可以很容易地确定。但是S3(和零点Z3)呢?这些参数取决于“实际”输出刻度(即无量化值)。但输出规模在计算之前是未知的。 根据tensorflow文件: 在推理时,

-

TensorFlow Lite C用于推理的API示例

我正在尝试让TensorFlow Lite示例在带有ARM Cortex-A72处理器的机器上运行。不幸的是,由于缺乏关于如何使用C API的示例,我无法部署测试模型。我将努力解释我迄今为止所取得的成就。 创建tflite模型 我创建了一个简单的线性回归模型并对其进行了转换,它应该近似于函数。我从一些教程中得到了这个代码片段,但是我再也找不到了。 这将创建一个名为的二进制文件,我应该能够加载它。