《kafka》专题

-

Kafka Connect确保订购

我想使用Mongo变更流,使用kafka Connect将变更事件从mongoDB推送到kafka Topic中。好消息是: > Kafka在分区内维持排序。 Mongo使用全局时钟维护排序。 但是,中间呢?kafka connect怎么样?它维持订购吗?这种订购是如何运作的?我找不到他们说Kafka维持秩序的地方。 这是一个场景: 在Mongo中-更新用户Bob以获得授权 在Mongo中-将用户

-

可以kafka连接-mongo源作为集群运行(max.tasks>1)

我使用的是kafka connect支持的以下mongo源代码。我发现mongo源代码的一个配置(从这里)是tasks.max。 这意味着我可以提供连接器tasks.max这是 如果它将创建多个连接器来侦听mongoDb更改流,那么我将最终得到重复的消息。那么,mongo真的具有并行性并作为集群工作吗?如果它有超过1个tasks.max?

-

覆盖架构.在 kafka-connect 连接器中启用

我有一个安装了多个连接器的分布式Kafka Connect (6.x)集群。键和值转换器设置为< code > org . Apache . Kafka . connect . JSON . JSON converter 。对于其中一个连接器(S3接收器),我需要使用没有模式的事件,因此在集群配置中将schemas.enable属性设置为False:< code > key . converter

-

融合云 Kafka - 审核日志群集:接收器连接器

对于托管在 Confluent Cloud 中的 Kafka 集群,会创建一个审核日志集群。似乎可以将接收器连接器挂接到此群集,并从“汇合审核日志事件”主题中排出事件。 但是,当我运行连接器执行相同操作时,我遇到了以下错误。 在我的connect-distributed.properties文件中,我的设置如下: 需要授予哪些额外的权限,以便连接器可以在集群中创建所需的主题?connect-dis

-

一个Kafka经纪人连接多个动物园管理员

我是Kafka的新手,动物园管理员和Storm。我我们的环境,我们有一个Kafka代理连接到多个动物园管理员。让生产者将消息发送到特定主题并在一个代理上将分区到多个动物园管理员与多个代理分配给多个动物园管理员相比是否有优势?

-

Strimzi 0.14:Kafka代理身份验证失败

我尝试在 Kubernetes 集群中使用 Strimzi (0.14) 构建一个 Kafka 集群。 我使用strimzi附带的示例,即examples/kafka/kafka-persistent.yaml。 这个yaml文件看起来像这样: 动物园管理员和Kafka经纪人都被抚养长大 然而,我在kafka代理日志中看到了错误: 有人知道如何解决这个问题吗?

-

Kafka connect -无法连接到本地主机端口8083:连接被拒绝

Kafka connect -无法连接到本地主机端口8083:连接被拒绝我有一个依赖于Kafka服务的应用程序。 对于Kafka connect,我在运行Kafka connect的kubernetes pod的Linux VM上尝试<code>curl localhost:8083</code>时遇到错误。 给出: 重建网址至: 本地主机:8083/ 正在尝试 127.0.0.1... 连接到 127.0.0.1 端口 8083 失败:连接被拒绝 无法连接到本地主机

-

由于自动缩减/删除 pod,Kafka 中的重复消息消耗

出身背景 我们有一个简单的生产者/消费者风格的应用程序,Kafka作为消息代理,消费者流程作为Kubernetes pods运行。我们定义了两个话题,即话题内话题和话题外话题。属于同一个消费者组的一组消费者pod从主题内读取消息,执行一些工作,并最终在工作完成后将相同的消息(密钥)写出到主题外。 问题描述 我们注意到,在 Kubernetes pod 中运行的消费者向外主题写出了重复的消息。换个说

-

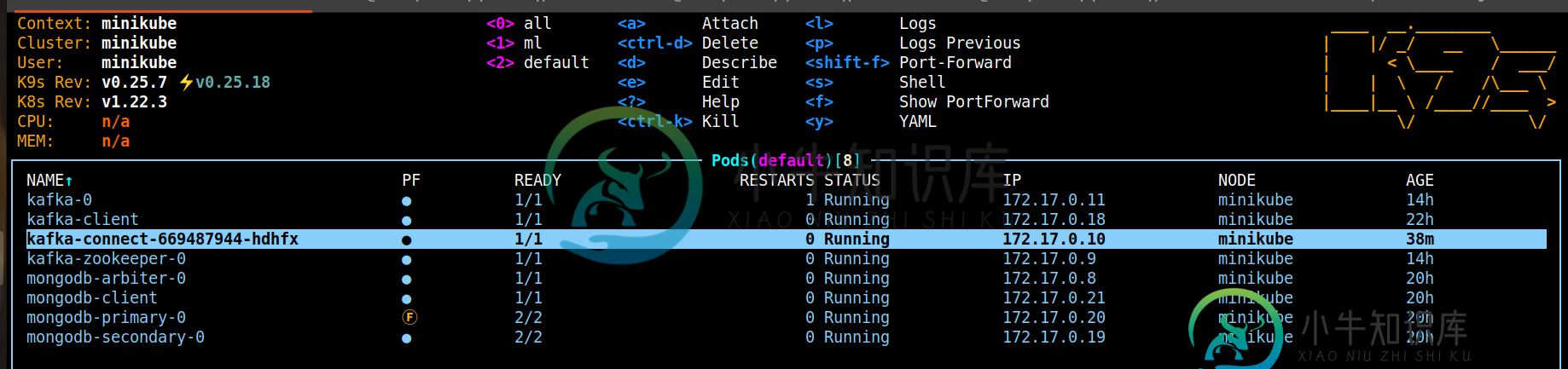

Kafka Mongo on kubernetes(minikube)(Mongo作为Kafka NOT Working的来源)与bitnami/Kafka

Kafka Mongo on kubernetes(minikube)(Mongo作为Kafka NOT Working的来源)与bitnami/Kafka哪个图表:图表/比特纳米/Kafka/https://github.com/bitnami/charts/tree/master/bitnami/kafka 描述我正在遵循的教程bug使用Apache Kafka和MongoDB在库伯内特斯上构建可扩展的容错消息群集 为了解决外部署问题,我遵循了外部署不呈现留档#5649中的示例。问题已解决,我的工作配置如下: Dockerfile文件 然后我跑了

-

Kafka connect-分布式模式容错不起作用

我用3台EC2机器创建了kafka connect集群,并在每台机器上启动了3个连接器(debezium-postgres source ),从postgres source中读取一组不同的表。在其中一台机器上,我还启动了s3 sink连接器。因此,来自postgres的已更改数据正通过源连接器(3)移动到kafka broker,S3接收器连接器使用这些消息并将它们推送到S3桶。< br >群集

-

从Kafka到JMS的骆驼路线不工作(JMS->Kafka->JMS)

当从JMS向Kafka发送消息时,路由运行良好。

-

Kafka消费者与Spark-Kafka-Consumer的区别

我有一个Kafka主题,我正在通过Kafka生产者发送数据。现在在消费者方面,我有两个选择。 null

-

骆驼-Kafka动物园管理员例外

如果我部署war,我将得到以下异常: 原因:org.apache.camel.resolveEndpointFailedException:无法解析endpoint:kafka://localhost:9092?serializerClass=kafka.serializer.stringencoder&topic=checking&zookeePerhost=localhost&zookeePe

-

如何使用camel创建kafka主题分区

null camel-kafka中是否有任何配置,我们可以使用它来增加kafka主题分区计数?

-

Camel-Kafka ConsumerCount从定义值降至1(默认值)

CamelConsumer配置 我从日志中看到,当使用者启动时,有15个使用者线程(假设在1个节点上),这是很好的配置。 如果服务器不可用时由于网络问题或任何其他情况而停止响应。所有的kafka消费者都开始退订,这又是一个预期的行为(到目前为止还不错)