《kafka》专题

-

汇流复制器无法在目标kafka服务器上复制数据

我已经在两个不同的主机上安装了融合Kafka,并尝试让融合复制器工作。我已经完全遵循了本教程中提到的内容。 当我启动复制器时,我没有看到任何错误,这是我看到的日志: WorkerSourceTask { id = Replicator-source-0 }正在提交偏移量(org . Apache . Kafka . connect . runtime . WorkerSourceTask:397)

-

Kafka 连接器弹性搜索不消耗主题

这是我的kafka连接器属性 这是我用来创建Elasticsearch水槽的POST主体 我遇到的问题是,有时这个接收器会工作并将数据发送到Elasticsearch并显示 〔2020-09-15 20:27:05904〕INFO WorkerLinkTask{id=test-distributed-connector-0}使用序列号1异步提交偏移。。。。。。。 但大多数时候,它只会卡住并重复这一

-

kafka连接重启失败的任务

我们有一个从rdbms读取并放入kafka的源连接器。它使用带有avro模式的模式注册表。我分别在kafka连接日志和模式注册表日志中发现以下异常。 1. 0 因此,基本上模式注册表在注册模式之前将偏移量移动到最新,然后超时500毫秒。 我的问题是这个。 > 我怎样才能找到为什么它不能从kafka读取? 源连接器任务是否重新启动或轮询一个连接器的失败任务的数据?因为在日志的后面部分,我看到了这一点

-

融合kafka jdbc连接查询模式

我正在使用合流kafka connect jdbc源将mysql表中的记录推送到我的kafka主题,但似乎日期列被转换为纪元时间。 这是我的配置: kafka主题中的输出: 我也在类似于“select from_unixtime(updated _ on)from temp”的查询中尝试了from _ unixtime(),但是那不行。 有没有办法推到YYYY-MM-DD HH:MM:SS格式的K

-

运行 kafka 连接分布式模式时已在使用的地址

我按问题推出了合流套件”。/bin/合流启动”命令。然后我用kafka connect把kafka的数据汇到mysql。 我可以通过执行以下命令在独立模式下很好地运行 kafka 连接: ./bin/connect-standalone ./etc/schema-registry/connect-avro-standalone.properties ./etc/kafka-connect-jdbc

-

Kafka connect confluent jdbc 不控制 MSSQL 数据库中的会话池

我正在使用Kafka连接和融合jdbc。将源连接器与Mssql集成,几天前操作区警告我们数据库中有大量处于“睡眠”状态的会话。我需要控制这些会话,但显然连接器(融合jdbc)的配置中没有这些属性。 你有什么想法来纠正这个问题吗?

-

Kafka Connect启动,但什么都没有发生

我正在编写一个Kafka source connector,它基于一个我用于音频文件的工作生成器。连接器启动了,但是没有任何反应,没有错误,没有数据,我不确定这是编码问题还是配置问题。 连接器应该读取整个目录,并将文件读取为字节数组。 配置类: 源连接器类 源任务类 版本Class Connector.properties Connect-standalone.properties 错误:

-

Kafka s3 json连接器

我尝试使用最新的kafka (confluent-platform-2.11)连接将Json放到s3上。我在quickstart-s3.properties文件中设置format . class = io . confluent . connect . S3 . format . JSON . JSON format 和负载连接器: 然后我给Kafka发了一行: ~$ Kafka-控制台-生产者

-

Kafka Connect -删除带有配置的连接器?

我知道如何删除Kafka连接器,如此处所述 Kafka Connect - 如何删除连接器 但我不确定它是否也删除/擦除特定的连接器相关的配置,偏移量和状态从*。sorage.topic该工作者? 例如:假设我删除了一个连接器名为“connector-abc-1.0.0”的连接器,Kafka connect worker以下面的配置启动。 现在,在该连接器的DELETE调用之后,它是否会删除该特定

-

如何开始在开源Apache kafka中运行kafka连接器?

我试图使用开源的apache kafka运行Kafka连接器(不是使用confluent) 这很好,但这种方式只启动Kafka连接工作程序,我如何加载社区连接器? 我尝试了上面的两个命令,都没有给出错误,但无法加载连接器模块。另一个问题,我键入什么命令来检查连接器的状态?

-

Kafka JDBC源连接器:从列值创建主题

我有一个微服务,它使用 OracleDB 在表中发布系统更改。表包含一个,其中包含事件类型的名称。 JDBC Source Kafka Connect可能会接受表更改,并在KAFKA-TOPIC中使用列的值发布它们? 这是我的源代码kafka连接器配置:

-

使用Kafka Connect在MySQL数据库之间同步数据

我正在尝试使用基于Kafka Connect的Confluent在几个MySQL数据库之间同步数据。我在源连接器配置中使用了“批量”作为模式,因为主键类型是 varchar,所以我无法使用递增模式。它工作正常,但我遇到了两个问题: 似乎它无法同步删除,当源数据库中的数据被删除时,接收器数据库没有任何变化。数据仍存在于接收器数据库中。 同步数据需要相当长的时间。就我而言,同步具有 2~4k 行的表大

-

设置kafka-link以从远程代理获取数据

我正在尝试设置Kafka connect sink连接器。Kafka connect是Kafka connect worker(confluent-3 . 2 . 0)的一部分。我有一个Kafka broker (confluent-3.2.0)在机器a上运行。我想在另一台机器B上设置Kafka-connect-sink连接器来使用消息,使用一个定制的Kafka-connect-sink连接器ja

-

将jar添加到合流Docker中的通用Kafka Connect类路径

我正在使用Kafka connect v4.1.1的合流docker,并希望添加一个带有特定log4j appenders的jar。< br >通过连接器隔离类路径,我不确定将该jar放在汇合停靠器中的何处,因为它由父kafka connect本身使用,而不是由连接器使用。< br> 预先感谢您的帮助!

-

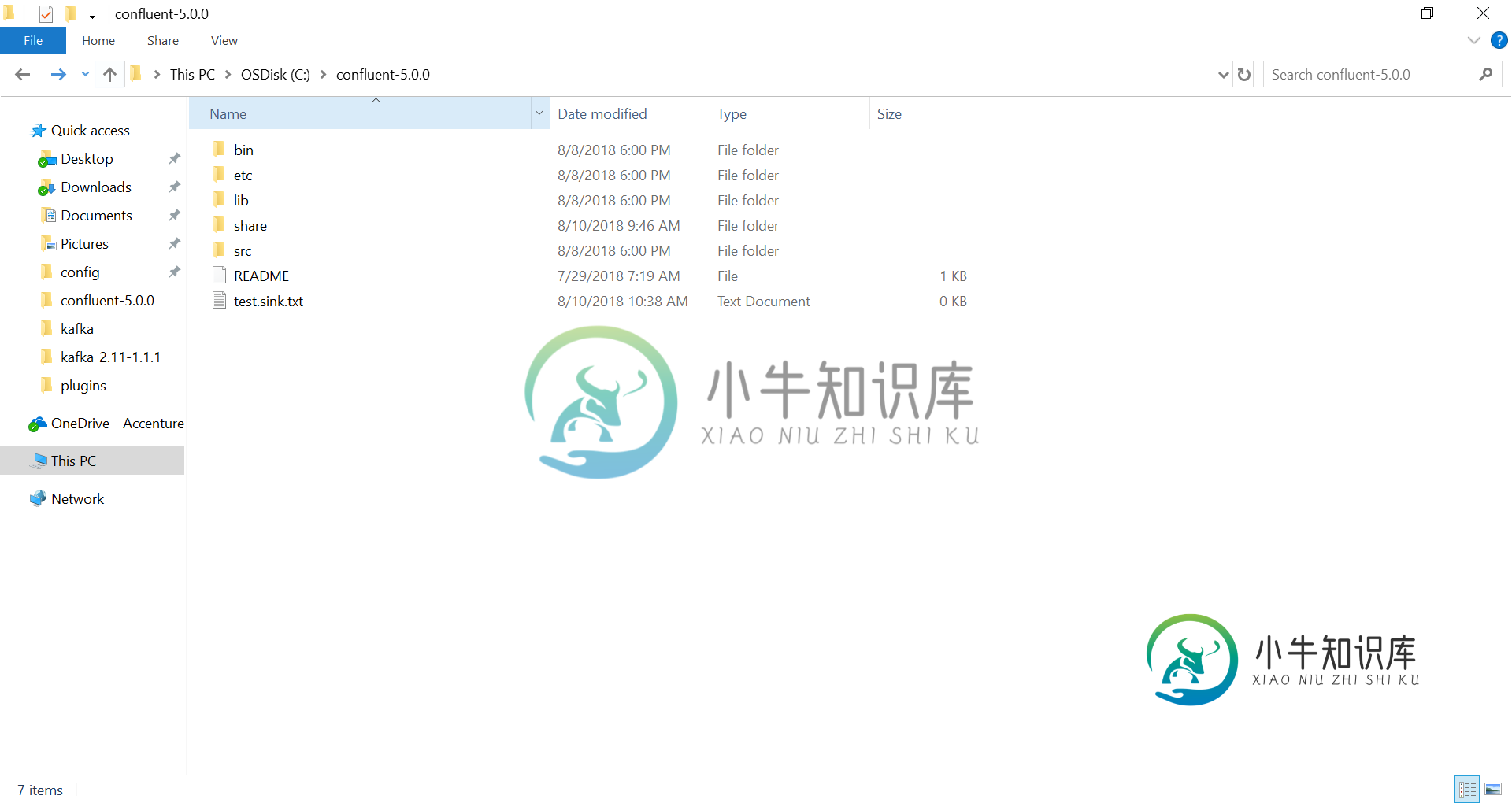

Kafka Connect添加MySqlConntor失败

Kafka Connect添加MySqlConntor失败我需要某人的帮助。 我遵循教程使用Kafka Connect和Debezium将数据从MySQL流式传输到Kafka,但是使用Debezium MySQL连接器将MySQL连接到Kafka服务器时遇到了麻烦。 这是我的设置和其他信息。 操作系统:视窗10。 Kafka连接:合流5.0。 MySQL连接器:0.8.1最终版本。 我保存文件 我添加插件路径 当我尝试连接Kafka Connect时,它