《stream》专题

-

Spring Cloud Streams应用程序抛出嵌套异常是java.lang.域模型类的ClassCastExc的

嗨,我正在尝试最新的 Kafka Spring云流框架。但是,对于字符串和双精度,它工作正常,但是当我尝试发送Java POJO类时,它会抛出以下异常。 我已经尝试了各种序列化和反序列化配置,但似乎没有任何效果。我能够以json形式从供应商处生成消息,但由于错误,消费者无法处理它。 对这个问题的任何建议将不胜感激。谢谢 以下是POM.xml 下面是应用程序 应用程序.yml

-

Spring Cloud Stream -在broker中通知和处理错误

Spring Cloud Stream -在broker中通知和处理错误我对开发带有消息传递的分布式应用程序相当陌生,尤其是对Spring Cloud Stream。我目前想知道如何在代理端处理错误的最佳实践。 消费者方面 对于消费,我们定义了多个类型 的。这些配置如下所示: 这部分工作得很好——当启动应用程序时,交换“输入A”和“输入B”以及具有相应绑定的队列“输入A”。$默认值”和“输入B”。$默认值”在RabbitMQ中自动创建。此外,如果发生错误(例如队列突然

-

使用自定义MessageConverter创建消息时出现StreamBridge问题

我们正在将我们的事件系统迁移到函数式编程模型。我们遵循了下一个“指南”,它对消费者非常有效,但使用StreamBridge的生产者没有正确创建消息。 我们有下一个错误: 我们正在使用< code > 2021 . 0 . 0 spring-cloud版本。 通过简单的配置: 这是我们的自定义,它用于我们所有的微服务,因此,保持消息的格式很重要: 我们还使用< code>StreamBridge来生

-

Mono与Spring Cloud Stream

我在尝试将Reactor的Mono与Spring Cloud Stream一起使用时遇到了一个问题,无法真正弄清楚发生了什么。 想象一下,我有一个这样的听众: 因此,它基本上是将一个格式如下的url扩展成这样 < code > http://www . example . com/page/1 它按预期工作,但是当我尝试这样做时: 其中pageNumber是

-

不推荐使用EnableB的类型,不推荐使用StreamListener类型-Spring Cloud Stream

我正在使用Spring Boot 2.4.2版,并使用进行Spring Cloud Stream和Spring集成。 RabbitmqReceiverApplication.java 还有什么替代方案?那么如何重构上面的代码呢?随着速度的加快,很多事情正在发生,很难理解什么来了,什么走了?

-

是否可以使用 Spring-Cloud-Streams Kafka-Streams 创建一个多绑定器绑定,以便从集群 A 流式传输并生成到集群 B

我想创建一个带有Spring-Cloud-Streams的Kafka-Streams应用程序,该应用程序集成了2个不同的Kafka集群/设置。我尝试使用文档中提到的多绑定器配置来实现它,类似于以下示例:https://github.com/spring-cloud/spring-cloud-stream-samples/tree/main/multi-binder-samples 给定如下简单函数

-

使用默认架构注册表客户端而不是Avro架构注册表客户端解决Spring Cloud Stream问题

我们正在使用Kafka和Spring Cloud Stream,我们需要连接到Spring Boot组件中的Confluent Schema Registry,请参阅https://github.com/donalthurley/KafkaConsumeScsAndConfluent. 我们添加了以下配置来创建所需的 ConfluentSchemaRegistryClient bean see h

-

突然间,Kafka Streams(scala)应用程序陷入了重新加入的过程(没有明显的原因),并且从未完成它。

我正在摆弄K8s处理的Kafka Streams。到目前为止,它或多或少进展顺利,但在测试环境中观察到奇怪的行为: [消费者clientId=dbe-livestream-kafka-streams-77185a88-71a7-40cd-8774-aeecc04054e1-StreamThread-1-Consumer,groupId=dbe-livestream-kafka流]我们收到了一个任务

-

如何确定主题已被Kafka Stream应用程序从第一个偏移量到最后一个偏移量从Java应用程序完全阅读

我在Kafka Streams中需要一些帮助。我已经启动了一个Kafka流应用程序,它从第一个偏移量流式传输一个主题。主题的数据非常庞大,所以我想在我的应用程序中实现一种机制,使用Kafka流,这样我就可以在主题被完全读取到最后一个偏移量时得到通知。 我已经阅读了Kafka Streams 2.8.0 api,我找到了一个api方法i-e allLocalStore分区延迟,它将存储名称映射返回到

-

Kafka Streams应用程序在一段时间没有读取消息后停止工作

我注意到我的Kafka Streams应用程序在一段时间没有读取来自Kafka主题的新消息时停止工作。这是我第三次看到这种情况发生。 自5天以来,没有向主题发送任何消息。我的Kafka Streams应用程序也托管了一个spark java Web服务器,它仍然具有响应能力。然而,Kafka Streams不再阅读我向Kafka主题发出的消息。当我重新启动应用程序时,所有消息都将从代理获取。 如何

-

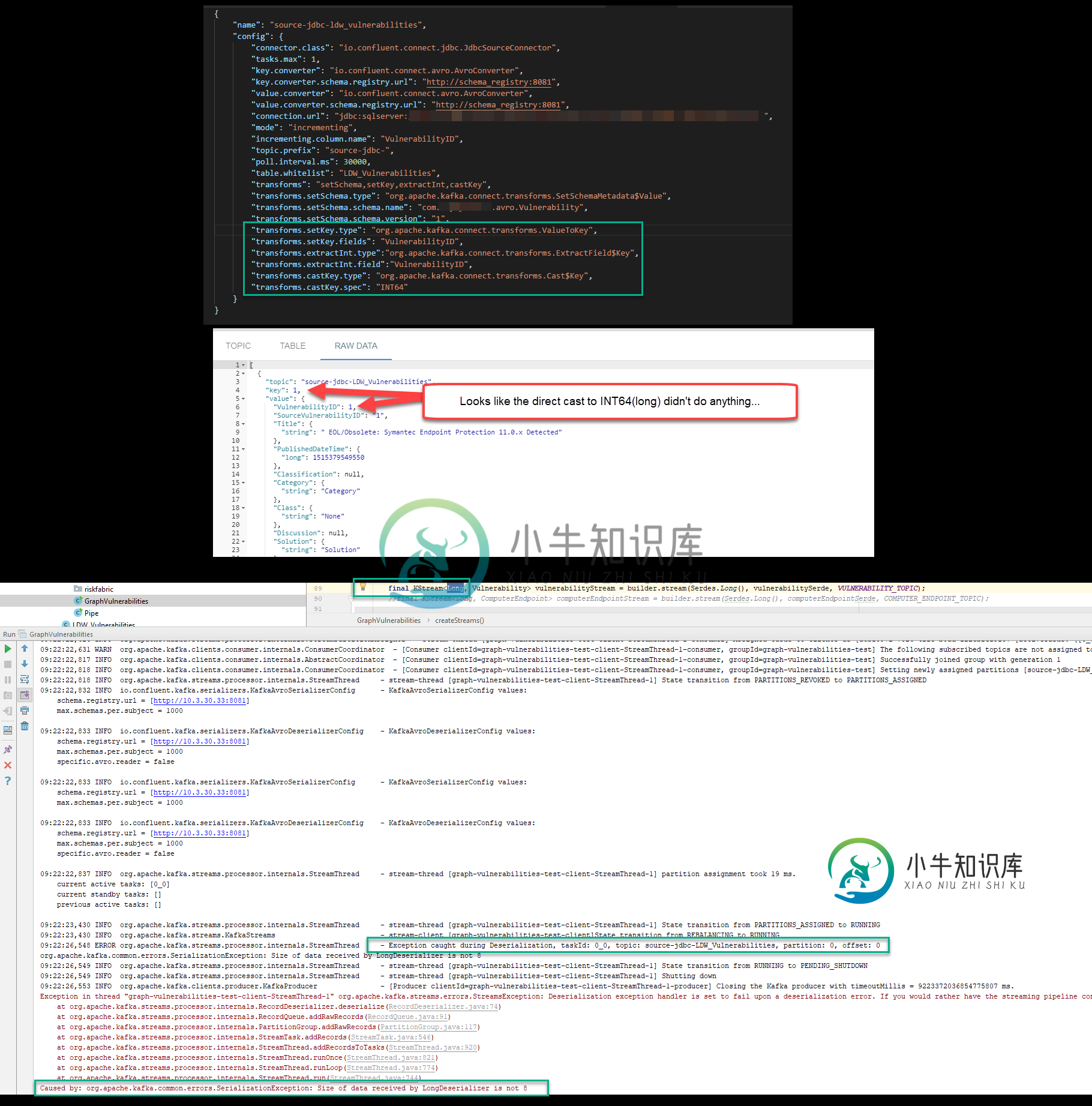

Kafka Streams JDBC源长期不兼容

Kafka Streams JDBC源长期不兼容问题:在设置一个 Kafka 管道后,该管道使用 Kafka Connect JDBC 源和 Avro 序列化程序和反序列化程序将数据拉入,一旦我尝试使用 Kafka Streams Java 应用程序将该数据读入 KStream,就会收到以下错误。 org.apache.kafka命令错误。SerializationException:LongDeserializer接收的数据大小不是8 我试图

-

Kafka Streams:获取时间窗口中的事件计数

我有数据流 但我错了

-

Java 8 stream max()函数参数类型比较器与可比

我知道我误解了一些事情,但我现在知道是什么了。谁能解释一下吗?

-

Java 8 Stream的最大值(Math::max)[重复]

代码如下: 返回值是列表中的最小值-15。但是当我将max()更改为min()时,它会返回max值。为什么?

-

严格的标准:非静态方法 StreamComment::getCommentsHTML() 不应静态调用,假设$this来自不兼容的上下文

我正在使用Offiria(基于joomla的社交网络脚本),当我单击链接“显示所有评论”以查看链接下所有已发布的评论时,我在第一条评论上方收到以下错误。该功能可以工作,因此所有评论都会扩展,我可以看到所有评论,但错误也在那里。 严格标准:非静态方法StreamComment::getCommentsHTML()不应该被静态调用,假设$this来自第31行的C:\节目文件\放大器\www\offir