《大数据》专题

-

在MySql INSERT命令中写入大量数据哪个好?

我有大约400K的数据,也许更多(以sql格式),并将它插入到mysql数据库。哪一个性能更好,在sql文件中写sql命令插入数据: > 对每个数据重复此命令,直到400k 在表(col1、col2、coln)中插入值(val1、val2、valn)、(val1、val2、valn)、(val1、val2、valn)、.....[直到100个数据] 在表(col1,col2,coln)中插入值(v

-

图表-具有不同大小数据集的折线图

我正在开发一个应用程序,它将生成一些图表,我正在使用chartjs来绘制它们。 我面临的问题是:图表将用动态数据生成。应用程序最多可以生成9个数据集,很少会有相同的大小。当数据集大小不匹配时,如何使图表提前或填充值? 我在stackoverflow甚至在chartjs github页面上看到了一些例子,但它们对我不起作用。 这是我目前所拥有的一个示例:https://jsfidle.net/cam

-

从Python中的数据帧的行中获取最大值

问题内容: 这是我的数据框df 我正在尝试从数据帧的每一行中获取最大值,我期望这样的输出 这就是我尝试过的 我没有得到正确的输出,任何帮助将不胜感激。谢谢 问题答案: 使用有: 如果需要新列:

-

mysql大批量插入数据的4种方法示例

本文向大家介绍mysql大批量插入数据的4种方法示例,包括了mysql大批量插入数据的4种方法示例的使用技巧和注意事项,需要的朋友参考一下 前言 本文主要给大家介绍了关于mysql大批量插入数据的4种方法,分享出来供大家参考学习,下面话不多说了,来一起看看详细的介绍吧 方法一:循环插入 这个也是最普通的方式,如果数据量不是很大,可以使用,但是每次都要消耗连接数据库的资源。 大致思维如下 (我这里写

-

浅谈用Python实现一个大数据搜索引擎

浅谈用Python实现一个大数据搜索引擎本文向大家介绍浅谈用Python实现一个大数据搜索引擎,包括了浅谈用Python实现一个大数据搜索引擎的使用技巧和注意事项,需要的朋友参考一下 搜索是大数据领域里常见的需求。Splunk和ELK分别是该领域在非开源和开源领域里的领导者。本文利用很少的Python代码实现了一个基本的数据搜索功能,试图让大家理解大数据搜索的基本原理。 布隆过滤器 (Bloom Filter) 第一步我们先要实现一个布

-

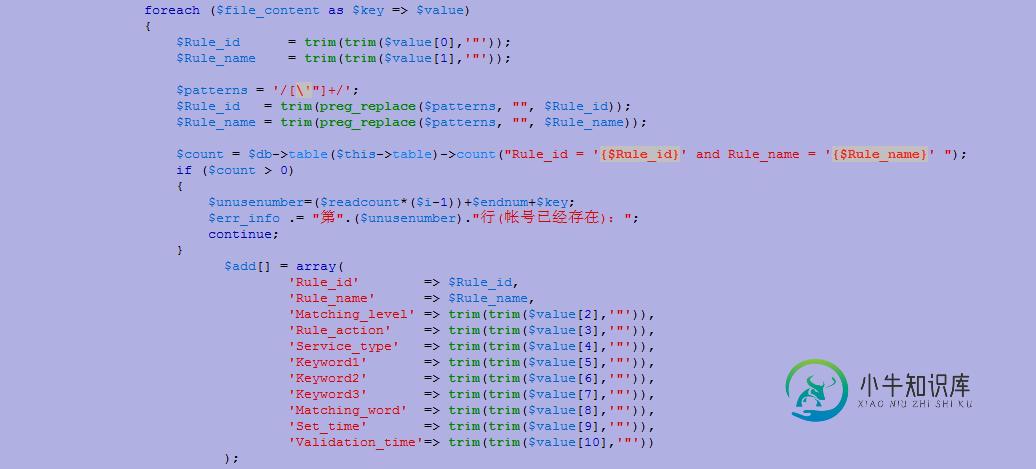

php+ajax导入大数据时产生的问题处理

php+ajax导入大数据时产生的问题处理本文向大家介绍php+ajax导入大数据时产生的问题处理,包括了php+ajax导入大数据时产生的问题处理的使用技巧和注意事项,需要的朋友参考一下 遇到的问题就从先到后的一一说吧。 问题1 按照我最初的想法,先上传文件再读取文件。这里问题就来了,当文件较大的时候上传较慢,导致客户看到的操作一直处于等待状态,不人性化。 处理办法:我是这样做的,大神有更好的办法,求介绍。我先把文件上传上去,然后把文件

-

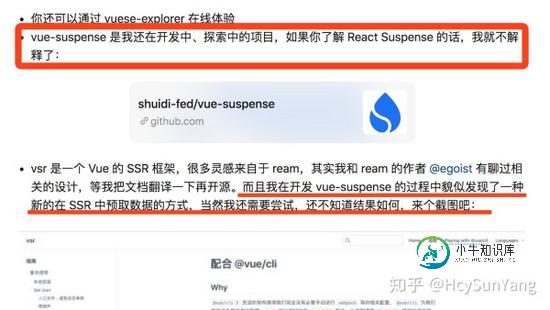

更强大的vue ssr实现预取数据的方式

更强大的vue ssr实现预取数据的方式本文向大家介绍更强大的vue ssr实现预取数据的方式,包括了更强大的vue ssr实现预取数据的方式的使用技巧和注意事项,需要的朋友参考一下 我在前几天的一篇文章中吹了两个牛皮,截图为证: 现在可以松口气的说,这两个牛皮都实现了,不过 vue-suspense 改名了,叫做 vue-async-manager 了,他能帮你管理 Vue 应用中的异步组件的加载和 API 的调用,提供了与 Reac

-

基于列的最大值删除熊猫数据帧行

我有这样一个数据帧: 我如何摆脱第四行,因为它有sq_resid的最大值?注意:最大值将从一个数据集更改到另一个数据集,所以仅仅删除第4行是不够的。 我已经尝试了一些方法,比如我可以删除像下面这样留下数据帧的最大值,但是无法删除整行。

-

Hadoop对数据流不太大的系统有开销吗?

我计划编写一个批处理分布式计算系统,它将使用大约10-20台计算机。系统某些部分的数据流约为50GB,其他部分的数据流约为1GB。 我正在考虑使用Hadoop。可扩展性并不重要,但我真的很喜欢Hadoop framewok提供的容错和推测运行功能。MPI或gearman等框架似乎不提供这样的机制,我将不得不自己实现它们。 然而,我有一些疑问,因为它似乎是针对更大的数据量和可能更多的计算机进行优化的

-

将大写应用于Python中Pandas数据框中的列

本文向大家介绍将大写应用于Python中Pandas数据框中的列,包括了将大写应用于Python中Pandas数据框中的列的使用技巧和注意事项,需要的朋友参考一下 在本教程中,我们将看到如何在DataFrame中使名称列变为大写。让我们看看实现目标的不同方法。 示例 我们可以使用upper()方法将其大写,从而为DataFrame分配一列。 让我们看一下代码。 输出结果 如果运行上面的程序,您将得

-

Spring Boot通过RESTendpoint将大型数据库导出到csv

我需要构建一个Spring Boot应用程序,它公开一个RESTendpoint,以将一个巨大的数据库表导出为具有不同过滤器参数的CSV文件。我正试图找到一个有效的解决这个问题的办法。 目前,我使用spring数据jpa查询数据库表,该表返回POJO列表。然后使用Apache Commons CSV将此列表作为CSV文件写入HttpServletResponse。这种方法有几个问题。首先,它将所有

-

如何使用Spring MySQL和RowCallbackHandler管理大型数据集

问题内容: 我正在尝试使用Spring和JdbcTemplate遍历MySQL中表的每一行。如果我没记错的话,它应该很简单: 我收到一个OutOfMemoryError,因为它试图读取整个内容。有任何想法吗? 问题答案: 在 javadoc中已经指出: 向JDBC驱动程序 提示 应从数据库中获取的行数 驱动程序实际上可以自由地应用或忽略提示。一些驱动程序忽略它,一些驱动程序直接应用它,一些驱动程序

-

Android:通过BLE发送大于20个字节的数据

问题内容: 通过连接到外部BLE设备,我最多可以发送20个字节的数据。如何发送大于20个字节的数据。我已经读到我们必须将数据分段或将特征拆分为所需的部分。如果我假设我的数据是32字节,你能否告诉我我需要在代码中进行的更改才能使其正常工作?以下是我的代码中必需的摘录: 这是我用于发送数据的代码。在以下onclick事件中使用“发送”功能。 当大于20个字节时,则仅接收前20个字节。如何纠正呢? 为了

-

特别大的数据量,如何实现查找,排序?

本文向大家介绍特别大的数据量,如何实现查找,排序?相关面试题,主要包含被问及特别大的数据量,如何实现查找,排序?时的应答技巧和注意事项,需要的朋友参考一下 参考回答: 1)、位图法 位图法是我在编程珠玑上看到的一种比较新颖的方法,思路比较巧妙效率也很高。 使用场景举例:对2G的数据量进行排序,这是基本要求。 数据:1、每个数据不大于8亿;2、数据类型位int;3、每个数据最多重复一次。 内存:最多

-

GCP数据流Kafka(作为Azure事件中心)->大查询

我有一个启用了Kafka的Azure Event Hub,我正试图从Google Cloud的数据流服务连接到它,以将数据流式传输到Google Big Query。我成功地可以使用Kafka CLI与Azure Event Hub交谈。但是,使用GCP,5分钟后,我在GCP数据流作业窗口中收到超时错误。 Azure EH已启用Kafka- 为了设置启用Kafka的事件中心,我遵循此GitHub页