《百度笔试机器学习》专题

-

Python 机器学习

Python 机器学习机器学习是一门研究如何使用计算机模拟人类行为,以获取新的知识与技能的学科。它是人工智能的核心,同时也是处理大数据的关键技术之一。机器学习的主要目标是自动地从数据中发现价值的模式,亦即将原始信息自动转换为人们可以加以利用的知识。

-

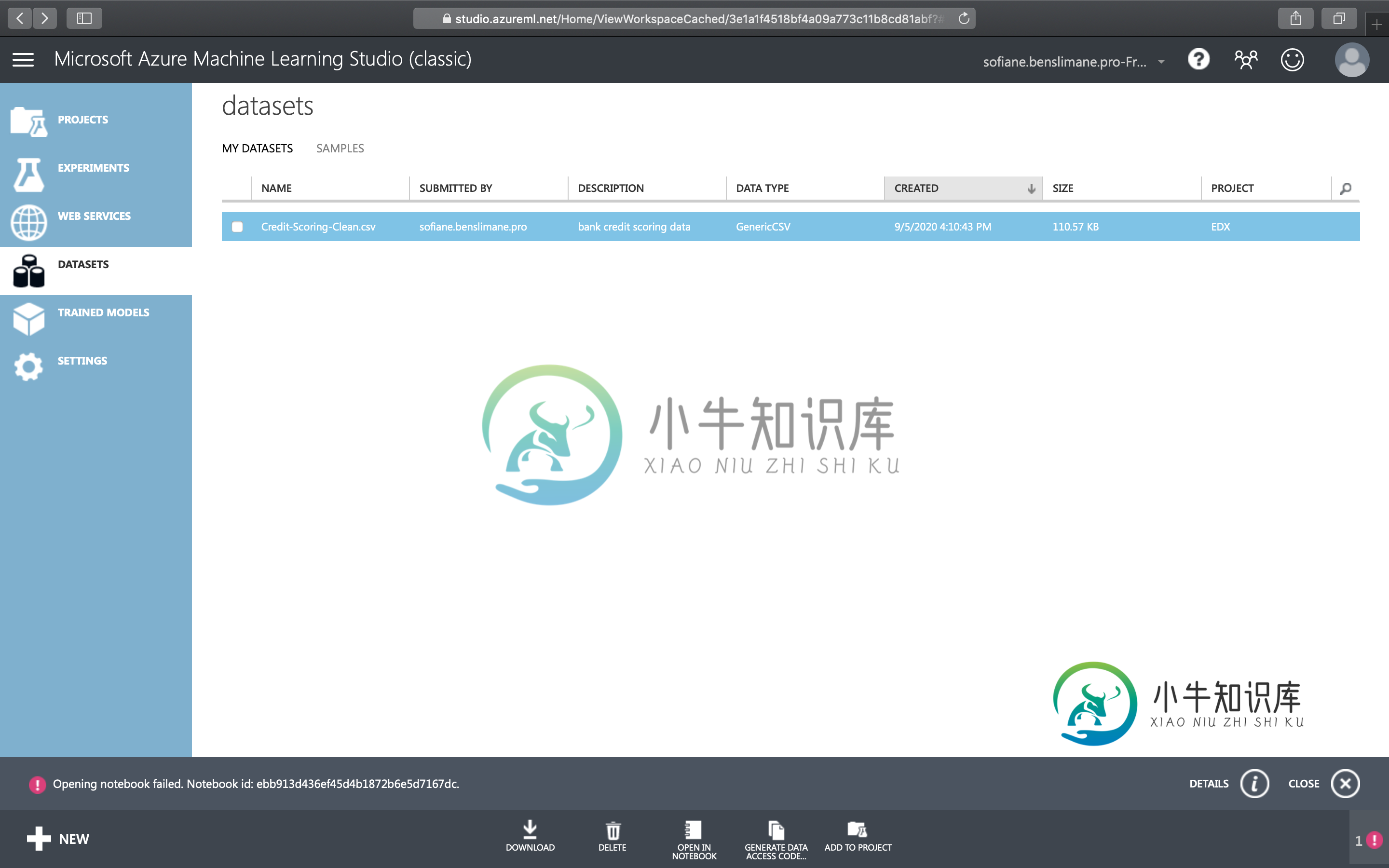

在Azure机器学习工作室打开笔记本

在Azure机器学习工作室打开笔记本我是Azure机器学习的新手。 我试图从Azure机器学习工作室经典中的数据集中打开一个笔记本。 但我得到了这个错误: 打开笔记本失败。笔记本id:ebb913d436ef45d4b1872b6e5d7167dc。 正如你在图片上看到的,我甚至不可能访问左侧菜单中的所有笔记本。

-

机器学习:集成学习

“三个臭皮匠顶个诸葛亮”。集成学习就是利用了这样的思想,通过把多分类器组合在一起的方式,构建出一个强分类器;这些被组合的分类器被称为基分类器。事实上,随机森林就属于集成学习的范畴。通常,集成学习具有更强的泛化能力,大量弱分类器的存在降低了分类错误率,也对于数据的噪声有很好的包容性。

-

机器学习面试题与解析1

机器学习面试题与解析1面试高频题1: 题目:了解决策树吗 答案解析: 决策树是一种机器学习的方法。决策树的生成算法有ID3, C4.5和C5.0等。决策树是一种树形结构,其中每个内部节点表示一个属性上的判断,每个分支代表一个判断结果的输出,最后每个叶节点代表一种分类结果。 决策树的构造过程: 决策树的构造过程一般分为3个部分,分别是特征选择、决策树生产和决策树裁剪。 (1)特征选择: 特征选择表示从众多的特征中选择一个

-

机器学习面试题与解析2

机器学习面试题与解析2面试高频题11: 题目:L1、L2的原理?两者区别? 答案解析: 原理: L1正则是基于L1范数和项,即参数的绝对值和参数的积项;L2正则是基于L2范数,即在目标函数后面加上参数的平方和与参数的积项。 区别: 1.鲁棒性:L1对异常点不敏感,L2对异常点有放大效果。 2.稳定性:对于新数据的调整,L1变动很大,L2整体变动不大。 答案解析 数据分析只需要简单知道原理和区别就行,公式推导不需要,面试

-

百度笔试,春招3/7,客户端卷讨论

百度笔试,春招3/7,客户端卷讨论两题都是题目看起来贼复杂但是,看明白了很简单的那种。但是第二题死活有个用例没过思路很明显就是一个二分查找。不知道哪里没考虑清楚 题目:小明是一名魔法师,有一天他在和一个怪物战斗,小明会n种法术,释放第i种法术需要法力为si,且在整场战斗中只能释放一次,在第一个回合他可以释放0、1或者2种法术,释放2种法术总共消耗的法力值为这两种法术各自消耗的法力值之和,一回合消耗的法力值不能超过法力值的上限,且每

-

百度嵌入式软件开发正式批笔试

百度嵌入式软件开发正式批笔试题型:3道编程题 题目1: 小红拿到了一个字符串,她想知道有多少个baidu型子串? 所谓baidu型字符串,指的是第一个、第四个字母是辅音,第2、3、5字符是元音,且每个字母都不相同的字符串。 baiduoxiaojiabankanjiaran baidu和duoxi这两个是 输入样例1 baiduoxiaojiabankanjiaran 输出 2 题目2: 小红拿到了一个01串,她每次可以选择

-

梅卡曼德机器人- C++ 笔试

梅卡曼德机器人- C++ 笔试不知道这家公司的内部管理到底是怎么样的,前前后后 3 个hr 给我发了笔试连接,做了 3 次题目一模一样,笔试全选择题,都是 C++ 和 算法的基础题。 eg: 基本类型的精度转换,编译连接,虚拟内存和物理内存,函数参数默认值,内存泄漏,快速排序的最坏情况, 求无序数组的最小最大值元素的比较次数 (1.5 n),查找循环单链表的前驱和后驱节点的复杂度, 后面有几道题是问你继承,构造和析构的输出问题

-

大疆-机器人算法岗笔试

大疆-机器人算法岗笔试8.18笔试,2小时,30道单选,30道不定项选择,1道编程,飞控云台两种试题二选一(选的飞控) 选择题类型包括c/c++编程,考研自控,规划算法,控制算法,概率论,感知,slam算法,一些摄像头,传感器的硬件知识等。 编程题是求最大数字和最小数字之间的字符串,比较简单ac了。 许个愿,希望给个一面机会(不给也无所谓了,已经习惯进入人才库)。

-

这年头机器学习没深度学习不能活了吗

这年头机器学习没深度学习不能活了吗快手一面凉经 算法 我迟到10分钟 面试45分钟 1. 和为k的连续数组 2.AUC 公式,物理意义,GAUC,auc缺点 3.L1 和L2 4. Dropout 训练预测区别 BN在哪些场景下不适用 5.Xgboost特点 6.损失函数评价函数,Huber 7.交叉熵公式 为什么分类用交叉熵不用Mae 8.生成式模型与判别式模型,NLP了解吗(我是做数据挖掘的, 认识不深,说不了解) 9.实习介

-

机器学习:使用Python - 简介Scikit-learn 机器学习

Scikit-learn 套件的安装 目前Scikit-learn同时支持Python 2及 3,安装的方式也非常多种。对于初学者,最建议的方式是直接下载 Anaconda Python (https://www.continuum.io/downloads)。同时支持 Windows / OSX/ Linux 等作业系统。相关数据分析套件如Scipy, Numpy, 及图形绘制库 matplot

-

《机器学习高频面试题详解》1.1:感知机

《机器学习高频面试题详解》1.1:感知机前言 大家好,我是鬼仔。今天带来《机器学习高频面试题详解》专栏的第一章监督学习的第一节:感知机,接下来鬼仔将每周更新1~2篇文章,希望每篇文章能够将一个知识点讲透、讲深,也希望读者能从鬼仔的文章中有所收获。 欢迎大家订阅该专栏,可以先看看专栏介绍。如果对文章内容或者排版有任何意见,可以直接在讨论区提出来,鬼仔一定虚心接受! 一、原理 1. 感知机模型 感知机模型是一个最经典古老的分类方法,现在基本

-

机器学习算法

Index 基本遵从《统计学习方法》一书中的符号表示。 除特别说明,默认w为行向量,x为列向量,以避免在wx 中使用转置符号;但有些公式为了更清晰区分向量与标量,依然会使用^T的上标,注意区分。 输入实例x的特征向量记为: 注意:x_i 和 x^(i) 含义不同,前者表示训练集中第 i 个实例,后者表示特征向量中的第 i 个分量;因此,通常记训练集为: 特征向量用小n表示维数,训练集用大N表示个数

-

机器学习实践

Reference CS229 课程讲义(中文) - Kivy-CN - GitHub 超参数选择 Grid Search 网格搜索 在高维空间中对一定区域进行遍历 Random Search 在高维空间中随机选择若干超参数 相关库(未使用) Hyperopt 用于超参数优化的 Python 库,其内部使用 Parzen 估计器的树来预测哪组超参数可能会得到好的结果。 GitHub - https

-

机器学习基础

偏差与方差 《机器学习》 2.5 偏差与方差 - 周志华 偏差与方差分别是用于衡量一个模型泛化误差的两个方面; 模型的偏差,指的是模型预测的期望值与真实值之间的差; 模型的方差,指的是模型预测的期望值与预测值之间的差平方和; 在监督学习中,模型的泛化误差可分解为偏差、方差与噪声之和。 偏差用于描述模型的拟合能力; 方差用于描述模型的稳定性。 导致偏差和方差的原因 偏差通常是由于我们对学习算法做了错