《自然语言处理NLP实习》专题

-

Junit 在等待和处理异常后断言某些内容

在第一次和第二次调用时抛出的方法: 测试: 你能帮我找到更好的解决办法吗?使用Mockito作为更好的解决方案也是可以接受的。 更好的意思是,如果我能在测试中避免try/catch甚至多次try/catch。在其他语言或jAsutter中,我认为即使在Spring也有这样的语句: 我认为Mockito或JUnit4.x也有类似的情况。 我知道关于 但这只有在我期望一次投掷并且测试结束后才可以接受。

-

Stanford NLP for Python

问题内容: 我要做的就是找到任何给定字符串的情绪(正/负/中性)。在研究中,我遇到了斯坦福大学NLP。但是可悲的是它在Java中。关于如何使它适用于python的任何想法? 问题答案: 下载Stanford CoreNLP 目前(2020-05-25)的最新版本是4.0.0: 如果您没有,则可能有: 如果其他所有方法均失败,请使用浏览器;-) 安装套件 启动服务器 笔记: 以毫秒为单位,我将其设置

-

Stanford nlp for python

我想做的只是找到任何给定字符串的情绪(积极/消极/中性)。在研究中,我遇到了斯坦福大学的NLP。但可悲的是它在爪哇。对于如何使它适用于Python有什么想法吗?

-

高德 POI NLP

高德 POI NLP问的比较基础,有些拷打的挺深。估计还是没论文和竞赛,一面完第二天就挂了 1. 在任务对话系统中,大模型的成本较高,有没有自己微调或者调用接口?哪种合适? 2. Agent是什么概念?编排指的是什么? 3. 大模型中agent的主流框架? 4. 在RAG的知识库构建中,文本是什么格式的?PDF、WORD?设计OCR吗? 5. 有哪些工业界使用的OCR接口? 6. 用大模型做embedding,维度是

-

鹅厂pcg-nlp

鹅厂pcg-nlp4.10 一面 40mins,offer情况,只问了项目,面试官提了一个非常值得思考的问题,被拷打,没有八股,没有手撕, 4.11 二面 30mins ,offer情况,只问了项目,一点八股,没有手撕 (只得一提的是,终于看到鹅厂面试官开视频了 4.14 三面 40mins,offer情况,只问了项目,没有八股 没有手撕,跟面试官聊的不错 没太有八股和手撕,且面试时间较短,个人怀疑是上周面完qq浏

-

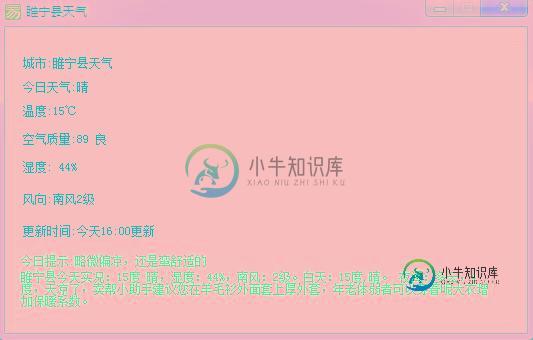

易语言调用墨迹天气实现自动定位获取天气情况的代码

易语言调用墨迹天气实现自动定位获取天气情况的代码本文向大家介绍易语言调用墨迹天气实现自动定位获取天气情况的代码,包括了易语言调用墨迹天气实现自动定位获取天气情况的代码的使用技巧和注意事项,需要的朋友参考一下 常量数据表 实时天气自动定位源码 此功能需要加载精易模块5.6 运行结果: 总结 以上就是这篇文章的全部内容了,希望本文的内容对大家的学习或者工作具有一定的参考学习价值,谢谢大家对呐喊教程的支持。如果你想了解更多相关内容请查看下面相关链接

-

SonarLint仍然显示阻止程序错误,即使我们处理了该语句,连接在finally block中关闭

SonarLint显示以下错误: '使用try with resources或在“finally”子句中关闭此“语句”。' '使用try with resources或在“finally”子句中关闭此“连接”。'<即使我们关闭了finally block中的语句stmt,Connection con,阻塞器也会出错 请查找示例代码。 我们可以通过以下方式修改finally块来解决这个问题。但它似乎

-

10. 变量处理 - 10.1 字符串处理

Bash 支持的字符串操作数量达到了一个惊人的数目。但可惜的是,这些操作工具缺乏一个统一的核心。他们中的一些是参数代换的子集,另外一些则是 UNIX 下 expr 函数的子集。这将会导致语法前后不一致或者功能上出现重叠,更不用说那些可能导致的混乱了。 字符串长度 ${#string} expr length $string 上面两个表达式等价于C语言中的 strlen() 函数。 expr "$s

-

错误处理 - 使用 Box 处理错误

通过对错误类型实现 Display 和 From,我们能够利用上绝大部分标准库错误处理工具。然而,我们遗漏了一个功能:轻松 Box 我们错误类型的能力。 标准库会自动通过 Form 将任意实现了 Error trait 的类型转换成 trait 对象 Box<Error> 的类型(原文:The std library automatically converts any type that imp

-

处理海量数据的Spring批处理

我的数据库中有大约1000万个blob格式的文件,我需要转换并以pdf格式保存它们。每个文件大小约为0.5-10mb,组合文件大小约为20 TB。我正在尝试使用spring批处理实现该功能。然而,我的问题是,当我运行批处理时,服务器内存是否可以容纳那么多的数据?我正在尝试使用基于块的处理和线程池任务执行器。请建议运行作业的最佳方法是否可以在更短的时间内处理如此多的数据

-

spark流式处理失败的批处理

我在spark streaming应用程序中看到一些失败的批处理,原因是与内存相关的问题,如 无法计算拆分,找不到块输入-0-1464774108087

-

spring批处理不处理所有记录

我正在使用spring批处理使用RepositoryItemReader从postgresql DB读取记录,然后将其写入主题。我看到大约有100万条记录需要处理,但它并没有处理所有的记录。我已经将reader的pageSize设置为10,000并且与提交间隔(块大小)相同

-

Spring批处理块处理提交频率

如果我正在读写本地文件,那么对远程数据库服务器的更新相对昂贵。如果增加[chunk-size],内存使用量就会上升。 提交频率对编写本地文件并没有太大的影响,所以对我来说,元数据更新才是一个问题。该步骤是可重新启动的,因此从技术上讲,我不需要记录中间提交计数。 对于JobRepository,我可以只使用map或内存数据库,但我需要其他信息,例如持久化的开始/结束时间,而且这个问题只涉及一个步骤。

-

Apache Flink错误处理和条件处理

我是Flink的新手,已经通过网站/示例/博客开始学习。我正在努力正确使用操作符。基本上我有两个问题 问题1:Flink是否支持声明性异常处理,我需要处理解析/验证/。。。错误? 我可以使用组织吗。阿帕奇。Flink。运行时。操作员。分类ExceptionHandler或类似的程序来处理错误 还是Rich/FlatMap功能是我的最佳选择?如果Rich/FlatMap是唯一的选项,那么是否有办法在

-

流处理和消息处理的区别

流处理和传统消息处理的基本区别是什么?正如人们所说,kafka是流处理的好选择,但本质上,kafka是一个类似于ActivMQ、RabbitMQ等的消息传递框架。 为什么我们通常不说ActiveMQ也适合流处理呢。 消费者消费消息的速度是否决定了它是否是流?