《中邮消费金融有限公司》专题

-

支持Redis Pub / Sub上的竞争消费者吗?

问题内容: 我有2个服务。他们两个都需要订阅相同的频道。 这两个服务是负载平衡的。每个服务都在多个服务器上运行。 因此,如何确定每个服务只有1个实例消耗该通道的消息。 Redis支持此功能吗? 谢谢 问题答案: Pubsub不能这样工作- 消息会发送到所有已连接的已订阅客户端。但是,您可以对其进行设置,以使该频道是列表更新的通知。这样,所有客户端都会收到消息,但是只有一个客户端可以使用LPOP从列

-

Java Camel Netty TCP消费者仅接收1024字节

我正在使用最新版本的骆驼和Netty与Spring,并且具有以下定义: 我定义了一个类来处理传入的tcp请求: 我的问题是,不管传入消息的大小,buf变量永远不会超过1024字节,因此我的请求被截断。 根据组件定义,receiveBufferSize应该是65536字节。我如何处理大的请求?

-

如何替代/过渡一个Kafka消费群体?

我有一个包含多个Kafka作品的资源库。我想将其中一个流提取到它自己的存储库中。但是,我不确定如何处理那个流的消费群体。我的意思是:在新的存储库中,流将有一个不同的< code>application.id。据我理解,消费者组的名称是基于< code>application.id设置的。如果我简单地关闭旧流,对于每个主题的每个分区,新流将从第零个偏移量开始,而不是从旧流停止的偏移量开始。这将导致输

-

Kafka来自不同分区的多个消费者

我有4个分区和4个消费者(例如A、B、C、D)。如何使用使用者组配置哪个使用者将从哪个分区读取数据。我用的是Kafka的春靴。

-

无法阅读Kafka主题使用Kafka消费者?

因为我是新的Kafka,所以我能够从文件中读取记录,并通过生产者将消息发送到Kafka主题,但不能通过消费者消费相同的主题。 注意:您可以从任何文本文件中读取数据,我使用的是Kafka2.11-0.9。0.0版本 这是我的密码: 下面是输出:

-

如何暂停Kafka消费者的投票行为?

我想在特定时间停止对特定主题的轮询。 Spring防尘套2.X Springkafka 2.5.5 Kafka版本2.5.1 比如即使有消息进来测试题目分区,消息也是从00到01堆在分区里,没有消耗。 01点之后,我想再次使用有关TEST主题的消息。 如何暂停和恢复?

-

如何恢复一个暂停骆驼消费者

null

-

Apache Camel-Kafka组件-单生产者多消费者

我创建了两个apache camel(blueprint XML)kafka项目,一个是kafka-producer(接受请求并将其存储在kafka服务器中),另一个是kafka-consumer(从kafka服务器获取ups消息并处理它们)。 这个设置对单个主题和单个消费者都很有效。然而,我如何在同一个Kafka主题中创建单独的消费者组?如何在不同的消费者群体中路由同一主题中的多个消费者特定消息

-

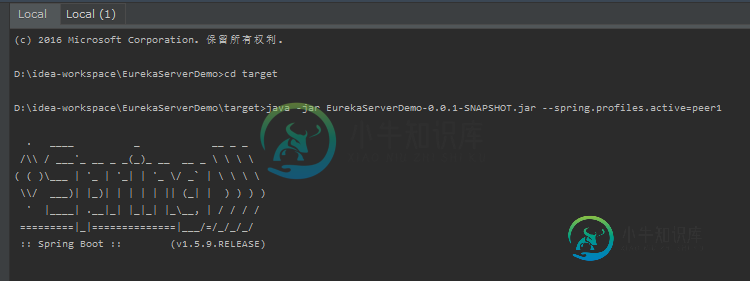

Spring-cloud 服务发现与消费(以ribbon为例)

Spring-cloud 服务发现与消费(以ribbon为例)本文向大家介绍Spring-cloud 服务发现与消费(以ribbon为例),包括了Spring-cloud 服务发现与消费(以ribbon为例)的使用技巧和注意事项,需要的朋友参考一下 说明: ribbon是spring-cloud中作为服务消费者的一种角色,客户端可以通过它来对服务提供者的服务进行消费, 比如本例中是服务提供者注册到注册中心,服务提供者提供了一个服务接口,返回一个hello字符

-

多线程生产者/消费者同步问题

我有两个线程的问题,似乎没有正确同步。我基本上有一个布尔值名为“已占用”。当没有线程启动时,它被设置为false。但是当一个线程启动时,线程集被占用是真的,我有一个类,它有线程(run),它们调用下面的函数。 这是一个模拟银行的示例,它接收一个金额(初始余额),然后随机执行取款和存款。我的教授提到了一些关于从取款线程到存款线程的信号?这是怎么回事?在提取线程中,它应该运行到余额为2低,并等待存款线

-

Kafka消费群体活跃度空主题分区

跟进这个问题——我想知道消费者组和偏移过期之间的语义学。总的来说,我很想知道,kafka协议如何确定一些特定的偏移量(对于消费者组、主题、分区组合)过期?它是基于作为组协议一部分的消费者的定期提交,还是在所有消费者被视为已死/关闭后应用?我认为这可能会在处理数据不经常生成的主题分区时产生影响。在我的例子中,我们有一个来自相当主题的消费者组读取(产生的数据不多)。由于消费者组不定期提交任何偏移量,我

-

Kafka的消费者如何与服务器通信?

Kafka消费者是否一直在检查代理(Kafka服务器)的运行状况,反之亦然 让我们说,无论如何,消费者和经纪人都知道彼此的健康状况,那么消费者将如何准确地从分区中读取 假设一个主题有48个分区,该主题有两个使用者组,那么有多少线程将使用所有分区中的数据

-

Kafka-慢速消费情况下的最佳实践

我有一个用例,在这个用例中,我有3个Kafka消费者向一个主题写作,每个消费者中的消息都需要按顺序处理。在这种情况下,如果某个消费者中存在延迟,则需要更早处理的消息将被丢弃(写入条件)。那么,有没有一种方法可以维持这些消息的顺序呢。

-

如何实现Spring Kafka消费者的高性能

如何提高Kafka消费者的绩效?我有(并且需要)至少一次Kafka消费语义学 我有以下配置。processInDB()需要2分钟才能完成。因此,仅处理10条消息(全部在单个分区中)就需要20分钟(假设每条消息2分钟)。我可以在不同的线程中调用processInDB,但我可能会丢失消息!。如何在2到4分钟的时间窗口内处理所有10条消息? 下面是我的Kafka消费者代码。

-

Kafka通过Kafka消费者API流式传输DSL

最近,在一次采访中,我被问到一个关于Kafka流的问题,更具体地说,面试官想知道为什么/什么时候您会使用Kafka流DSL而不是普通的Kafka消费者API来读取和处理消息流?我不能给出一个令人信服的答案,我想知道使用这两种流处理风格的其他人是否可以分享他们的想法/意见。多谢了。