《阿里云分布式块存储》专题

-

Hadoop 2.x伪分布式环境搭建详细步骤

本文向大家介绍Hadoop 2.x伪分布式环境搭建详细步骤,包括了Hadoop 2.x伪分布式环境搭建详细步骤的使用技巧和注意事项,需要的朋友参考一下 本文以图文结合的方式详细介绍了Hadoop 2.x伪分布式环境搭建的全过程,供大家参考,具体内容如下 1、修改hadoop-env.sh、yarn-env.sh、mapred-env.sh 方法:使用notepad++(beifeng用户)打开这三

-

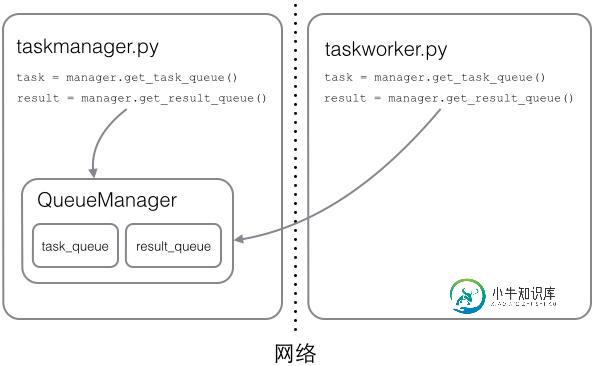

在Python程序中实现分布式进程的教程

在Python程序中实现分布式进程的教程本文向大家介绍在Python程序中实现分布式进程的教程,包括了在Python程序中实现分布式进程的教程的使用技巧和注意事项,需要的朋友参考一下 在Thread和Process中,应当优选Process,因为Process更稳定,而且,Process可以分布到多台机器上,而Thread最多只能分布到同一台机器的多个CPU上。 Python的multiprocessing模块不但支持多进程,其中man

-

瘦客户端的ignite ClientCache是否支持分布式锁

现在我使用的是瘦客户机的ignite ClientCache,我没有找到ClientCache的分布式锁,如果要使用分布式锁,必须使用ignition.start()

-

基于Spring批处理和AMQP的分布式批处理

我想分散加工大批量。这个想法是使用Spring Batch在云中激发一堆AMQP消费者,然后加载廉价的任务(如项目ID)并将它们提交给AMQP交换。结果的书写将由消费者自己完成。 null

-

Hadoop伪分布式java.net.ConnectException:在虚拟框上拒绝连接

我已经在ubuntu上安装了hadoop,它运行在VirtualBox上。当我第一次安装hadoop时,我可以毫无问题地启动hdfs和创建目录。 但是当我重新启动虚拟机后,当尝试在HDFS上运行ls命令时,我得到了“拒绝连接”的错误。然后,我根据Hadoop集群设置在sshd_config中添加了“端口9000”-java.net.connectException:Connection Relec

-

Karaf中的分布式OSGI消费者服务未启动

我刚刚开始使用动物园管理员在卡拉夫的DOSGi。我在Karaf的一个实例中提供服务,在另一个实例中提供消费者。服务端运行良好。一旦发布,我可以在安装了Zookeeper服务器的Karaf控制台中使用log:display命令查看它,并且我也可以通过浏览器访问wsdl。问题出在消费端。当服务启动时,它应该写一条消息(下面的ref代码),但是它从来没有发生。消费者代码: 和component.xml:

-

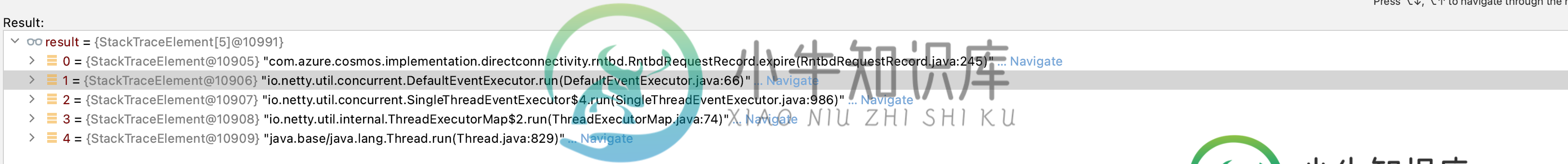

在 Azure cosmos DB 中维护分布式增量计数器

在 Azure cosmos DB 中维护分布式增量计数器我对cosmos DB相当陌生,并试图了解azure cosmos DB SDK为修补文档提供的Java的增量操作。我需要在容器中的一个Documents中维护一个增量计数器。文档看起来像这样- 现在,在我的应用程序中,每当一个动作发生时,我想将这个计数器的值增加1。为此,我使用了宇宙空间运算。我在这里添加了一个增量,就像这样< code > cosmos patch . increment("/

-

如何在分布式测试中使用JMeter Simple Table Server?

我正在尝试在分布式测试中设置JMeter Simple Table Server(STS)。在本地,在主控制器上,STS服务器已启动,我可以使用

-

整理分布式唯一ID的六种生成方案

整理分布式唯一ID的六种生成方案主要内容:(1)方案一:独立数据库自增id,(2)方案二:uuid,(3)方案三:获取系统当前时间,(4)方案四:snowflake算法的思想分析,(5)snowflake算法的代码实现,(6)snowflake算法一个小小的改进思路上一篇文章,我们聊了一下分库分表相关的一些基础知识,具体可以参见:《用真实业务场景告诉你,高并发下如何设计数据库架构?》。 这篇文章,我们就接着分库分表的知识,来具体聊一下全局唯一id如何生成。 在分库分表之后你必然要面对的一个问题,就是id咋生成? 因为要是一个表

-

第四章 Hadoop的安装 - 3. Hadoop 2.7.2完全分布式

一 生产环境描述 1 网络环境 hadoopmaster 192.168.1.159 hadoopslave1 192.168.1.76 hadoopslave2 192.168.1.166 2 软件环境 JDK 7U79 Hadoop 2.7.2 二 hadoopmaster主机配置 1 JDK设置 chu888chu888@hadoopmaster:~$ ls jdk-7u79-linux-x

-

第四章 Hadoop的安装 - 1.Hadoop 2.6.2完全分布式

1网络拓扑 192.168.1.80 Master 192.168.1.82 Slave1 192.168.1.84 Slave2 2安装JDK 所有实验主机都需要正确的安装JDK,具体操作方法 chu888chu888@ubuntu1:~$ tar xvfz jdk-8u65-linux-x64.gz chu888chu888@ubuntu1:~$ sudo cp -r jdk1.8.0_65/

-

分布式安装 - 邮件/短信/微信发送接口

监控系统产生报警事件之后需要发送报警邮件或者报警短信,各个公司可能有自己的邮件服务器,有自己的邮件发送方法;有自己的短信通道,有自己的短信发送方法。falcon为了适配各个公司,在接入方案上做了一个规范,需要各公司提供http的短信和邮件发送接口。 短信发送http接口: method: post params: - content: 短信内容 - tos: 使用逗号分隔的多个手机号 邮件

-

一文读懂 hadoop、hbase、hive、spark 分布式系统架构

本文结构 首先,我们来分别部署一套hadoop、hbase、hive、spark,在讲解部署方法过程中会特殊说明一些重要配置,以及一些架构图以帮我们理解,目的是为后面讲解系统架构和关系打基础。 之后,我们会通过运行一些程序来分析一下这些系统的功能 最后,我们会总结这些系统之间的关系 分布式hadoop部署 首先,在http://hadoop.apache.org/releases.html找到最新

-

反射(Reflection), 对象空间(ObjectSpace),和分布式Ruby(Distributed Ruby)

One of the many advantages of dynamic languages such as Ruby is the ability tointrospect---to examine aspects of the program from within the program itself. Java, for one, calls this featurereflection

-

通过 AOP 动态创建/关闭 Seata 分布式事务

通过GA大会上滴滴出行的高级研发工程陈鹏志的在滴滴两轮车业务中的实践,发现动态降级的必要性是非常的高,所以这边简单利用spring boot aop来简单的处理降级相关的处理,这边非常感谢陈鹏志的分享! 可利用此demo项目地址 通过以下代码改造实践. 准备工作 1.创建测试用的TestAspect: package org.test.config; import java.lang.ref