《音视频》专题

-

g拖缆音频错误

我有一个g流光命令工作得很好 gst-Launst-0.10 v4l2src!视频缩放方法=0!视频/x-raw-yuv,宽度=852,高度=480,帧速率=(分数)24/1!ffmpegColorspace!x264enc pass=pass1线程=0比特率=900曲调=零一致性!flvmux名称=mux!rtmp位置='rtmp://.../live/test'demux。alsasrc!音频

-

用ffmpeg解码AAC音频

用ffmpeg解码AAC音频我正在尝试解码ADTS容器中的AAC音频流,该音频流来自外部硬件H264编码器。 我分析了ADT,它告诉我我有一个2通道,44100 AAC主配置文件框架。我为ffmpeg解码器设置了额外的数据字节,并成功解码了帧?详情如下: (伪c代码) 设置解码器: 设置额外的数据字节: 然后解码帧: 解码帧: 现在,据我所知,32位原始格式的每个帧每个采样将有4个字节,每个通道将被交错(因此每4个字节是交替

-

Android到Android音频直播

我计划开发一个乐器应用程序,当我们摇动android手机时,它会发出“angklung”(谷歌it)的声音。 问题是: 如何使一个Android手机可以分享其生产的声音(通过摇动手势)到其他Android手机有我的应用程序? 我想使用的连接是移动数据连接和wi-fi。 我认为这个人也有同样的问题,但我不知道如何与他沟通。将android流式传输到android,但没有任何帮助。。 我需要解决这个问

-

音频文件结尾(java)

我已经为播放音频文件编写了此代码,我想在播放后获得音频文件何时结束的指示。我试过AS。getMicrosecondLength()==AS。getMicrosecondPosition(),但未为AudioStream定义这些方法。请告诉我怎么做。

-

Audio Listener 音频侦听器

The Audio Listener acts as a microphone-like device. It receives input from any given Audio Source in the scene and plays sounds through the computer speakers. For most applications it makes the most

-

在线音频播放器

一款带有圆形进度条的在线音频播放器。 [Code4App.com]

-

javascript - 音频处理分割?

目前需要用whsiper做语音转录服务,whisper限制25M的大小,请问该如何做这个事情? 目前的需求是 Android iOS Web 都需要这个功能, 目前有几种方案: 方案1 做一个音频分割服务器,然后在做一个转录服务。前端拿到语音文件之后,把语音文件传给音频分割服务器,分割服务器根据波形进行分割,分割完之后传给转录接口。 问题: 这样做的话是不是会造成语音上传多次导致时间较长的问题,因

-

海康威视NVR视频转换ffmpeg

下载示例链接:

-

我想创建一个muxer,用于混合通过解析MPEG-DASH URL获得的音频和视频

我的问题是,我试图访问一个实时视频流,我正在以MPEG-DASH URL的形式接收它。有了这个URL,我可以分别以m4v和m4a扩展的形式获取视频和音频数据块。 我将从每个片段中获取的字节推送到服务器(目前分别用于音频和视频)。我希望当我使用MPD URL(MPEG-DASH URL)时,我可以动态地将音频和视频片段字节的小块进行多路复用,并将结果字节发送到包含混合音频和视频的服务器。 问题是我可

-

FFmpeg:使用相册插图将文件夹中的所有音频(mp3)批量转换为视频(mp4)

我正在寻找批量转换文件夹中的所有音频(mp3)到视频(mp4)与相册艺术作品。这是用于将音频上传到youtube的。我几乎有一个工作代码,但我想自动化整个事情。 这是我的密码。我用的是bat文件。 (来源:FFMpeg批量图像多音频到视频) "C:\ffmpeg\bin\ffmpeg"编解码器的文件夹 "C:\ffmpeg\bin\input.jpg"图像路径 "C:\mp4\%%~na.mp4"

-

如何在音频均衡器中添加立体声,高音选项?

问题内容: 我正在尝试使用小型音频歌曲均衡器。我想在其中添加 高音,立体声等选项,就像在Poweramp播放器中一样。 Poweramp音乐播放器的图像 我成功实现了5个频段的均衡器,如下所示: 上面的代码只是我的均衡器代码的简短摘要。它不会像 我在此处发布的示例那样起作用。。 我也想在均衡器中添加高音,立体声,单声道效果。 我已经像这样实现了低音增强: 我使用了Inbulilt类来增强低音。 如

-

Android音频FFT使用音频记录检索特定频率幅度

问题内容: 我目前正在尝试使用Android实现一些代码,以检测何时通过手机的麦克风播放了多个特定音频频率范围。我已经使用AudioRecord该类设置了该类: 然后读取音频: 执行FFT是我遇到的困难,因为我在这方面的经验很少。我一直在尝试使用此类: Java和Complex类中的FFT一起使用 然后,我发送以下值: 这很容易让我误解了此类的工作原理,但是返回的值到处都是跳跃的,即使在沉默中也不

-

音乐机器人没有检测到用户在语音频道中

我有一个叫“土豆音乐”的音乐机器人,它是一个音乐机器人。目前,机器人按照我希望的方式执行命令。但是一旦我停止在本地托管机器人并将其部署在Heroku上,就有一些错误开始出现。 我有一个名为“播放”的命令,每当我执行该命令时,它都应该在语音频道上播放歌曲。命令在命令开头有一个条件,用于检查用户是否已经在语音频道中。但是在我在Heroku上托管了这个机器人之后,一旦我执行命令,它就会一直告诉我我没有连

-

我如何在freetts中将输出语音存储到音频文件

问题内容: 我正在尝试将freetts用于一个简单的Java应用程序,但是我遇到了一个问题,谁能告诉我如何在我的程序中将输出的语音(从文本转换为语音)保存为wave文件。我想通过代码做到这一点。 这是示例提供的示例helloworld应用程序 这段代码可以正常工作,我想将输出保存为磁盘上的音频文件。 谢谢普兰尼 问题答案: 我想出了方法,您只需要简单地使用传递文件名和文件类型,样本声明就应该像这样

-

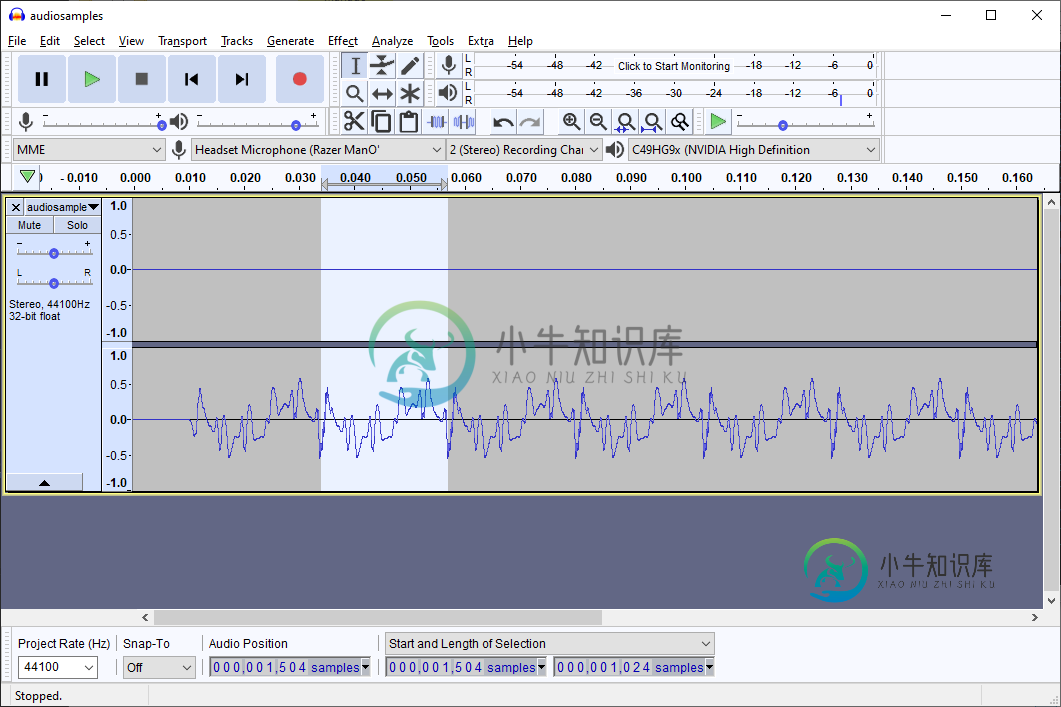

与音频流格式和核心音频数据类型的混淆

我正在使用核心音频(与swift包装)播放一些音频样本(一个简短的刺激,其中记录一个冲动)。我坚持使用核心音频,而不是更新的AVFoundation,因为我需要一些严格的定时和多设备输入,更新的框架还没有涵盖(我通过苹果代码请求他们告诉我必须使用核心音频)。 我现在创建了一个非常简单的正弦波,使用: 如果我把它写到一个wav文件并回放,音调就会按预期的方式创建。 然而,我实际上想在应用程序中触发这