《烽火星空》专题

-

在火花中加入两个数据帧,只返回一个匹配

我有两个这样的数据帧: DF1: DF2: 当我left_outer或内连接df1和df2时,我希望得到的数据帧如下: 当我加入时,id 1是c1、c2还是c3并不重要;但我只需要一张唱片。 请让我知道如何才能在火花中实现这一点。 谢谢你,约翰

-

带序列化的Scala反射(过火花)-符号不可序列化

首先,我使用的是scala 2.10.4,上面的例子是在Spark 1.6中运行的(尽管我怀疑Spark与此有关,但这只是一个序列化问题)。 所以我的问题是:假设我有一个trait,它由两个类实现,比如说和。现在,我有一个泛型特征,它由一组类扩展,其中一个类位于的子类型之上,例如(这里我保留了Spark对RDD的概念,但一旦序列化,它实际上可能是另一个类;不管实际情况如何,它都只是一个结果): 现

-

火花中的任务是什么?Spark worker如何执行jar文件?

在阅读了http://spark.apache.org/docs/0.8.0/cluster-overview.html上的一些文档之后,我得到了一些我想澄清的问题。 以Spark为例:

-

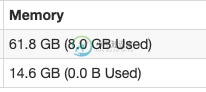

docker中的火花,为驱动程序/执行程序设置内存

docker中的火花,为驱动程序/执行程序设置内存我在一个单独的Docker中运行spark-master和spark-worker。 我能看见他们在跑 PS-EF grep火花根3477 3441 0 1 05?00:04:17/usr/lib/jvm/java-1.8-openjdk/jre/bin/java-cp/usr/local/spark/conf/:/usr/local/spark/jars/*-xmx1g org.apache.s

-

火花DF。选择返回带有标题的csv的不正确列

我正在实现Spark数据源API v1的buildScan方法。 我正在尝试读取一个带有标题的。csv文件。 但是buildScan()内部的df.show返回正确的列。 我无法找到列映射到底哪里出错了。

-

根据某些键将火花rdd分成2个单独的文件

我正在使用Cloudera VM,一个linux终端和火花版本1.6.0 假设我有以下数据集: 优先级、数量、销售额= 最低价,6,261.54 高,44,1012 低,1,240 高,252500 我可以加载," val input file = sc . textfile(" file:///home/cloud era/stat . txt ") 我可以排序,"inputFile.sort(

-

如何在使用火花数据帧写入时自动计算 numRepartition

当我尝试将数据帧写入Hive Parket分区表时 它将在HDFS中创建大量块,每个块只有少量数据。 我了解它是如何进行的,因为每个 spark 子任务将创建一个块,然后将数据写入其中。 我也理解,块数会提高Hadoop的性能,但达到阈值后也会降低性能。 如果我想自动设置数字分区,有人有一个好主意吗?

-

火花:如何在所有分区中均匀分配我的记录

我有一个有 30 条记录的 RDD(键/值对:键是时间戳,值是 JPEG 字节数组), 我正在运行 30 个执行器。我想将此 RDD 重新分区为 30 个分区,以便每个分区获得一条记录并分配给一个执行器。 当我使用 30) 时,它会在 30 个分区中重新分区我的 rdd,但有些分区得到 2 条记录,有些得到 1 条记录,有些没有得到任何记录。 在Spark中,有没有什么方法可以将我的记录平均分配到

-

如何让Docker在企业防火墙后的Windows系统上运行?

我试图得到一个工作的Docker安装以下教程:http://docs.docker.io/en/latest/installation/windows/ 到目前为止,我使用手动下载的存储库运行虚拟机(遵循GitHub链接并下载为ZIP文件,因为“git clone”在我的公司代理后面不起作用,即使在使用“git conf-globalhttp.proxy...“-它一直要求我进行认证407,尽管我

-

纱线模式下的火花RDD映射不允许访问变量?

我在mapr集群上安装了一个全新的spark 1.2.1,在测试它时,我发现它在本地模式下工作得很好,但在yarn模式下,它似乎无法访问变量,如果广播的话也是如此。准确地说,下面的测试代码 在局部模式下工作,但在纱线上失败。更准确地说,和这两个方法都失败了,如果它们都工作。

-

使用scala的布尔运算在火花数据帧中折叠列

我们如何使用scala使用OR操作将布尔列折叠成一行? 第1部分: 期望输出 我能想到的一个解决方案是按第一列条目对它们进行分组,filter true 这个解决方案相当混乱。此外,不知道这是否适用于所有边缘情况。有什么聪明的方法可以做到这一点吗? 编辑:给定的答案适用于上述给定的场景,但不适用于此场景。有什么方法可以实现所需的输出? 第2部分: 期望输出 我试图通过col1和col2分组,然后用

-

selenium 3. x支持火狐驱动程序和JXL方法吗?[重复]

当我使用JAVA和Firefox驱动程序运行硒代码时,我得到错误。Firefox驱动程序打开了,但它不能获取网站地址。 是硒3。x版本是否支持Firefox驱动程序?

-

当应用程序在后台时,火警通知不显示图像

当应用程序处于前台时,我可以成功地接收带有图像的通知和数据消息。 当应用程序在后台/kill时,onMessageReceed(message)没有调用,所以我使用getIntent(),我得到了数据,但当应用程序在后台时,android os会使用系统托盘自动显示通知,但图像无法显示。 所以我的问题是用图像显示通知文本? 我使用django api发送通知和发送的数据如下所示 下面是我的onMe

-

带火花连接器的Cassandra-如何向Cassandra插入项目列表

Java和Scala解决方案都受到欢迎

-

火花-从嵌套数组中的结构中选择列时出错

============更新========== 我在我的JSON中添加了一些更多的细节(struct_c和array_d)以使它更清楚地知道我在哪里得到了异常。 =============================================== 我有一个带有Struct类型嵌套数组的Spark DataFrame。我想从该结构中选择一个列,但收到错误消息:“org.apache.sp