《七牛云》专题

-

故障云数据流管道的诊断

在大约14个工作小时后,我有一个云数据流管道失败,下面是一条神秘的日志消息: 谢了!

-

谷歌云数据流--从PubSub到Parquet

我正在尝试使用谷歌云数据流将谷歌PubSub消息写入谷歌云存储。PubSub消息采用json格式,我要执行的唯一操作是从json到parquet文件的转换。

-

在Python云数据流中更新工作状态异常失败

我在Dataflow接口中得到的唯一错误是标准错误消息: 一个工作项尝试了4次,但没有成功。每一次工作人员最终都失去了与服务的联系。 分析Stackdriver日志只显示此错误: 我假设此错误与云运行器有关?但由于我在网上没有找到任何关于这个错误的信息,我想知道是否有人遇到了它,有更好的解释吗? 我使用的是。

-

将Pubsub的每X条消息写入云存储

我对云数据流/Apache Beam是个新手,所以概念/编程对我来说还是模糊的。 我想做的是让Dataflow监听Pubsub并以JSON的形式获取这种格式的消息: 并将其转换为: 因此所需的步骤是: > (IngestFromPubsub)通过收听主题从Pubsub获取记录(1条Pubsub消息=1条记录) (EnrichDataFromAPI) a.将有效负载的JSON字符串反序列化为Java

-

是否可以在RKE集群上使用云代码(VSCode内部)?

我正在研究是否可以在私有RKE集群上使用云代码(VSCode内部)?使用VSCode,连接到集群的唯一选择似乎包括GCP(或其他大型云计算提供商)或MiniKube。Kubectl在集群上的所有设置和工作都很好--只是在云中没有支持--运行/调试代码等?我运气不好吗?

-

ML docker容器本地设置完成。现在如何使用Kubernetes在共享云平台中进行部署?

我成功地将一个markLogic映像推送到我们的内部artifactory中,我们有一个bootstrap shell脚本,当执行该脚本时,它将在任何人的本地机器中设置一个3节点ML集群。这是剧本。 现在我熟悉docker,但不熟悉。我的下一步是在一个共享平台中部署和管理这个集群,为此我需要首先熟悉kubernetes,然后使用kubernetes在本地设置ML集群。 问题。 > 我需要像mini

-

通过docker、kubernetes和google云平台部署应用程序的步骤

我正试图将一个应用程序部署到谷歌云平台。我有我的后端和前端运行在单独的docker容器中,每个项目都有自己的Docker-Compose和Dockerfile,我使用一个容器为我的Postgres数据库。我将容器部署到Dockerhub,并创建了Kubernetes服务和部署。(使用Kubernetes Kompose:所以我首先将docker-compose转换为deployments.yaml

-

Firebase云消息传递与AWS SNS

我正试图将FCM与SNS整合。我在这个答案中读到设置应该与GCM相同。我设法创建了一个FCM应用程序,可以向android设备发送消息。当应用程序在后台时,设备在托盘中接收通知,或当应用程序在前台时打印接收的消息。我正试图整合它现在到SNS,但我似乎不能使它工作,没有任何错误信息。

-

使用Tensorflow变换的Apache梁作业(Python)被云数据流杀死

此外,我的生产代码(未显示)会出现以下消息: 有什么提示吗?

-

云Dataflow和Dataprep有什么不同

Dataprep和Dataflow都可以用于ETL任务。事实上,Dataprep似乎使用数据流作业。这是Dataprep提供的工具的唯一区别吗?

-

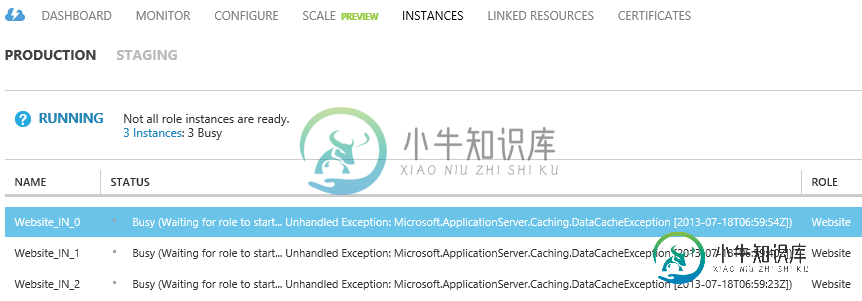

将包发布到云服务时出现DataCacheException

将包发布到云服务时出现DataCacheException在 Azure 门户中将包部署到云服务时,我发现了以下问题: 所有实例都在等待角色启动,出现以下异常: 未处理的异常:Microsoft.ApplicationServer.Caching.DataCacheException web角色在Compute Emulator上运行良好。 我最近确实向我的系统添加了共址缓存,但我不知道如何查明问题所在。 当我检查该角色的事件日志时,我发现了以下两个错误

-

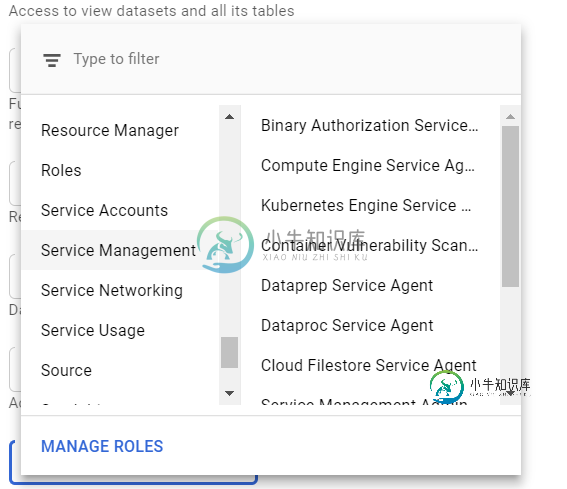

Dataprep不起作用-云数据流服务代理

Dataprep不起作用-云数据流服务代理我在删除服务帐户中的用户时出错,我应该删除另一个用户。之后,Dataprep停止运行作业。 我已经检查了关于dataflow和DataPrep的所有准则:如果API是启用的(是的,它是启用的)。如果有一个适当的服务帐户(是)。但我不知道给这些账户分配什么规则。 我尝试为该帐户分配“云数据流服务代理”角色,但它不适合我 附:我的英语正在进步,有些错误很抱歉。

-

云数据流错误失败,无法处理不同位置的数据

-

Google DataFlow:从Google云存储中读取未绑定的PCollection

我有一个将JSON消息从PubSub(未绑定的PCollection)流到Google云存储的管道。每个文件应该包含多个JSON对象,每行一个。 谢谢

-

Google云数据流依赖项

Posthoc将FFMPEG连接到opencv-python二进制文件,用于Google云数据流作业 根据这个问题,可能会拉出一个自定义docker图像,但我找不到任何关于如何使用DataFlow进行处理的文档。 https://issues.apache.org/jira/browse/beam-6706?focusedcommentid=16773376&page=com.atlassian.