Adam Blog is a minimal clear theme for Jekyll

Demo

Check the theme in action Demo

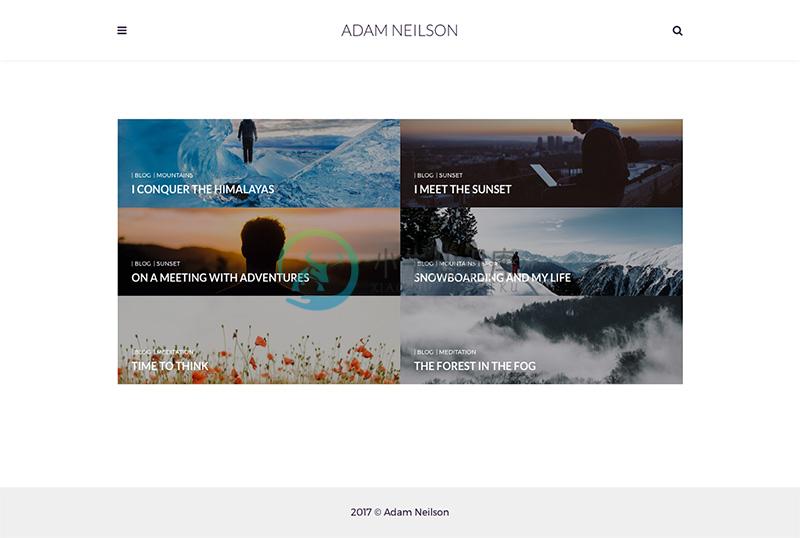

The main page would look like this:

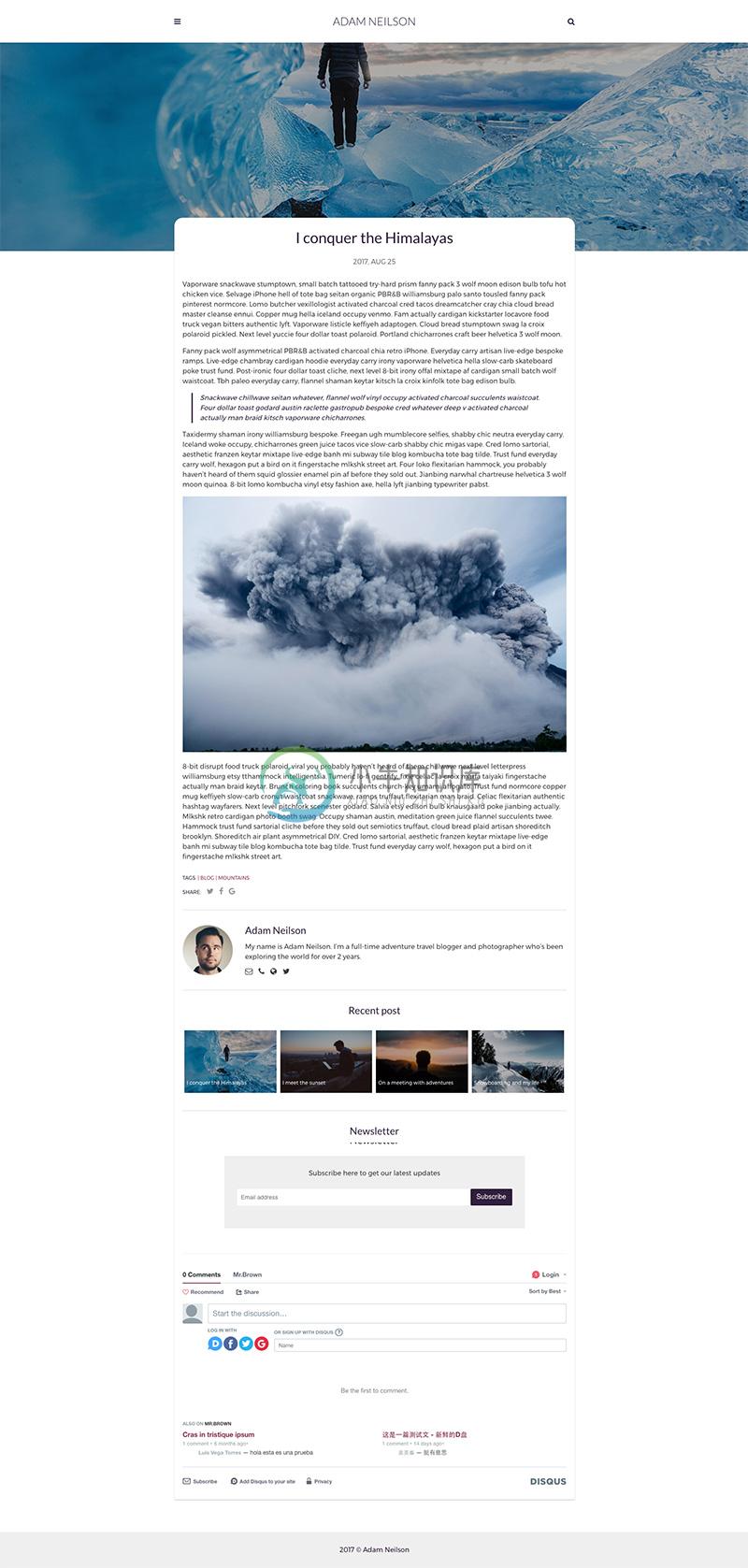

The post page would look like this:

Features

Installation:

Fork the master branch and delete gh-pages branch in it. This is important because gh-pages branch is used here only to host the blog. You should be using the master branch as the source and create a fresh gh-pages branch.

License

GNU General Public License v3.0

Donate

If you like the themes that I create you can become my sponsor on Patreon.

Thank you for your support

-

转载https://www.cnblogs.com/hoanfir/p/9048897.html top1直达96的模型: pytorch框架、网络模型SE-Resnet50,优化算法Adam pytorch: pytorch官方文档,每个模块函数都有github源码链 教程的链接 http://pytorch.org/tutorials/ 官方网站的连接 http://pytorc

-

Adam(Adaptive Moment Estimation) 优化算法实质上是将 Momentum 和 RMSprop 进行结合。Momentum 具有保持惯性的优点,RMSprop 实际上根据参数来调整学习率的衰减,体现环境感知能力。Adam 结合 Momentum 和 RMSprop,因此同时拥有惯性保持和环境感知这两个优点,而这两个优点也是缓解山谷震荡和鞍部停滞的关键动力。 简单地介绍了

-

更多代码请见:https://github.com/xubo245/SparkLearning ADAM学习之4集群安装(未成功) 1.基本: $ git clone https://github.com/bigdatagenomics/adam.git $ cd adam $ export MAVEN_OPTS="-Xmx512m -XX:MaxPermSize=256m" 2.安装maven

-

Adam, 适应性矩估计(adaptive moment estimation) 1. Adam优势 Adam 优化算法应用在非凸优化问题中所获得的优势: 直截了当地实现 高效的计算 所需内存少 梯度对角缩放的不变性(第二部分将给予证明) 适合解决含大规模数据和参数的优化问题 适用于非稳态(non-stationary)目标 适用于解决包含很高噪声或稀疏梯度的问题 超参数可以很直观地解释,并且基本

-

keras.optimizers.Adam(learning_rate=0.001, beta_1=0.9, beta_2=0.999, epsilon=None, decay=0.0, amsgrad=False) learning_rate: float >= 0. 学习率。 beta_1: float, 0 < beta < 1. 通常接近于 1。 beta_2: float, 0 < b

-

本文向大家介绍Adam相关面试题,主要包含被问及Adam时的应答技巧和注意事项,需要的朋友参考一下 参考回答: Adam 算法和传统的随机梯度下降不同。随机梯度下降保持单一的学习率(即 alpha)更新所有的权重,学习率在训练过程中并不会改变。而 Adam 通过计算梯度的一阶矩估计和二阶矩估计而为不同的参数设计独立的自适应性学习率。

-

Adam算法在RMSProp算法基础上对小批量随机梯度也做了指数加权移动平均 [1]。下面我们来介绍这个算法。 算法 Adam算法使用了动量变量$\boldsymbol{v}_t$和RMSProp算法中小批量随机梯度按元素平方的指数加权移动平均变量$\boldsymbol{s}_t$,并在时间步0将它们中每个元素初始化为0。给定超参数$0 \leq \beta_1 < 1$(算法作者建议设为0.9

-

本文向大家介绍SGD,Momentum,Adagard,Adam原理相关面试题,主要包含被问及SGD,Momentum,Adagard,Adam原理时的应答技巧和注意事项,需要的朋友参考一下 参考回答: SGD为随机梯度下降,每一次迭代计算数据集的mini-batch的梯度,然后对参数进行跟新。 Momentum参考了物理中动量的概念,前几次的梯度也会参与到当前的计算中,但是前几轮的梯度叠加在当前

-

问题内容: 我正在尝试使用张量流中的一些简单模型,包括一个看起来与第一个MNIST for ML Beginners示例 非常相似的模型,但具有更大的维度。我能够毫无问题地使用梯度下降优化器,获得足够好的收敛性。当我尝试使用ADAM优化器时,出现如下错误: 抱怨未初始化的特定变量根据运行而变化。这个错误是什么意思?这表明错了吗?无论我使用什么学习率,它似乎都会发生。 问题答案: AdamOptim

-

我试图写一个tenstorflow脚本,用于使用模型的图结构训练图像分割。我正在改编一些在线教程中的代码,很明显我做错了什么(或很多事情)。当我尝试使用adam优化器定义优化器时(见下文),我得到一个,指示

-

TLDR: 一个简单的(单隐藏层)前馈Pytorch模型被训练来预测函数的性能大大低于使用Keras构建/训练的相同模型。为什么会这样,可以做些什么来减轻性能差异? 在训练回归模型时,我注意到PyTorch的性能大大低于使用Keras构建的相同模型。 这种现象以前已经被观察和报道过: > 相同的模型在pytorch上产生的结果比在张量流上更差 pytorch中的CNN模型比Tensoflowflo