Pythia 是 Facebook 人工智能研究(Facebook AI Research,FAIR)的视觉问答研究模块化框架,它建立在 PyTorch 之上。

特性:

- Model Zoo:最先进的视觉和语言模型的参考实现,包括 LoRRA(SoQ on VQA 和 TextVQA)、Pythia 模型(VQA 2018 挑战获胜者)和 BAN。

- Multi-Tasking:支持多任务,允许同时训练多个数据集。

- Datasets:包括对内置的各种数据集的支持,包括 VQA、VizWiz、TextVQA 和 VisualDialog。

- Modules:为视觉和语言领域中的许多常用图层提供实现

- Distributed:支持基于 DataParallel 和 DistributedDataParallel 的分布式培训。

- Unopinionated:对于基于它构建的数据集和模型实现不受影响。

- Customization:可自定义损失、指标、调度、优化器、张量板等等

Pythia 还可以作为视觉和语言数据集挑战的入门代码库(TextVQA 挑战、VQA 挑战)。

-

光环板可以连接 mbuild 的 视觉模块 模块进行编程。 色块识别 1.视觉模块(1)切换到色块识别模式。 指定视觉模块切换到色块识别模式。 示例 按下光环板的按钮,视觉模块(1)切换到色块识别模式。 2. 视觉模块(1)开始学习色块(1)(直到按钮被按下) 指定视觉模块在制定操作执行后开始学习色块。 示例 按下光环板的按钮,视觉模块(1)开始学习色块(1)(直到按钮被按下)。 3. 视觉模块(

-

视觉模块能够识别条码和线条,也可以学习和识别颜色鲜艳的物体,实现诸如垃圾分类、智慧交通、物体追踪、智能巡线等功能。 连接主控板 通过不同的连线方式,可以将视觉模块作为一个 RJ25 电子模块或 mBuild 电子模块,连接到 mBot 或光环板,然后使用 mBot 或光环板控制视觉模块。 连接到 mBot 与 mBot 连接时,可以使用 3.7V 锂电池或 mBuild 电源模块连接到视觉模块,为

-

视觉模块能够识别条码和线条,也可以学习和识别颜色鲜艳的物体,实现诸如垃圾分类、智慧交通、物体追踪、智能巡线等功能。 连接主控板 通过不同的连线方式,可以将视觉模块作为一个 RJ25 电子模块或 mBuild 电子模块,连接到 mBot 或光环板,然后使用 mBot 或光环板控制视觉模块。 连接到 mBot 与 mBot 连接时,可以使用 3.7V 锂电池或 mBuild 电源模块连接到视觉模块,为

-

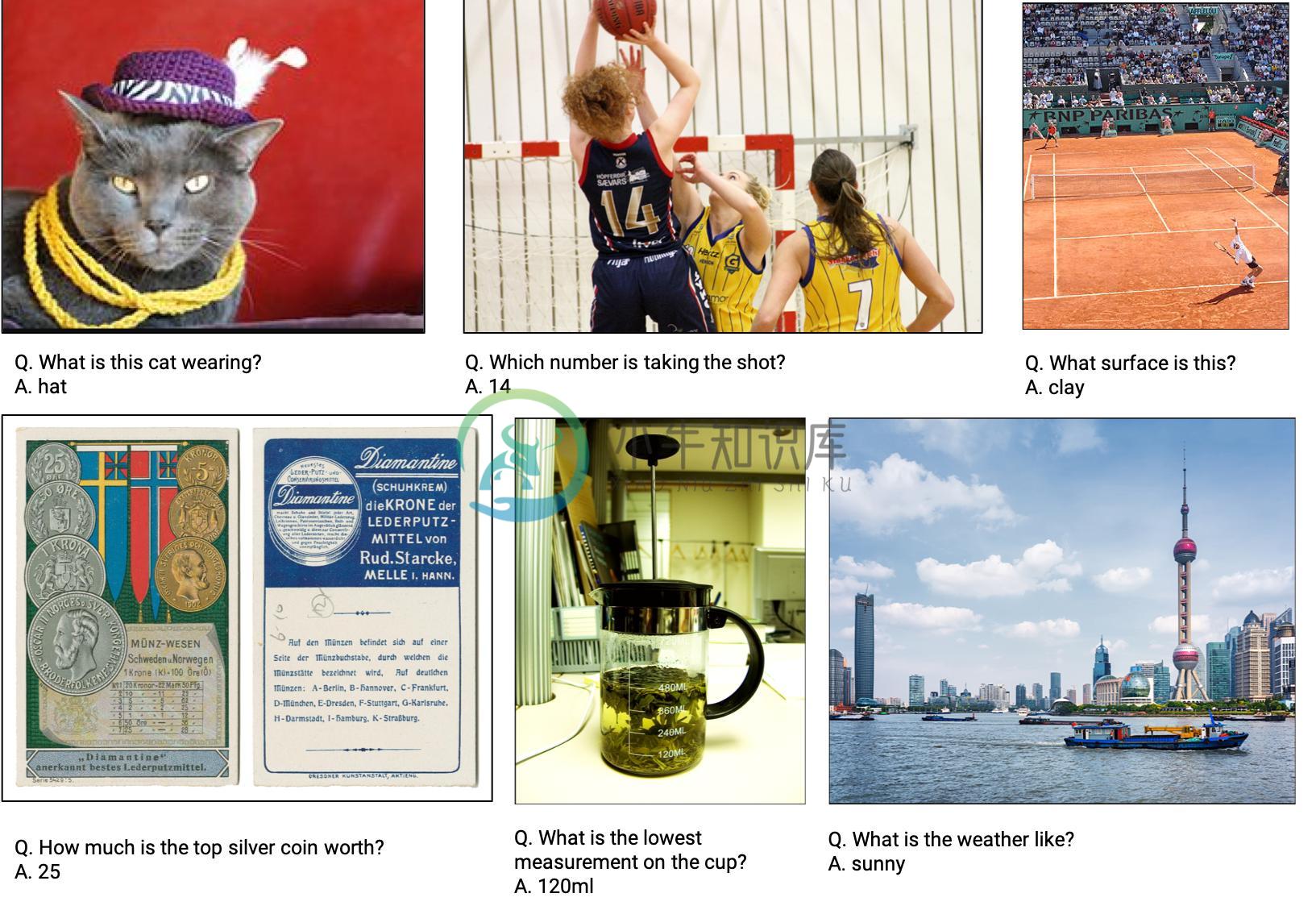

相关论文 [2016].Visual Question Answering 本文从数据集、评价方法、算法等方面讨论了 VQA 的现状及存在的问题,以及 VQA 的未来发展方向;特别讨论了现有数据集在训练和评价方面的局限性。 VQA 的难点 目前大多数关于图像的任务并不需要完全理解图像包含的信息。比如图像分类、物体检测、动作识别等。而解决 VQA 问题需要完全理解图像。 VQA 的问题可以使任意的,

-

行动时刻 - 调查模块的顺序 本练习要求您注意各个部分中列出的模块的顺序 在虚拟服务器内部。 打开FreeRADIUS配置目录下的sites-enabled / default文件。 仔细阅读并注意各部分内部使用模块的顺序。 一些注释会提到为什么模块位于某个部分内的某个位置。 以下关于默认文件的说明应该使事情更清楚。 访问请求 当Access-Request数据包进入FreeRADIUS服务器时,

-

线下笔试已过。 对着简历问的。 1、我硕士学了密码学,问我对称和非对称加密区别,分别有哪些算法,应用场景有哪些 2、中断机制 3、介绍小论文,问里面的东西 4、怎么防止过拟合

-

一、新增视频问答信息 通过该接口可以为视频新增一条问答信息, 地址为: https://spark.bokecc.com/api/question/create 需要传递以下参数: 参数 说明 userid 用户 id,不可为空 videoid 视频 id,不可为空 content 问答题目,不可为空(80字以内) explaininfo 问题的解答,150字以内 answers 问题的答案以及是

-

点击编辑,选择视频问答标签 点击新增问答进入问题设置页面 题目:自定义问题,字符不超过80字。 选择时间:根据需要添加问答的视频位置获取时间或者手动输入时间。 答案:可以自定义答案,字符不超过50字,最少两个答案选项,最多八个答案选项。点击“+”增加答案,点击“-”减少答案。点击“置为正确”可将答案设置为正确选项。 解答:根据问题设置解答描述。能否跳过:选择“是”,观看者可以跳过该问答。选择“否”