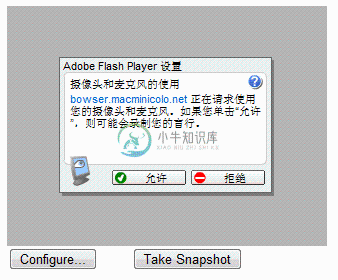

JPEGCam是一个开源的Flash+JavaScript library,可以利用它来开发在线头像制作系统。它能够从摄像头获取图像并保存成 JPEG格式的图片并提至交服务器中,服务器端采用PHP来处理保存图片。

-

我的网站放在美国的服务器上,网站上有在线摄像头图片捕获的功能,如果我把捕获的图片存在美国的服务器上速度很慢, 现在我想把图片存在我自己这边的服务器上,这样速度会快点。 因为涉及到flash的跨域名问题,所以我在自己这边服务器的根目录下放置了crossdomain.xml文件, 文件内容如下: XML code <?

-

JPEGCam在线摄像头捕获图片 下载地址http://code.google.com/p/jpegcam/downloads/list 里面的文档说明很详细,这里要说明的是,该项目服务器端用的php,如果我们后台用rails的话,在action里面要获得表单传来的图片流文件,需要用到方法request.raw_post def set_photo File.open("#{RAI

-

问题内容: 如何连续从摄像头捕获图像? 我想尝试对象识别(也许使用Java Media Framework)。 我当时正在考虑创建两个线程 一个线程: 节点1:捕获实时图像 节点2:将图片另存为“ 1.jpg” 节点3:等待5秒 节点4:重复… 其他线程: 节点1:等到捕获图像 节点2:使用“ 1.jpg”获取每个像素的颜色 节点3:将数据保存在数组中 节点4:重复… 问题答案: 此JavaCV实

-

我正在开发一个简单的博客应用程序,允许用户将照片从手机图库和描述上传到Firebase服务器。我正在尝试修改我的当前项目,以允许用户从照相机捕获照片并将其上载到firebase服务器。 目前,我能够将我捕获的图像显示到Image按钮中,但是我无法将我的图像发布到Firebase服务器(提交发布按钮不会对我的点击功能做出反应)。 我怀疑我的startPosting()函数中有错误,或者我没有正确编码

-

我正在尝试用相机拍照并上传到Firebase。我使用AlertDialog询问用户是否想要使用相机或从图库中选择图像。我可以用相机拍照,但是当我试图上传图像时,它说找不到图像。 以下是我的图像选择方法: 下面是我上传图片的方法: 提前感谢任何帮助的朋友。

-

我正在尝试编写一些objective-c代码,允许在特定的时间延迟后通过iPhone摄像头捕捉帧。我在网上找到的任何例子都捕捉到了摄像机输入的“当前”帧(即实时帧捕捉)。我正在寻找一种实时性较差的帧捕获方法——一种捕获具有特定时间延迟的帧的方法。有什么想法吗?

-

表情测试 图片转文字 相框 拍摄图片

-

摄像头用于采集图像和影像信息,通过模块间的组合完成各种创意活动。 净重量:8.1g 体积:24×24×22mm 参数 分辨率:1280×720 像素大小:3.4um×3.4um 最大图像传输速率:全尺寸 @ 30fps 视场角:100° 镜片结构:4G+IR 焦比:2.97 有效焦距:2.4mm 功耗:100uA(待机)~240mW(工作) 电源:USB总线电源 抗跌落能力:1m 工作温度:-30

-

我想在没有用户交互的情况下自动捕获图像,我能够使用捕获按钮捕获图像,但我的要求是图像捕获应该自动请帮助我实现这一点。

-

camera 对象提供对设备默认摄像头应用程序的访问。 方法: camera.getPicture 参数: cameraSuccess cameraError cameraOptions camera.getPicture 选择使用摄像头拍照,或从设备相册中获取一张照片。图片以base64编码的字符串或图片URI形式返回。 简单的范例: navigator.camera.getPicture( c