python 爬取马蜂窝景点翻页文字评论的实现

使用Chrome、python3.7、requests库和VSCode进行爬取马蜂窝黄鹤楼的文字评论(http://www.mafengwo.cn/poi/5426285.html)。

首先,我们复制一段评论,查看网页源代码,按Ctrl+F查找,发现没有找到评论,说明评论内容不在http://www.mafengwo.cn/poi/5426285.html页面。

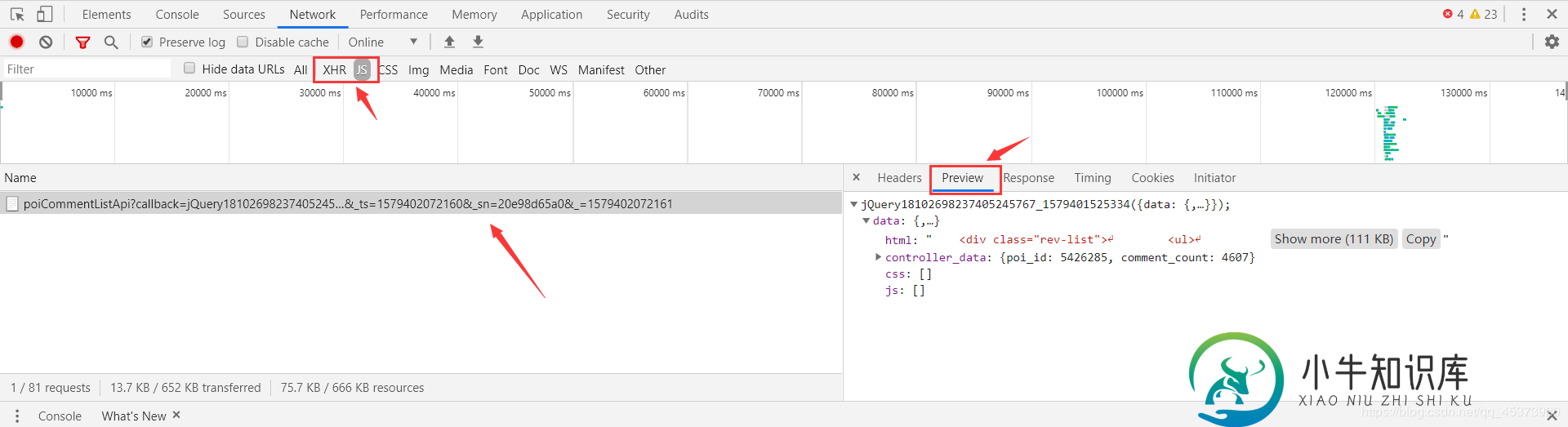

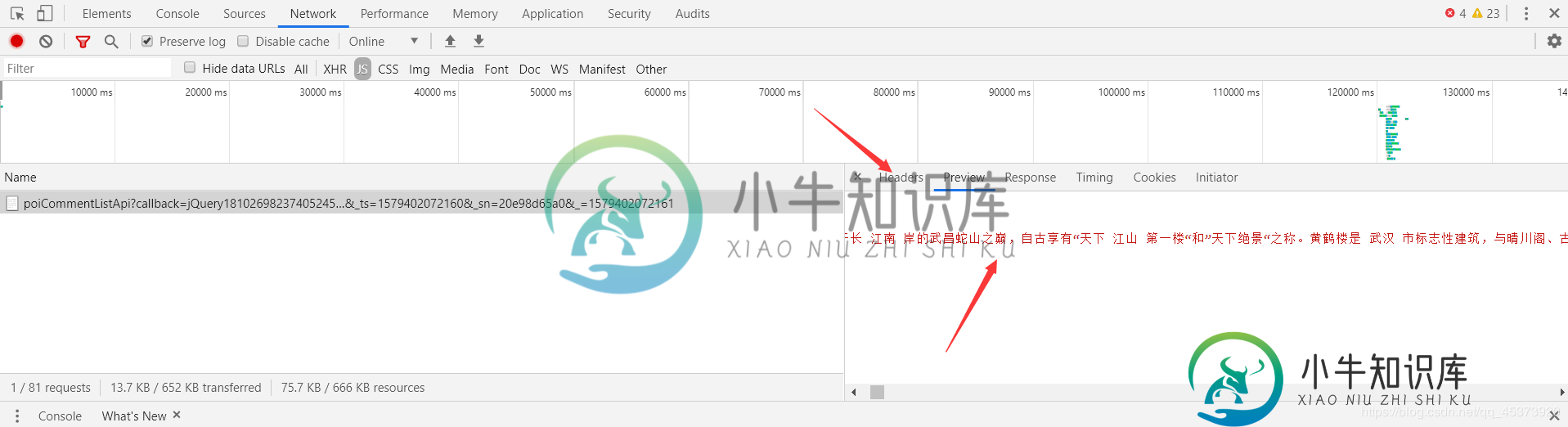

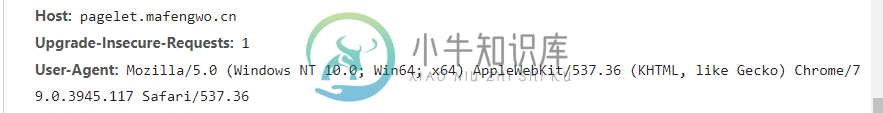

回到页面,划到评论列表,右键检查,选择Network,然后点击后一页翻页,观察Network里的变化,我们要爬的文件就在下面的某个文件里(主要找XHR和JS两个模块)。选择Preview可以更好的让我们寻找我们想要的文件,然后选择Headers找到我们要爬的url。

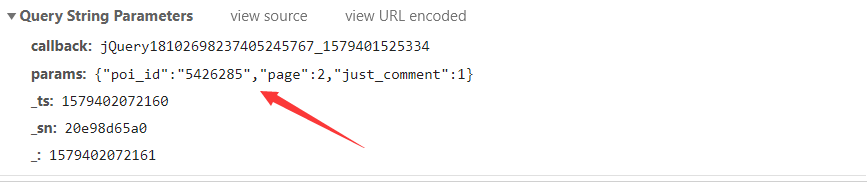

经过分析我们找到要爬取的url是http://pagelet.mafengwo.cn/poi/pagelet/poiCommentListApi?callback=jQuery18102698237405245767_1579401525334¶ms=%7B%22poi_id%22%3A%225426285%22%2C%22page%22%3A2%2C%22just_comment%22%3A1%7D&_ts=1579402072160&sn=20e98d65a0&=1579402072161

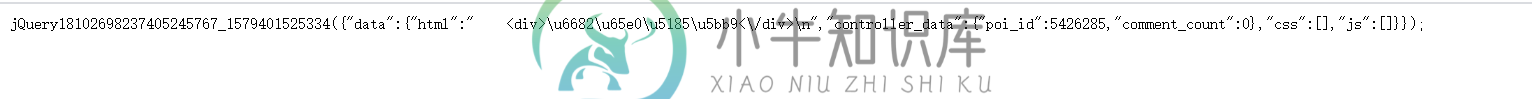

然而点进去是这样的

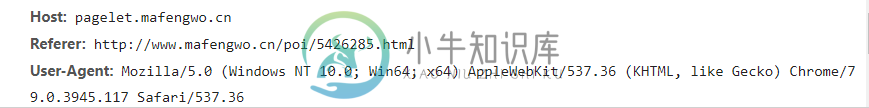

这个时候对比一下这两个页面的Request Headers,发现原页面多了个Refer参数

原页面

然后看一下请求get请求需要的参数Query String Parameters,其中poi_id是景点id,page是评论页面(翻页只用改变page的值就行)。

import re

import time

import requests

#评论内容所在的url,?后面是get请求需要的参数内容

comment_url='http://pagelet.mafengwo.cn/poi/pagelet/poiCommentListApi?'

requests_headers={

'Referer': 'http://www.mafengwo.cn/poi/5426285.html',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.88 Safari/537.36'

}#请求头

for num in range(1,6):

requests_data={

'params': '{"poi_id":"5426285","page":"%d","just_comment":1}' % (num) #经过测试只需要用params参数就能爬取内容

}

response =requests.get(url=comment_url,headers=requests_headers,params=requests_data)

if 200==response.status_code:

page = response.content.decode('unicode-escape', 'ignore').encode('utf-8', 'ignore').decode('utf-8')#爬取页面并且解码

page = page.replace('\\/', '/')#将\/转换成/

#日期列表

date_pattern = r'<a class="btn-comment _j_comment" title="添加评论">评论</a>.*?\n.*?<span class="time">(.*?)</span>'

date_list = re.compile(date_pattern).findall(page)

#星级列表

star_pattern = r'<span class="s-star s-star(\d)"></span>'

star_list = re.compile(star_pattern).findall(page)

#评论列表

comment_pattern = r'<p class="rev-txt">([\s\S]*?)</p>'

comment_list = re.compile(comment_pattern).findall(page)

for num in range(0, len(date_list)):

#日期

date = date_list[num]

#星级评分

star = star_list[num]

#评论内容,处理一些标签和符号

comment = comment_list[num]

comment = str(comment).replace(' ', '')

comment = comment.replace('<br>', '')

comment = comment.replace('<br />', '')

print(date+"\t"+star+"\t"+comment)

else:

print("爬取失败")

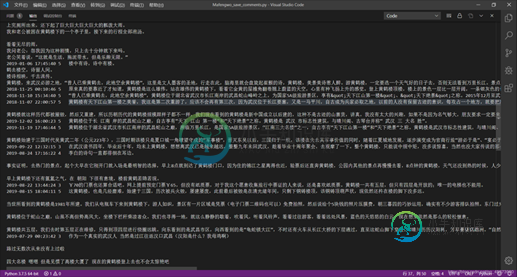

结果

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持小牛知识库。

-

本文向大家介绍python爬取微博评论的实例讲解,包括了python爬取微博评论的实例讲解的使用技巧和注意事项,需要的朋友参考一下 python爬虫是程序员们一定会掌握的知识,练习python爬虫时,很多人会选择爬取微博练手。python爬虫微博根据微博存在于不同媒介上,所爬取的难度有差异,无论是python新入手的小白,还是已经熟练掌握的程序员,可以拿来练手。本文介绍python爬取微博评论的代

-

本文向大家介绍scrapy实践之翻页爬取的实现,包括了scrapy实践之翻页爬取的实现的使用技巧和注意事项,需要的朋友参考一下 安装 Scrapy的安装很简单,官方文档也有详细的说明 http://scrapy-chs.readthedocs.io/zh_CN/0.24/intro/install.html 。这里不详细说明了。 在scrapy框架中,spider具有以下几个功能 1. 定义初始爬

-

蜂窝利用 目前,我们已经知道了如何在头单元上运行代码,前提是你能用USB设备(劫持)来连接汽车或访问车内的Wi-Fi(利用D-BUS漏洞/功能)。最大的问题是,这些入侵方法都要么需要接触到汽车,要么就需要攻击者加入到车上的Wi-Fi热点。 如果能加入到车内的Wi-Fi热点并进行漏洞利用是非常让人激动的,因为这就说明我们已经远程入侵了一辆原装汽车,但是,对我们来说,这其中的前提和限制还是太多了。首先

-

本文向大家介绍python制作爬虫爬取京东商品评论教程,包括了python制作爬虫爬取京东商品评论教程的使用技巧和注意事项,需要的朋友参考一下 本篇文章是python爬虫系列的第三篇,介绍如何抓取京东商城商品评论信息,并对这些评论信息进行分析和可视化。下面是要抓取的商品信息,一款女士文胸。这个商品共有红色,黑色和肤色三种颜色, 70B到90D共18个尺寸,以及超过700条的购买评论。 京东商品评论

-

本文向大家介绍Python爬取网易云音乐热门评论,包括了Python爬取网易云音乐热门评论的使用技巧和注意事项,需要的朋友参考一下 最近在研究文本挖掘相关的内容,所谓巧妇难为无米之炊,要想进行文本分析,首先得到有文本吧。获取文本的方式有很多,比如从网上下载现成的文本文档,或者通过第三方提供的API进行获取数据。但是有的时候我们想要的数据并不能直接获取,因为并不提供直接的下载渠道或者API供我们获取

-

本文向大家介绍python实现模拟器爬取抖音评论数据的示例代码,包括了python实现模拟器爬取抖音评论数据的示例代码的使用技巧和注意事项,需要的朋友参考一下 目标: 由于之前和朋友聊到抖音评论的爬虫,demo做出来之后一直没整理,最近时间充裕后,在这里做个笔记。 提示:大体思路 通过fiddle + app模拟器进行抖音抓包,使用python进行数据整理 安装需要的工具: python3 下载